You are viewing a plain text version of this content. The canonical link for it is here.

Posted to commits@iotdb.apache.org by ha...@apache.org on 2023/03/01 10:02:11 UTC

[iotdb] branch master updated: feat(site): image move to site (#9182)

This is an automated email from the ASF dual-hosted git repository.

haonan pushed a commit to branch master

in repository https://gitbox.apache.org/repos/asf/iotdb.git

The following commit(s) were added to refs/heads/master by this push:

new 8c65fbb343 feat(site): image move to site (#9182)

8c65fbb343 is described below

commit 8c65fbb343f8273cc56a5955eb6d156d2dfb168b

Author: CritasWang <cr...@outlook.com>

AuthorDate: Wed Mar 1 18:01:59 2023 +0800

feat(site): image move to site (#9182)

---

docs/UserGuide/API/InfluxDB-Protocol.md | 10 +-

docs/UserGuide/API/Programming-JDBC.md | 2 +-

docs/UserGuide/API/Programming-MQTT.md | 6 +-

.../UserGuide/API/Programming-Python-Native-API.md | 2 +-

docs/UserGuide/Cluster/Cluster-Concept.md | 4 +-

docs/UserGuide/Cluster/Cluster-Maintenance.md | 2 +-

.../Data-Concept/Data-Model-and-Terminology.md | 4 +-

docs/UserGuide/Data-Concept/Schema-Template.md | 6 +-

docs/UserGuide/Data-Concept/Time-Partition.md | 2 +-

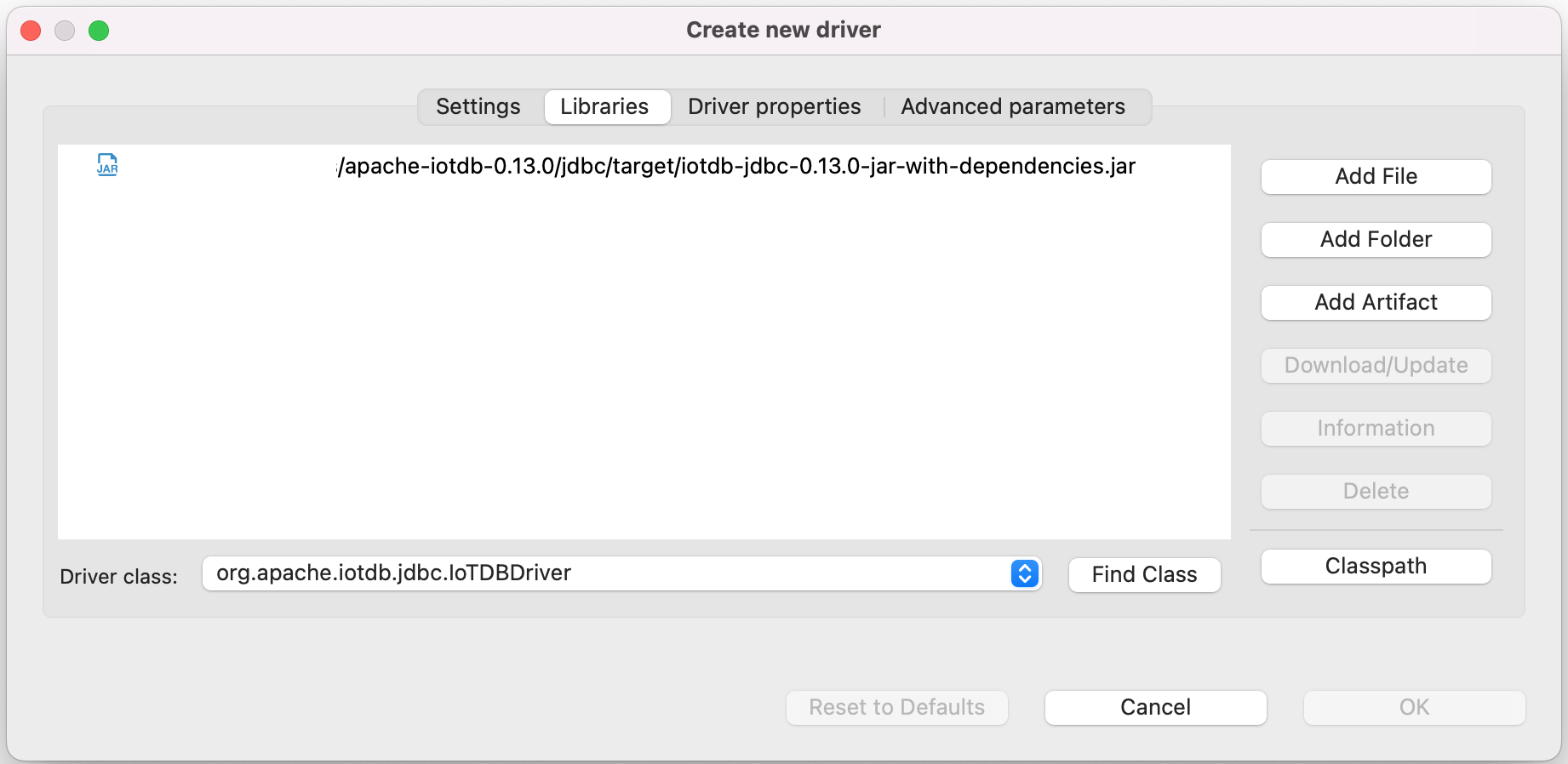

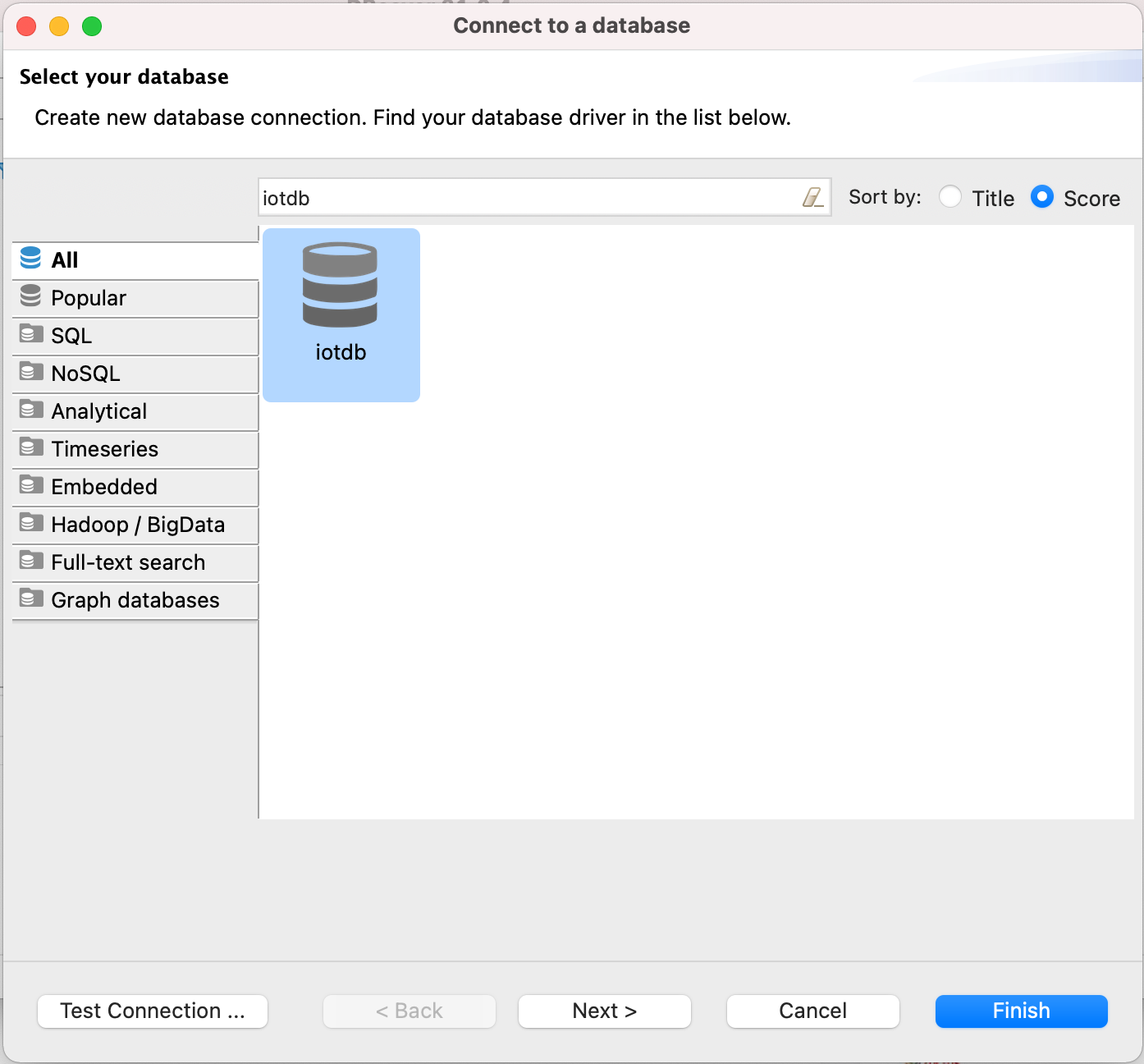

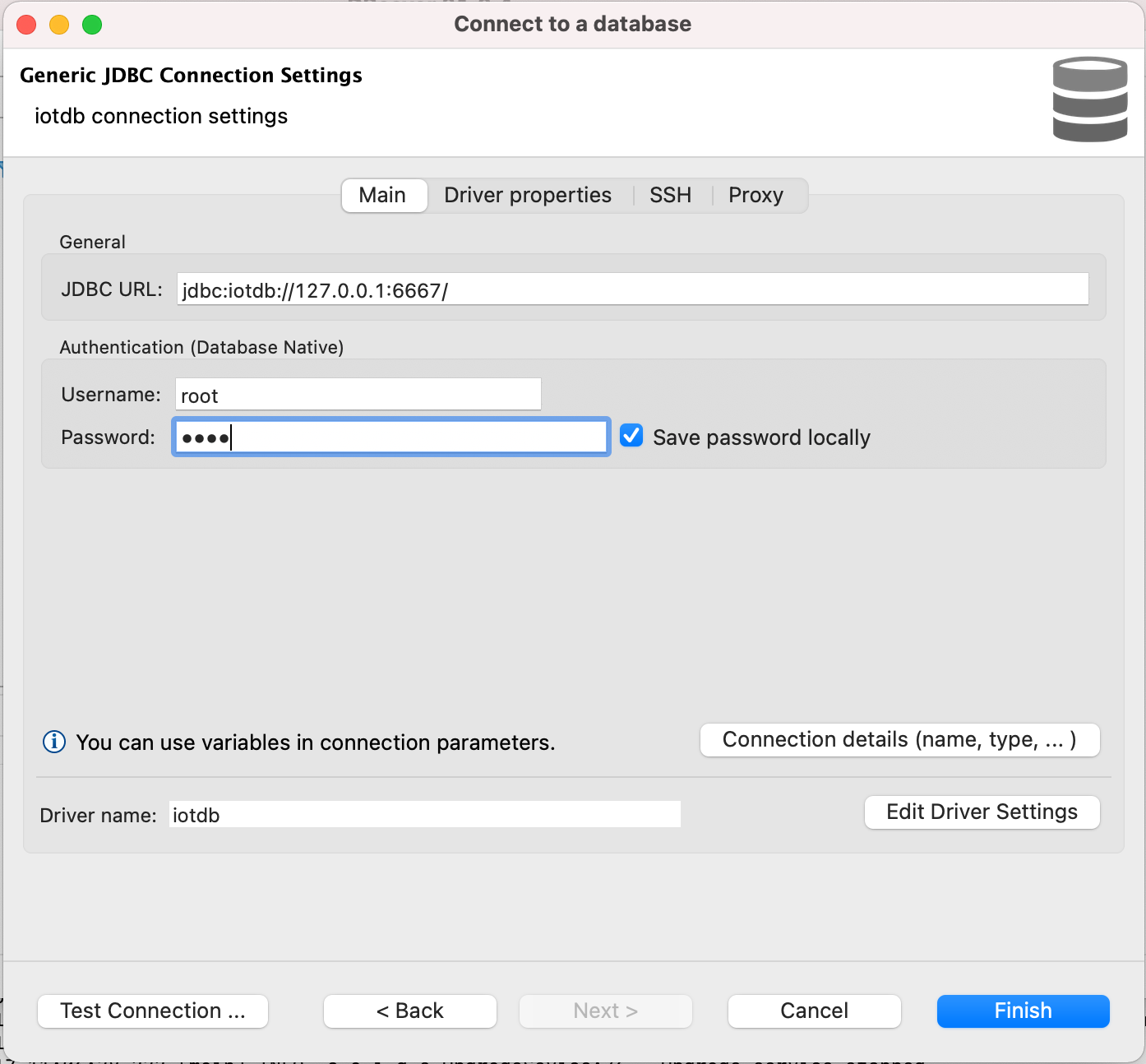

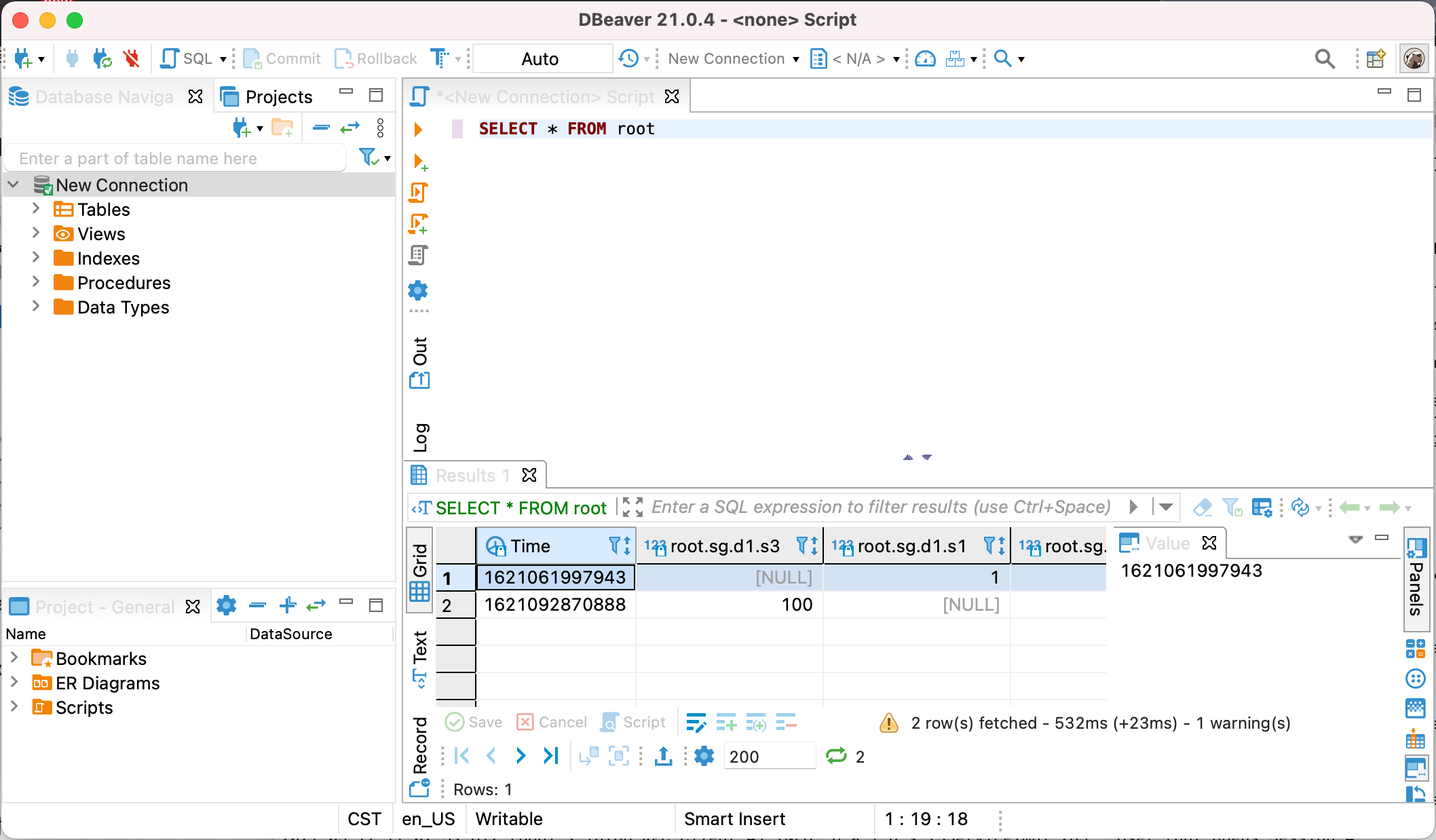

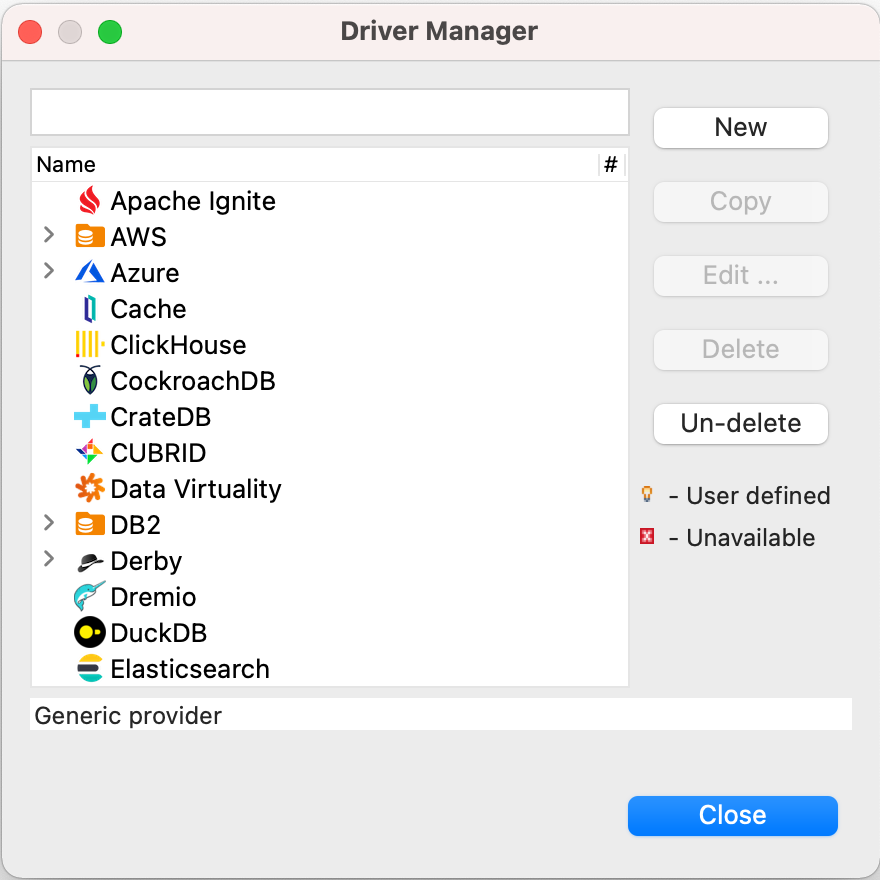

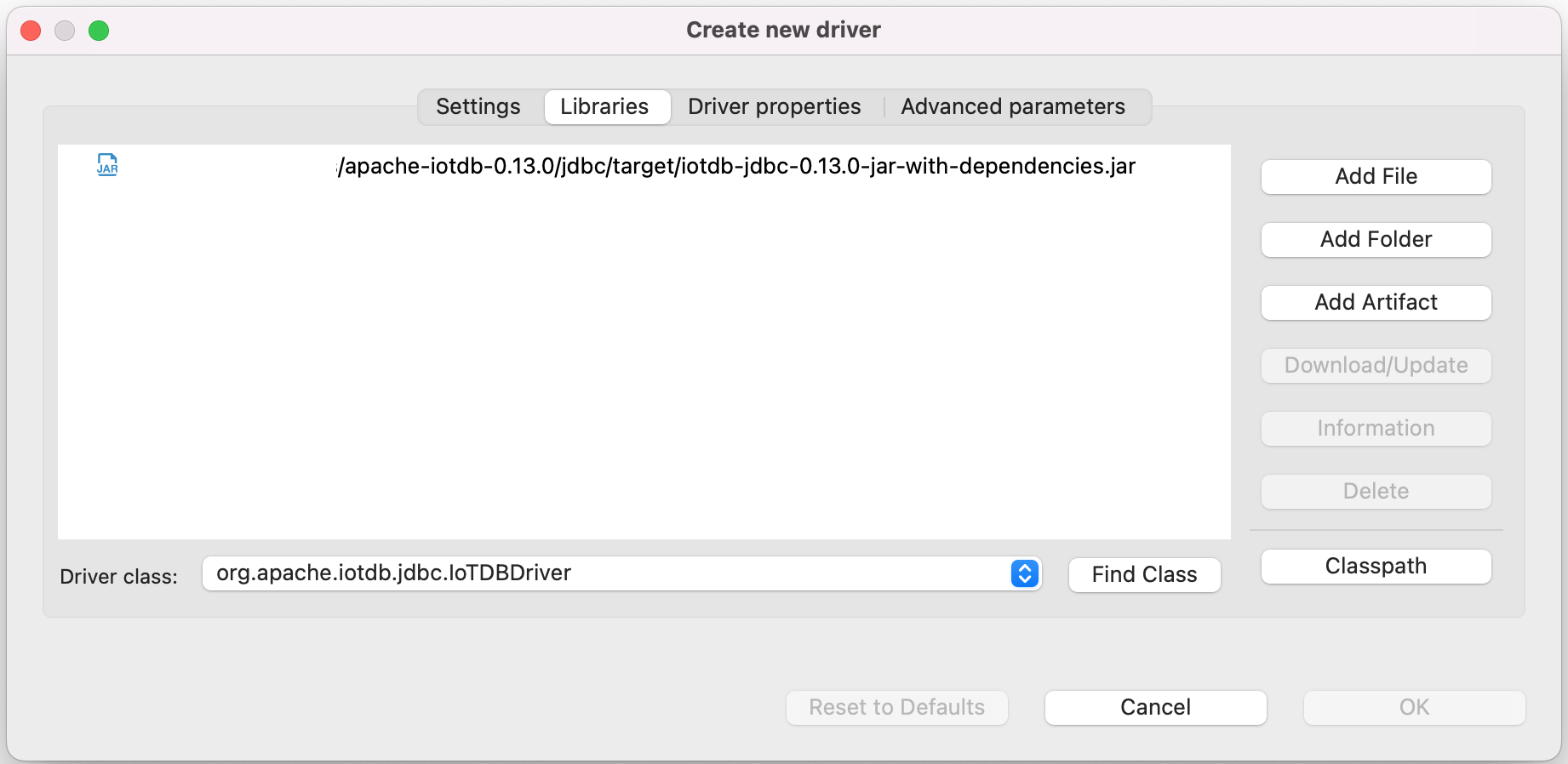

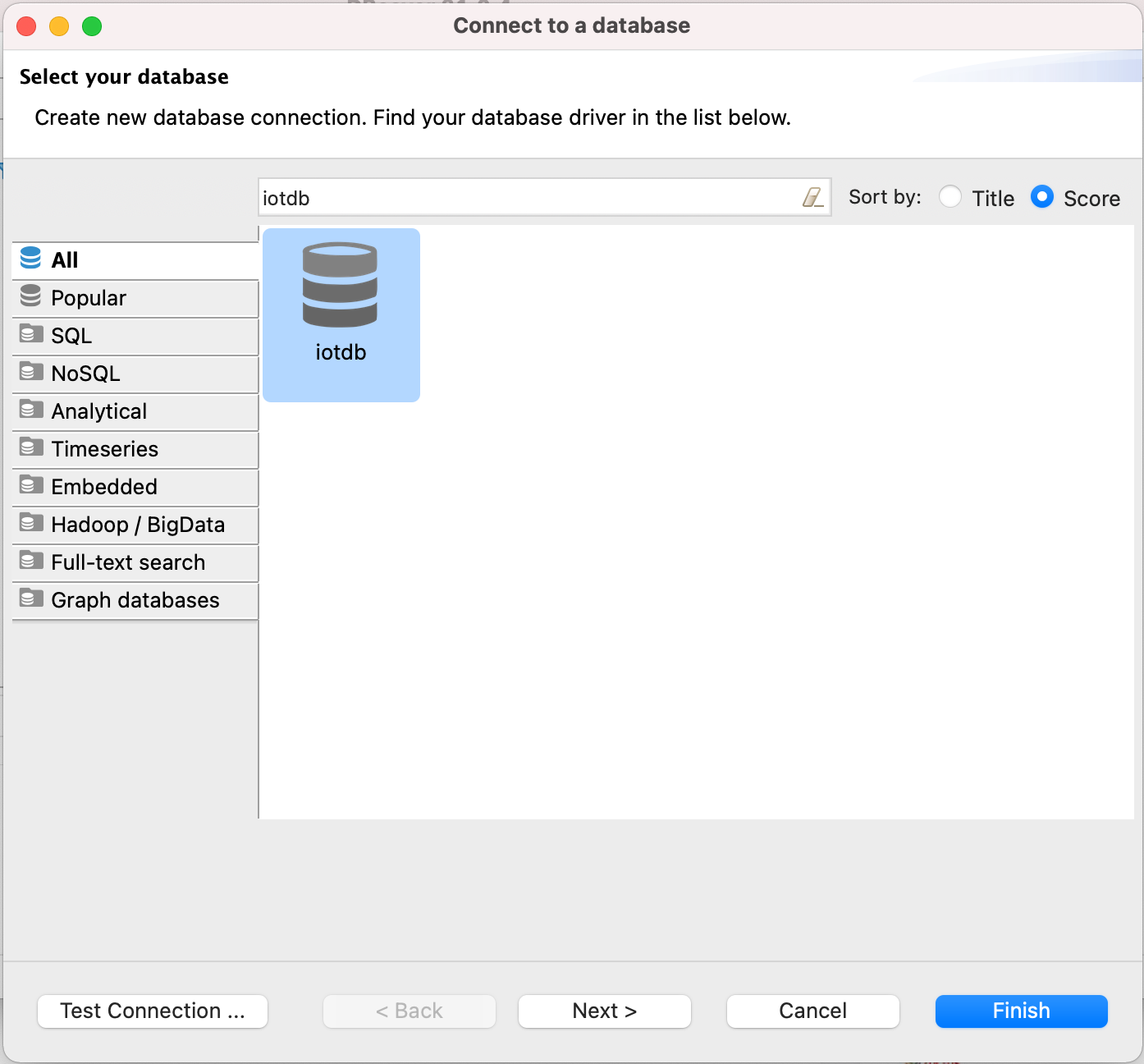

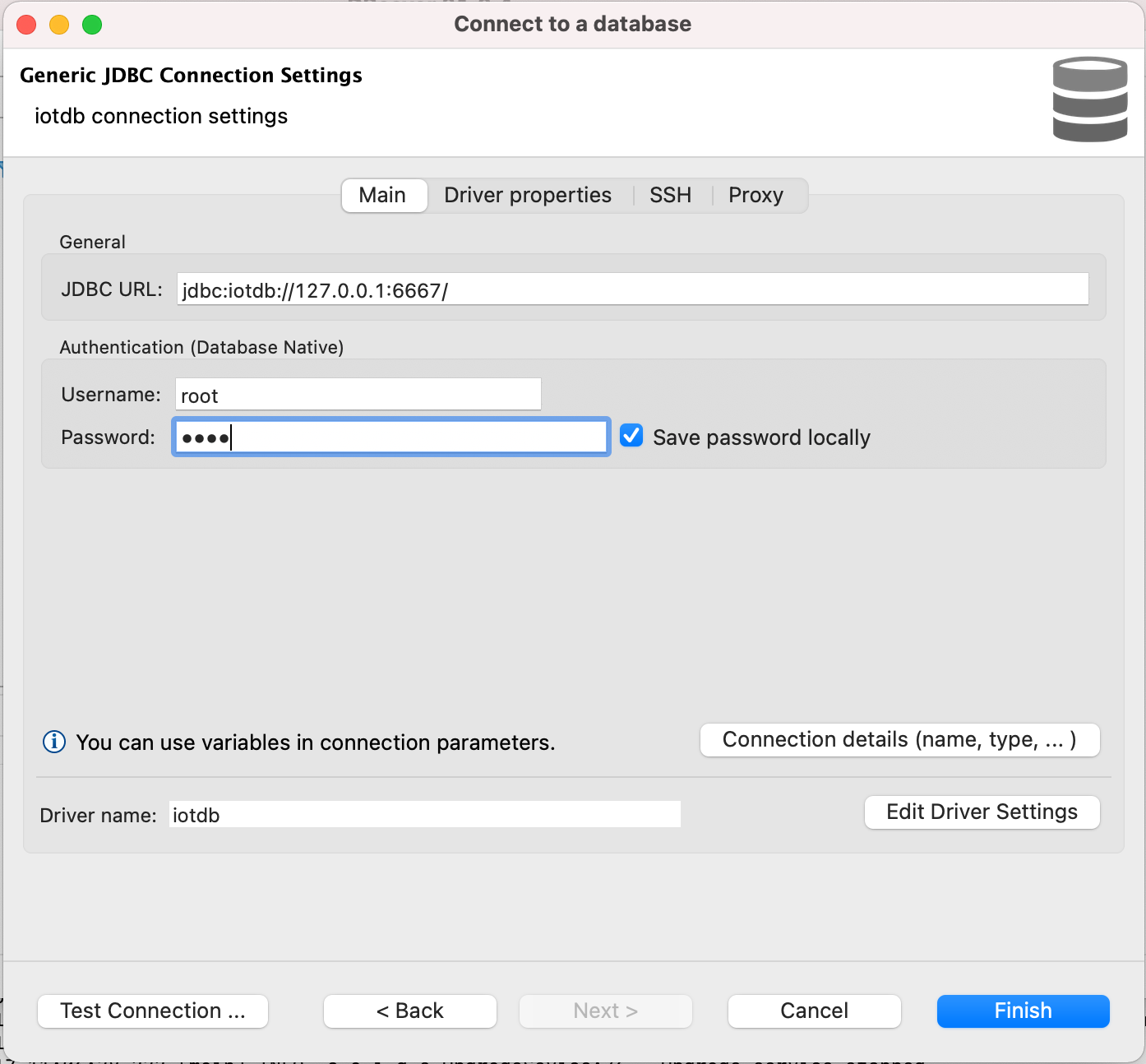

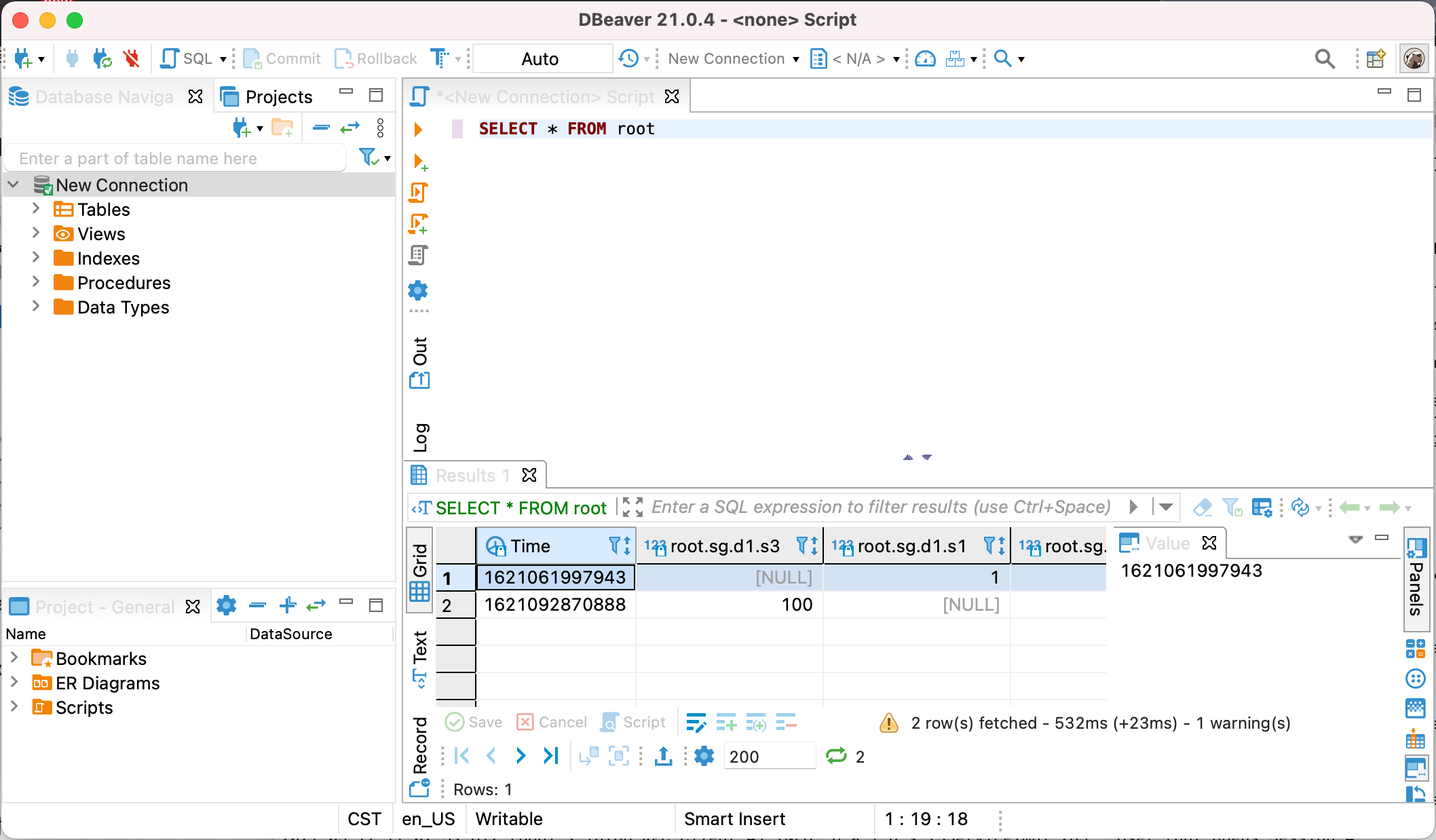

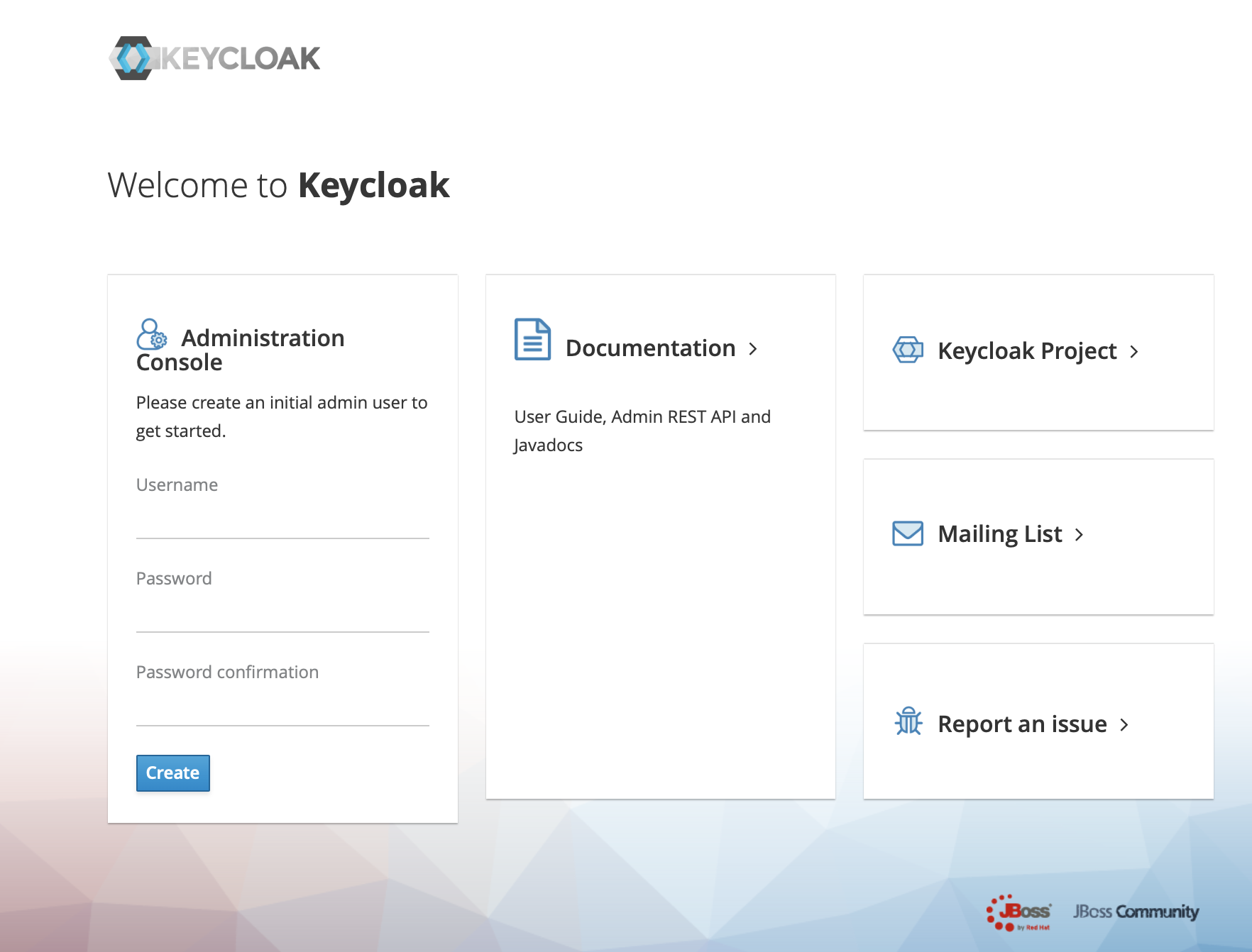

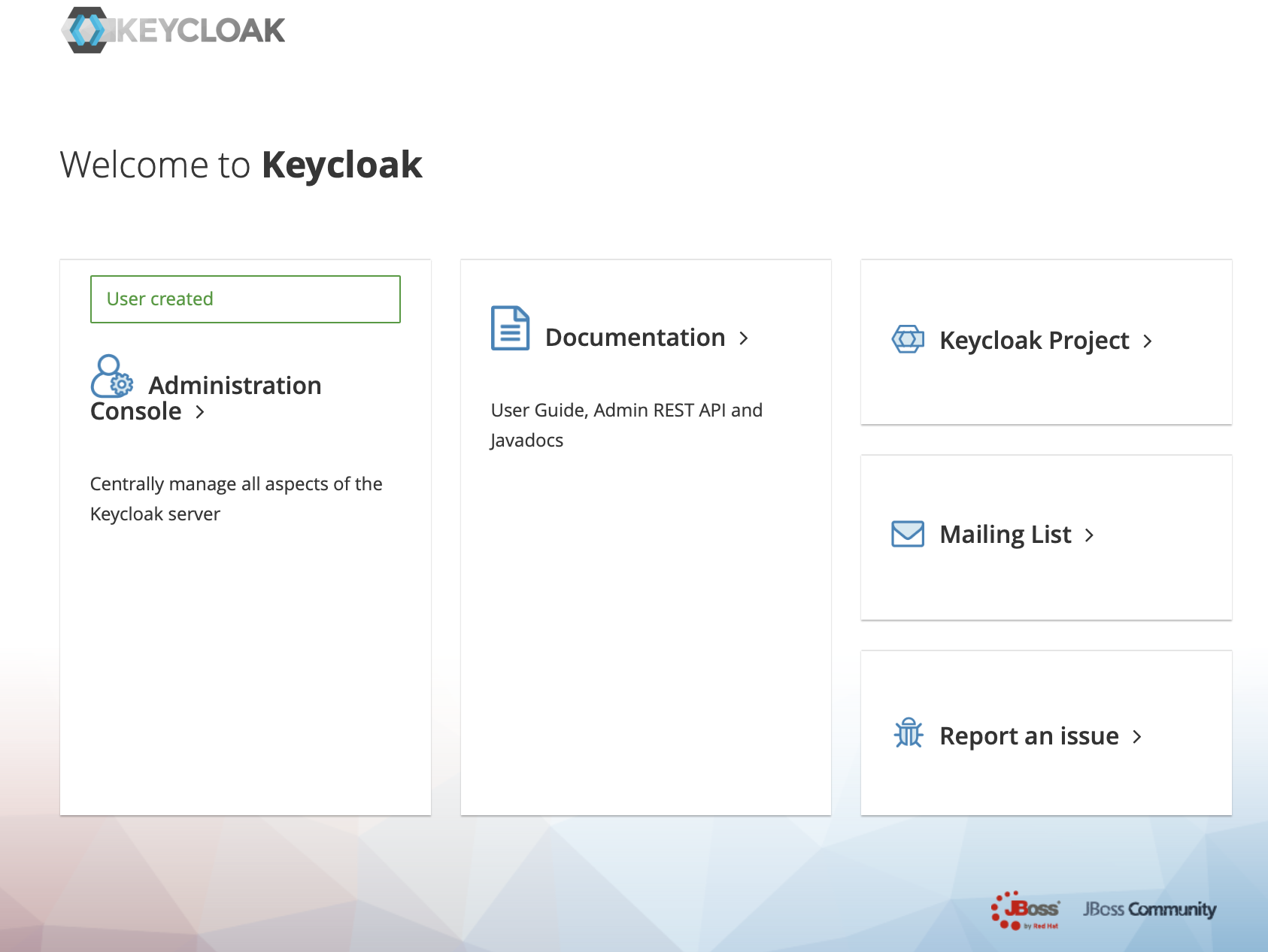

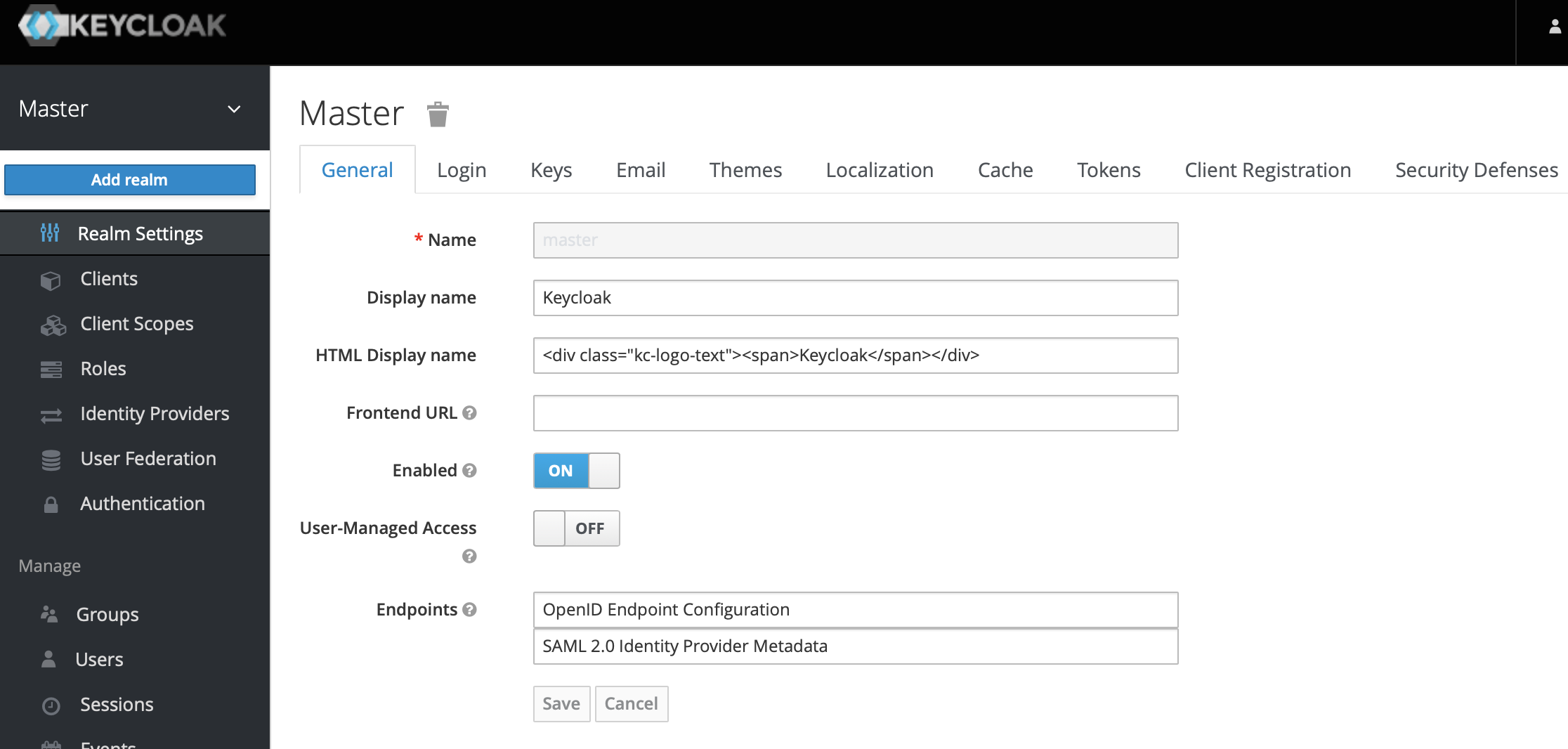

docs/UserGuide/Ecosystem-Integration/DBeaver.md | 16 +-

.../Ecosystem-Integration/Grafana-Connector.md | 6 +-

.../Ecosystem-Integration/Grafana-Plugin.md | 58 +--

docs/UserGuide/Ecosystem-Integration/NiFi-IoTDB.md | 2 +-

.../UserGuide/Ecosystem-Integration/Spark-IoTDB.md | 2 +-

.../Ecosystem-Integration/Spark-TsFile.md | 4 +-

.../Ecosystem-Integration/Writing-Data-on-HDFS.md | 2 +-

.../Ecosystem-Integration/Zeppelin-IoTDB.md | 8 +-

.../Edge-Cloud-Collaboration/Sync-Tool.md | 4 +-

.../Integration-Test-refactoring-tutorial.md | 4 +-

docs/UserGuide/IoTDB-Introduction/Architecture.md | 2 +-

docs/UserGuide/IoTDB-Introduction/Scenario.md | 14 +-

docs/UserGuide/Maintenance-Tools/JMX-Tool.md | 4 +-

docs/UserGuide/Maintenance-Tools/Log-Tool.md | 6 +-

.../Maintenance-Tools/Maintenance-Command.md | 8 +-

docs/UserGuide/Monitor-Alert/Alerting.md | 2 +-

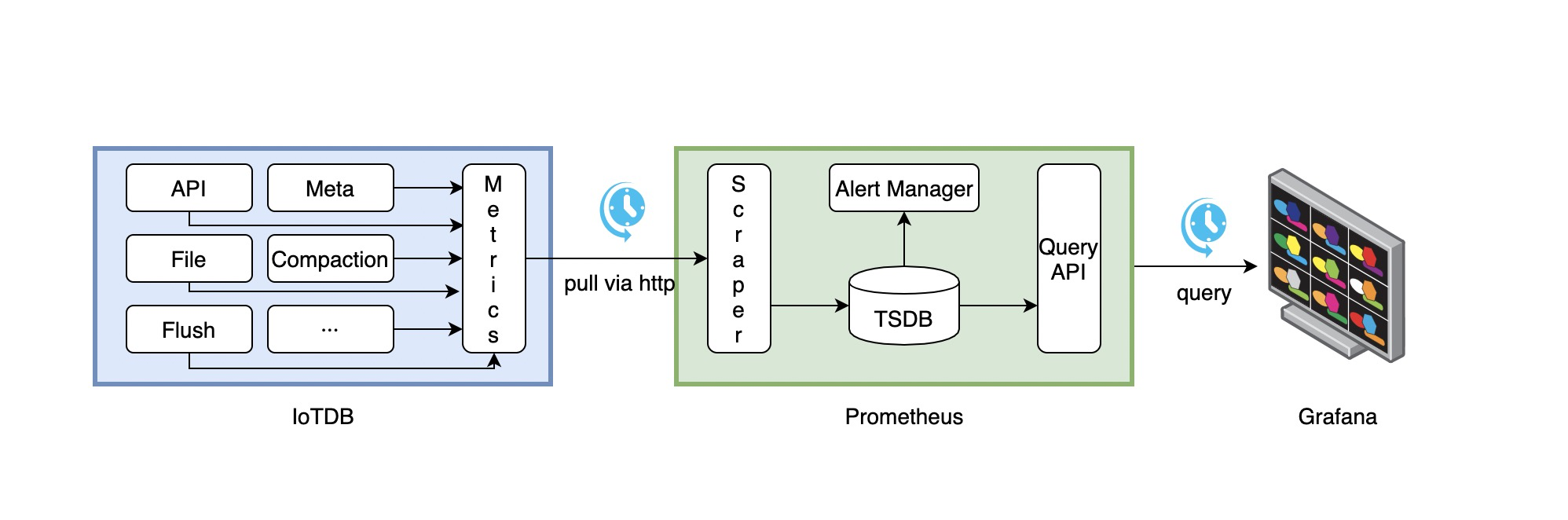

docs/UserGuide/Monitor-Alert/Metric-Tool.md | 10 +-

.../Operate-Metadata/Auto-Create-MetaData.md | 2 +-

docs/UserGuide/Operate-Metadata/Node.md | 2 +-

docs/UserGuide/Operate-Metadata/Timeseries.md | 2 +-

.../Operators-Functions/Continuous-Interval.md | 8 +-

docs/UserGuide/Operators-Functions/Sample.md | 10 +-

.../Operators-Functions/User-Defined-Function.md | 10 +-

docs/UserGuide/Query-Data/Continuous-Query.md | 8 +-

docs/UserGuide/Query-Data/Group-By.md | 6 +-

docs/UserGuide/Query-Data/Overview.md | 2 +-

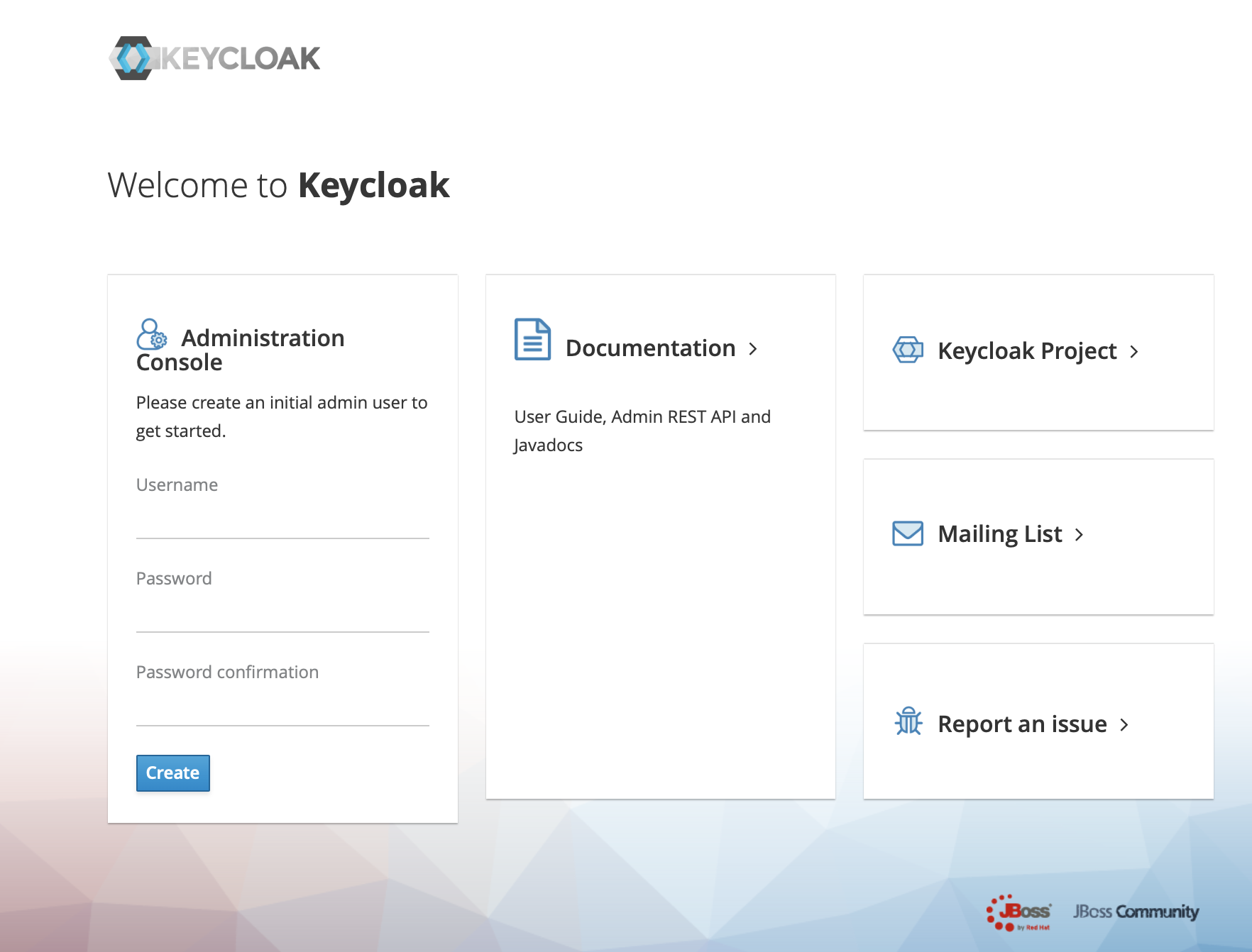

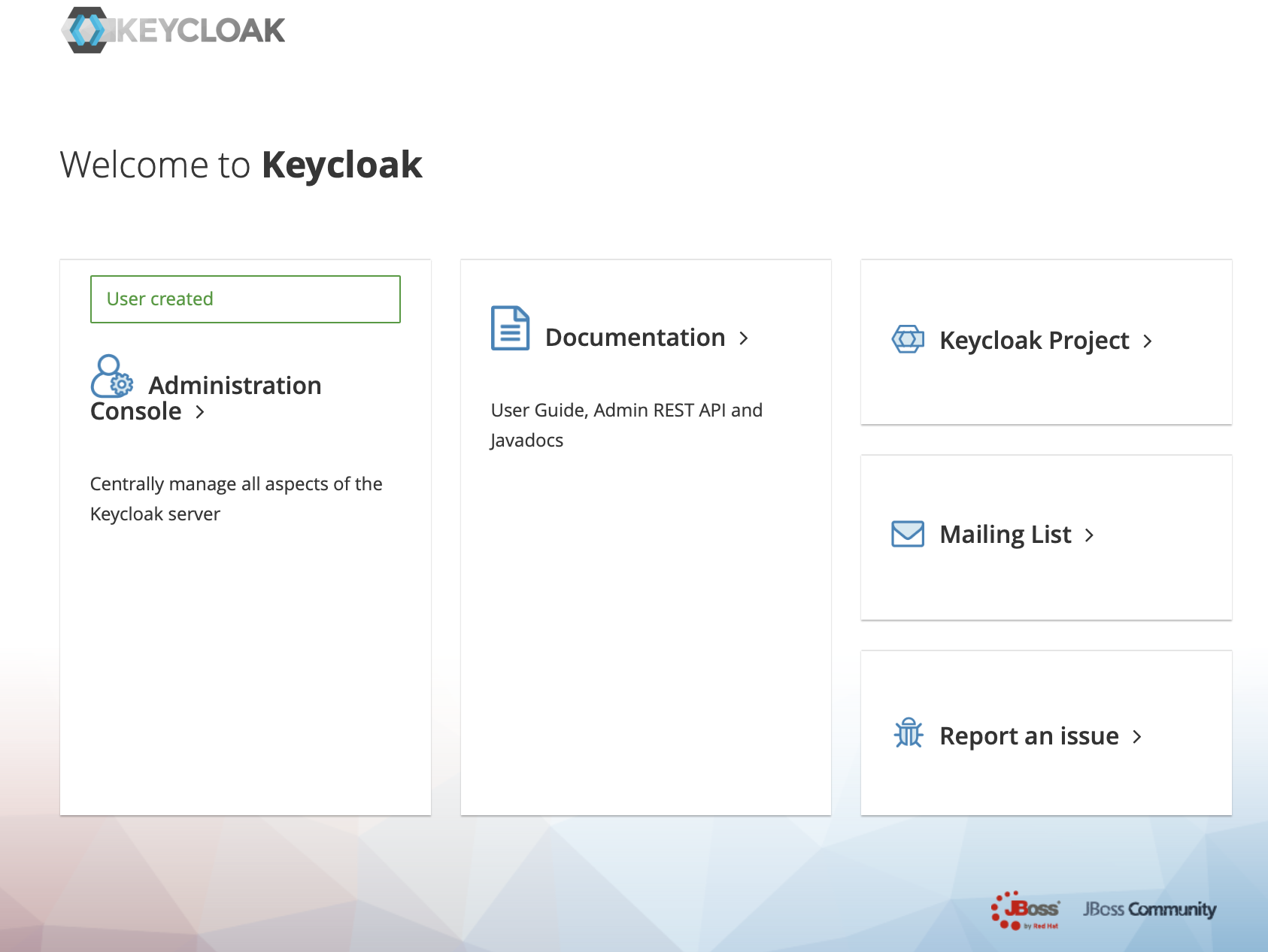

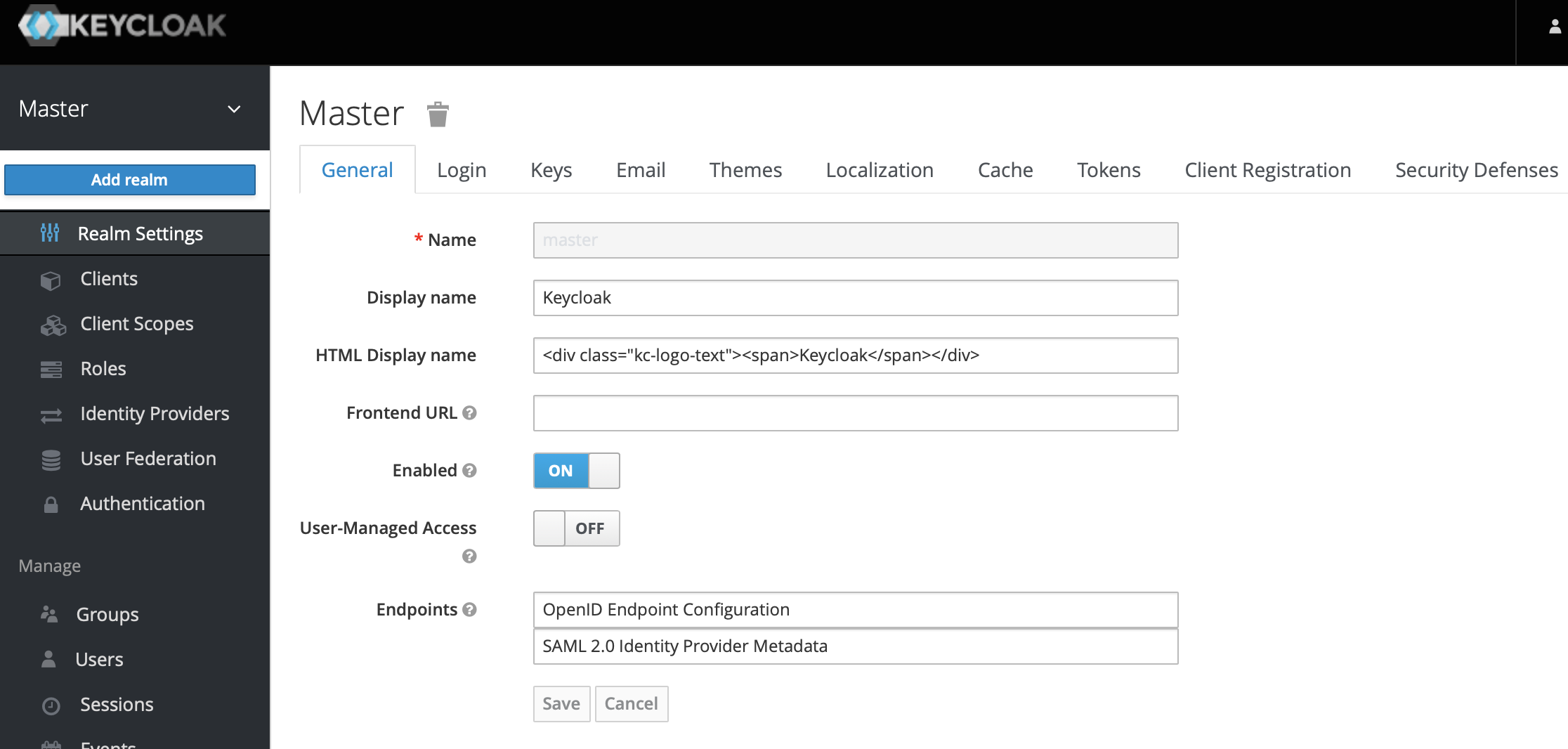

.../UserGuide/QuickStart/Command-Line-Interface.md | 28 +-

docs/UserGuide/QuickStart/QuickStart.md | 2 +-

docs/UserGuide/Reference/Common-Config-Manual.md | 13 +-

docs/UserGuide/Reference/SQL-Reference.md | 4 +-

docs/UserGuide/Reference/TSDB-Comparison.md | 16 +-

docs/UserGuide/Syntax-Conventions/Identifier.md | 2 +-

docs/UserGuide/Syntax-Conventions/KeyValue-Pair.md | 4 +-

.../UserGuide/Syntax-Conventions/Literal-Values.md | 10 +-

.../Syntax-Conventions/NodeName-In-Path.md | 12 +-

.../Syntax-Conventions/Session-And-TsFile-API.md | 18 +-

docs/UserGuide/UserGuideReadme.md | 5 +-

docs/UserGuide/Write-Data/Batch-Load-Tool.md | 2 +-

docs/zh/UserGuide/API/InfluxDB-Protocol.md | 10 +-

docs/zh/UserGuide/API/Interface-Comparison.md | 2 +-

.../zh/UserGuide/API/Programming-Cpp-Native-API.md | 40 +-

docs/zh/UserGuide/API/Programming-JDBC.md | 2 +-

.../UserGuide/API/Programming-Java-Native-API.md | 48 +-

docs/zh/UserGuide/API/Programming-MQTT.md | 4 +-

.../UserGuide/API/Programming-Python-Native-API.md | 78 ++--

docs/zh/UserGuide/Cluster/Cluster-Concept.md | 6 +-

docs/zh/UserGuide/Cluster/Cluster-Maintenance.md | 30 +-

docs/zh/UserGuide/Cluster/Cluster-Setup.md | 58 +--

.../UserGuide/Cluster/Deployment-Recommendation.md | 26 +-

docs/zh/UserGuide/Data-Concept/Compression.md | 6 +-

.../Data-Concept/Data-Model-and-Terminology.md | 4 +-

docs/zh/UserGuide/Data-Concept/Data-Type.md | 14 +-

docs/zh/UserGuide/Data-Concept/Deadband-Process.md | 4 +-

docs/zh/UserGuide/Data-Concept/Encoding.md | 6 +-

docs/zh/UserGuide/Data-Concept/Schema-Template.md | 16 +-

docs/zh/UserGuide/Data-Concept/Time-Partition.md | 10 +-

docs/zh/UserGuide/Data-Concept/Time-zone.md | 4 +-

docs/zh/UserGuide/Data-Modeling/DataRegion.md | 8 +-

.../Data-Modeling/SchemaRegion-rocksdb.md | 8 +-

docs/zh/UserGuide/Delete-Data/TTL.md | 8 +-

docs/zh/UserGuide/Ecosystem-Integration/DBeaver.md | 16 +-

.../Ecosystem-Integration/Grafana-Connector.md | 6 +-

.../Ecosystem-Integration/Grafana-Plugin.md | 98 ++--

.../UserGuide/Ecosystem-Integration/NiFi-IoTDB.md | 22 +-

.../Ecosystem-Integration/Writing-Data-on-HDFS.md | 2 +-

.../Ecosystem-Integration/Zeppelin-IoTDB.md | 8 +-

.../Edge-Cloud-Collaboration/Sync-Tool.md | 2 +-

docs/zh/UserGuide/FAQ/FAQ-for-cluster-setup.md | 36 +-

.../Integration-Test-refactoring-tutorial.md | 4 +-

.../UserGuide/IoTDB-Introduction/Architecture.md | 2 +-

docs/zh/UserGuide/IoTDB-Introduction/Scenario.md | 14 +-

docs/zh/UserGuide/Maintenance-Tools/CSV-Tool.md | 24 +-

.../IoTDB-Data-Dir-Overview-Tool.md | 6 +-

docs/zh/UserGuide/Maintenance-Tools/JMX-Tool.md | 8 +-

docs/zh/UserGuide/Maintenance-Tools/Load-Tsfile.md | 14 +-

docs/zh/UserGuide/Maintenance-Tools/Log-Tool.md | 6 +-

.../Maintenance-Tools/TsFile-Load-Export-Tool.md | 24 +-

.../TsFile-Resource-Sketch-Tool.md | 6 +-

.../Maintenance-Tools/TsFile-Sketch-Tool.md | 6 +-

.../Maintenance-Tools/TsFile-Split-Tool.md | 2 +-

.../Maintenance-Tools/TsFileSelfCheck-Tool.md | 4 +-

docs/zh/UserGuide/Monitor-Alert/Alerting.md | 26 +-

docs/zh/UserGuide/Monitor-Alert/Metric-Tool.md | 9 +-

.../Operate-Metadata/Auto-Create-MetaData.md | 12 +-

docs/zh/UserGuide/Operate-Metadata/Database.md | 11 +-

docs/zh/UserGuide/Operate-Metadata/Node.md | 14 +-

docs/zh/UserGuide/Operate-Metadata/Template.md | 16 +-

docs/zh/UserGuide/Operate-Metadata/Timeseries.md | 16 +-

.../UserGuide/Operators-Functions/Aggregation.md | 14 +-

.../Operators-Functions/Anomaly-Detection.md | 56 +--

.../zh/UserGuide/Operators-Functions/Comparison.md | 18 +-

docs/zh/UserGuide/Operators-Functions/Constant.md | 2 +-

.../Operators-Functions/Continuous-Interval.md | 12 +-

.../zh/UserGuide/Operators-Functions/Conversion.md | 10 +-

.../UserGuide/Operators-Functions/Data-Matching.md | 32 +-

.../Operators-Functions/Data-Profiling.md | 170 +++----

.../UserGuide/Operators-Functions/Data-Quality.md | 48 +-

.../Operators-Functions/Data-Repairing.md | 48 +-

.../Operators-Functions/Frequency-Domain.md | 54 +--

docs/zh/UserGuide/Operators-Functions/Lambda.md | 8 +-

docs/zh/UserGuide/Operators-Functions/Logical.md | 6 +-

.../Operators-Functions/Machine-Learning.md | 10 +-

.../UserGuide/Operators-Functions/Mathematical.md | 12 +-

docs/zh/UserGuide/Operators-Functions/Overview.md | 12 +-

docs/zh/UserGuide/Operators-Functions/Sample.md | 50 +-

docs/zh/UserGuide/Operators-Functions/Selection.md | 2 +-

.../Operators-Functions/Series-Discovery.md | 18 +-

docs/zh/UserGuide/Operators-Functions/String.md | 98 ++--

.../UserGuide/Operators-Functions/Time-Series.md | 8 +-

.../Operators-Functions/User-Defined-Function.md | 62 +--

.../Operators-Functions/Variation-Trend.md | 10 +-

docs/zh/UserGuide/Query-Data/Align-By.md | 6 +-

docs/zh/UserGuide/Query-Data/Continuous-Query.md | 60 +--

docs/zh/UserGuide/Query-Data/Fill.md | 14 +-

docs/zh/UserGuide/Query-Data/Group-By.md | 48 +-

docs/zh/UserGuide/Query-Data/Having-Condition.md | 2 +-

docs/zh/UserGuide/Query-Data/Last-Query.md | 2 +-

docs/zh/UserGuide/Query-Data/Order-By.md | 6 +-

docs/zh/UserGuide/Query-Data/Overview.md | 47 +-

docs/zh/UserGuide/Query-Data/Pagination.md | 6 +-

docs/zh/UserGuide/Query-Data/Select-Expression.md | 22 +-

docs/zh/UserGuide/Query-Data/Select-Into.md | 44 +-

docs/zh/UserGuide/Query-Data/Where-Condition.md | 12 +-

docs/zh/UserGuide/QuickStart/ClusterQuickStart.md | 20 +-

.../UserGuide/QuickStart/Command-Line-Interface.md | 26 +-

docs/zh/UserGuide/QuickStart/Files.md | 32 +-

docs/zh/UserGuide/QuickStart/QuickStart.md | 2 +-

docs/zh/UserGuide/QuickStart/ServerFileList.md | 30 +-

.../zh/UserGuide/Reference/Common-Config-Manual.md | 52 ++-

.../Reference/ConfigNode-Config-Manual.md | 18 +-

.../UserGuide/Reference/DataNode-Config-Manual.md | 20 +-

docs/zh/UserGuide/Reference/Keywords.md | 2 +-

docs/zh/UserGuide/Reference/SQL-Reference.md | 26 +-

docs/zh/UserGuide/Reference/Status-Codes.md | 2 +-

docs/zh/UserGuide/Reference/TSDB-Comparison.md | 44 +-

.../Syntax-Conventions/Detailed-Grammar.md | 2 +-

docs/zh/UserGuide/Syntax-Conventions/Identifier.md | 10 +-

.../UserGuide/Syntax-Conventions/KeyValue-Pair.md | 2 +-

.../Keywords-And-Reserved-Words.md | 2 +-

.../UserGuide/Syntax-Conventions/Literal-Values.md | 17 +-

.../Syntax-Conventions/NodeName-In-Path.md | 6 +-

.../Syntax-Conventions/Session-And-TsFile-API.md | 2 +-

.../UserGuide/Trigger/Configuration-Parameters.md | 2 +-

docs/zh/UserGuide/Trigger/Implement-Trigger.md | 20 +-

docs/zh/UserGuide/Trigger/Instructions.md | 10 +-

docs/zh/UserGuide/Trigger/Notes.md | 2 +-

docs/zh/UserGuide/Trigger/Trigger-Management.md | 10 +-

docs/zh/UserGuide/UserGuideReadme.md | 7 +-

docs/zh/UserGuide/Write-Data/Batch-Load-Tool.md | 6 +-

docs/zh/UserGuide/Write-Data/MQTT.md | 2 +-

docs/zh/UserGuide/Write-Data/REST-API.md | 2 +-

docs/zh/UserGuide/Write-Data/Session.md | 4 +-

site/src/main/.vuepress/public/favicon.ico | Bin 0 -> 1595 bytes

site/src/main/.vuepress/public/img/IOTDB.png | Bin 0 -> 20818 bytes

.../TsFile/TsFile/tsFileVectorIndexCase5.png | Bin 0 -> 37197 bytes

.../TsFile/TsFile/tsFileVectorIndexCase6.png | Bin 0 -> 71207 bytes

.../TsFile/TsFile/tsFileVectorIndexCase7.png | Bin 0 -> 81847 bytes

.../API/IoTDB-InfluxDB/architecture-design.png | Bin 0 -> 145997 bytes

.../UserGuide/API/IoTDB-InfluxDB/class-diagram.png | Bin 0 -> 16881 bytes

.../UserGuide/API/IoTDB-InfluxDB/influxdb-data.png | Bin 0 -> 59411 bytes

.../API/IoTDB-InfluxDB/influxdb-vs-iotdb-data.png | Bin 0 -> 202016 bytes

.../UserGuide/API/IoTDB-InfluxDB/iotdb-data.png | Bin 0 -> 53434 bytes

.../API/IoTDB-SQLAlchemy/sqlalchemy-to-iotdb.png | Bin 0 -> 173461 bytes

.../AdministrationConsole.png | Bin 0 -> 197363 bytes

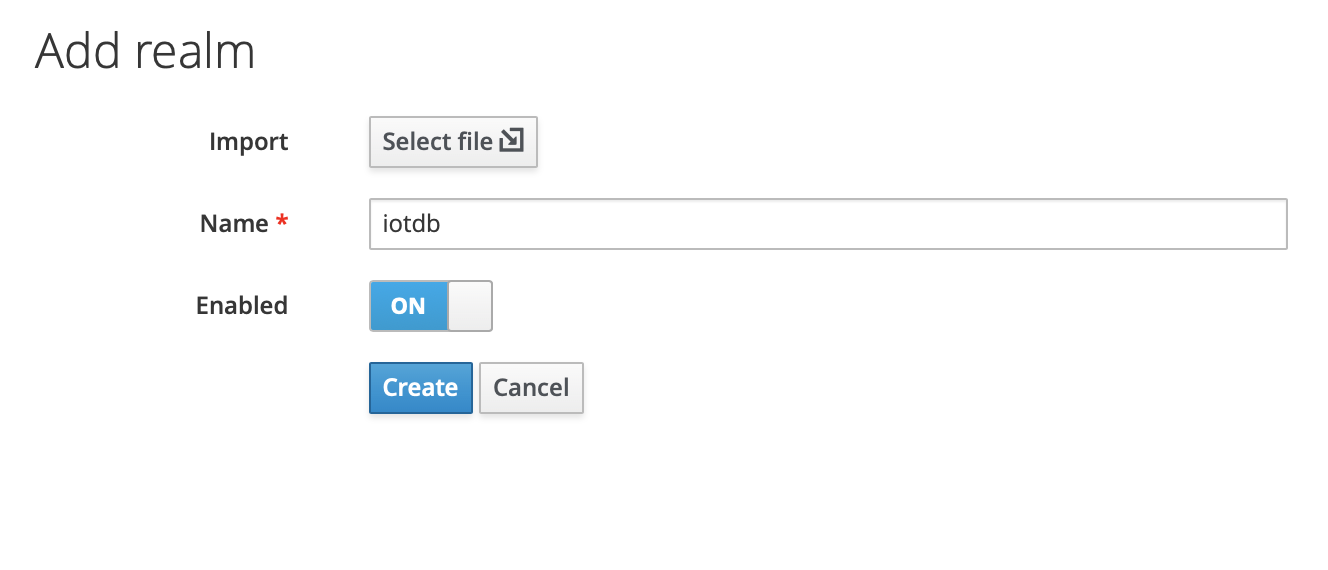

.../CLI/Command-Line-Interface/add_Realm_1.png | Bin 0 -> 212253 bytes

.../CLI/Command-Line-Interface/add_Realm_2.png | Bin 0 -> 49422 bytes

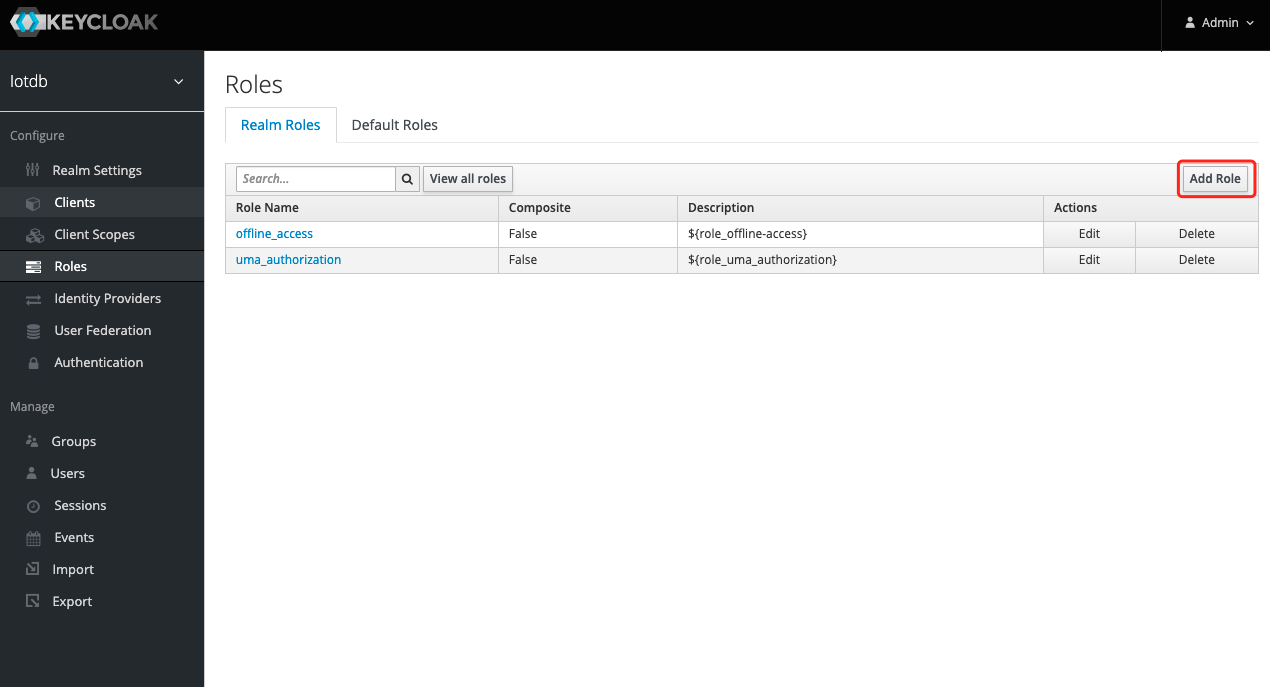

.../CLI/Command-Line-Interface/add_role1.png | Bin 0 -> 79274 bytes

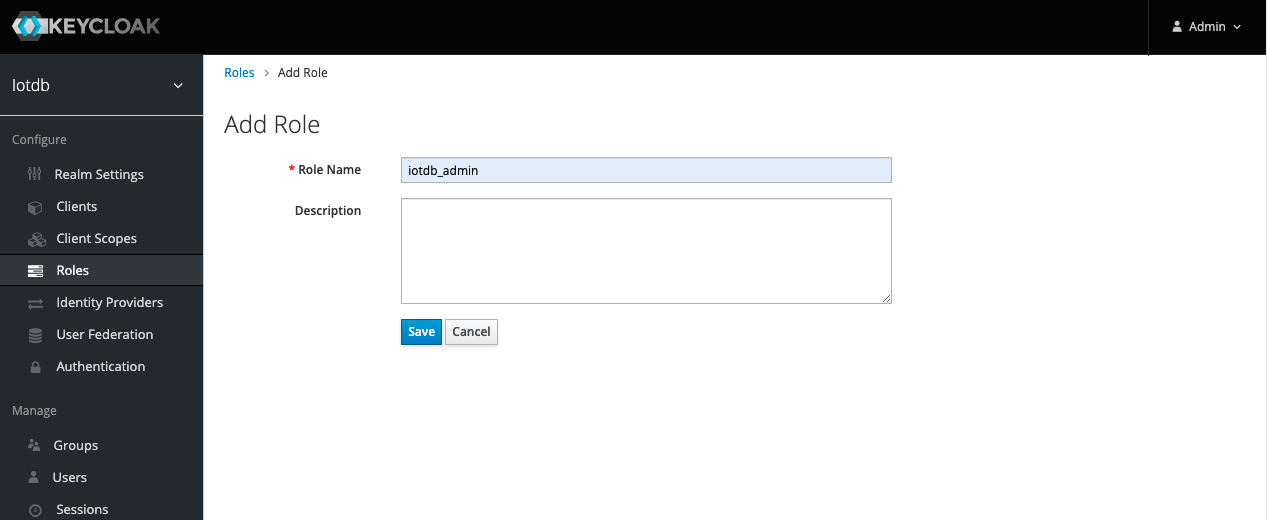

.../CLI/Command-Line-Interface/add_role2.png | Bin 0 -> 55567 bytes

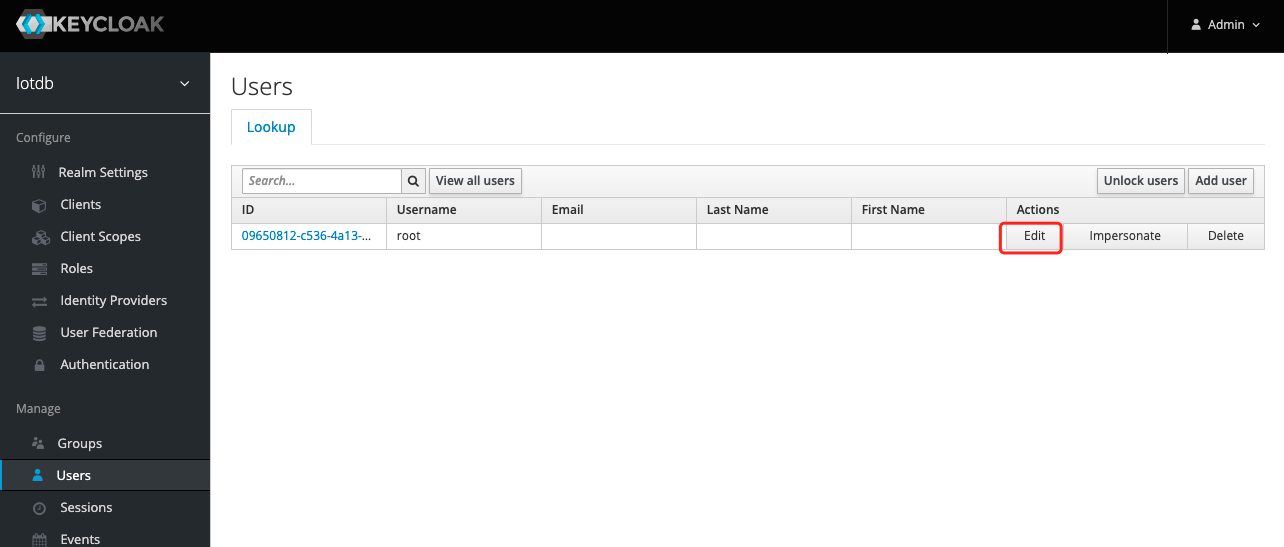

.../CLI/Command-Line-Interface/add_role3.png | Bin 0 -> 67423 bytes

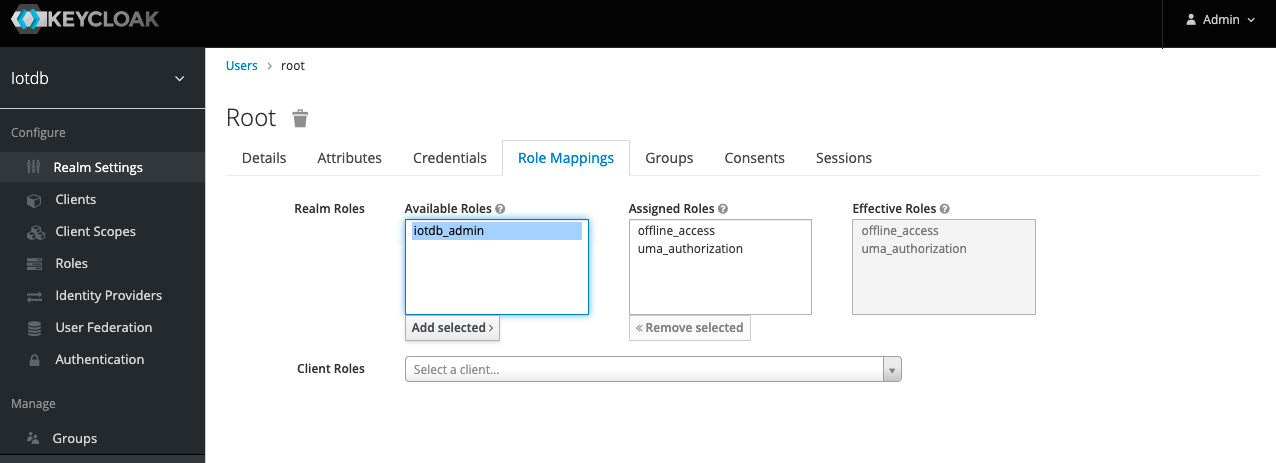

.../CLI/Command-Line-Interface/add_role4.png | Bin 0 -> 73825 bytes

.../CLI/Command-Line-Interface/add_role5.png | Bin 0 -> 82391 bytes

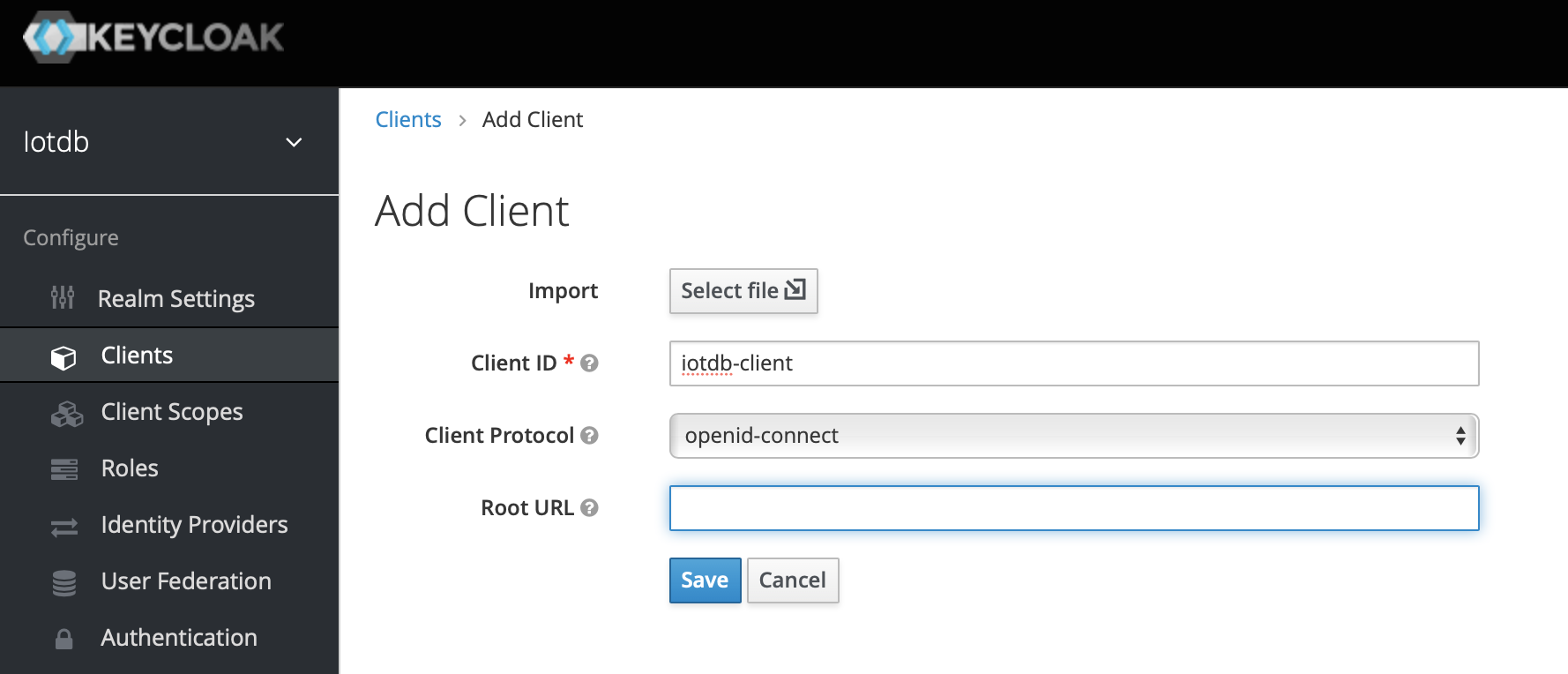

.../CLI/Command-Line-Interface/client.png | Bin 0 -> 132520 bytes

.../CLI/Command-Line-Interface/login_keycloak.png | Bin 0 -> 219950 bytes

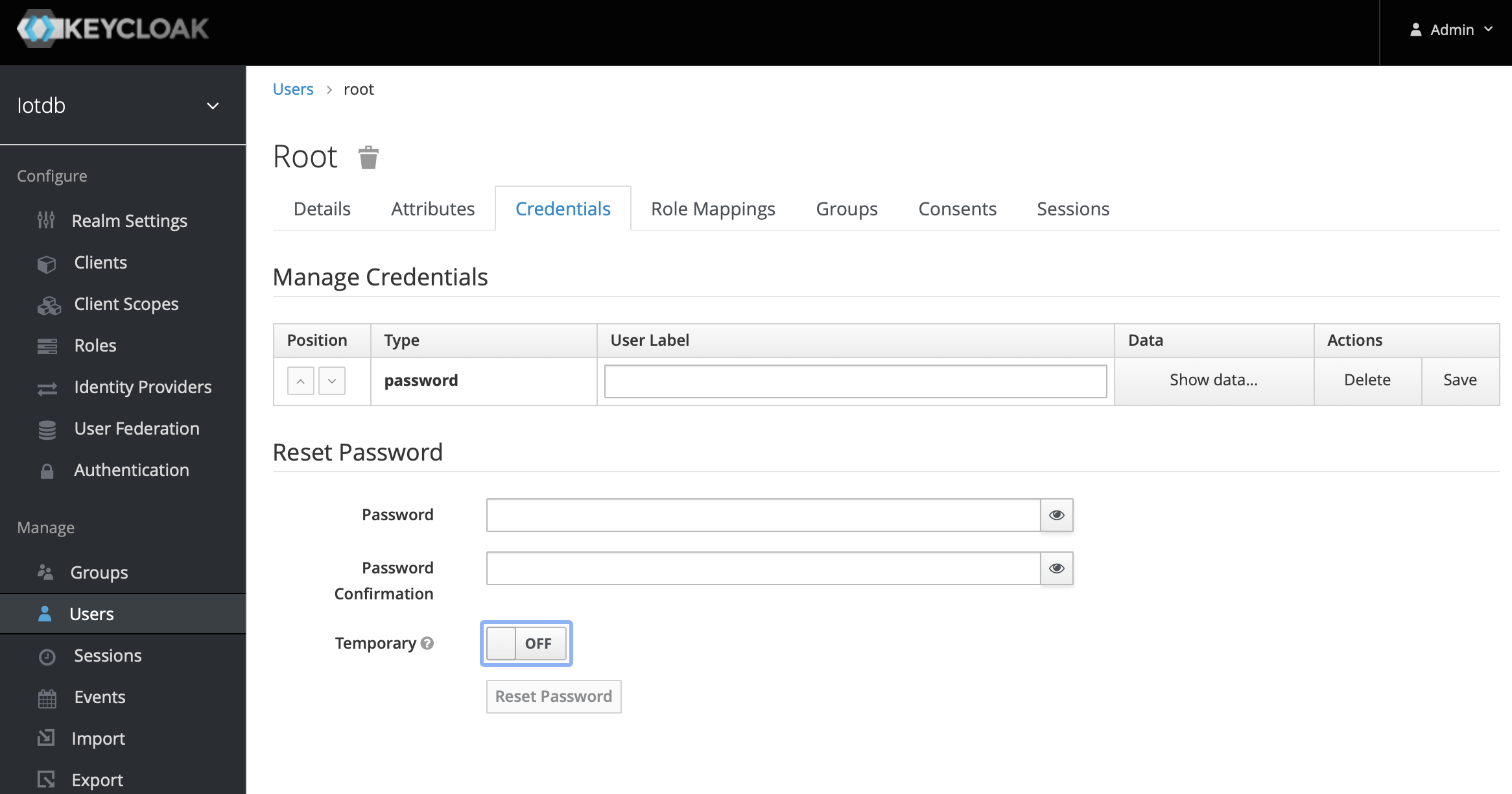

.../UserGuide/CLI/Command-Line-Interface/pwd.png | Bin 0 -> 235839 bytes

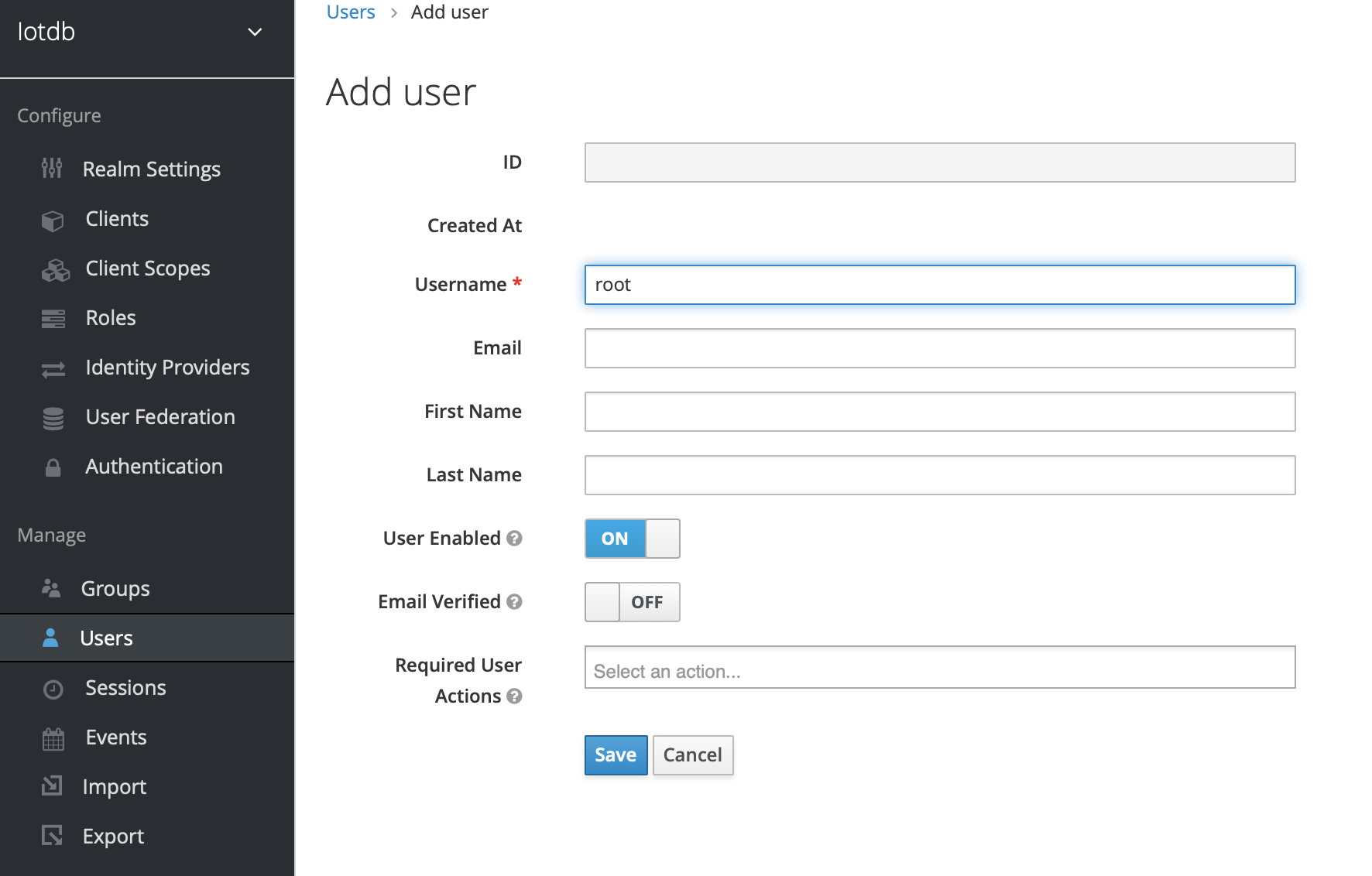

.../UserGuide/CLI/Command-Line-Interface/user.png | Bin 0 -> 167194 bytes

.../public/img/UserGuide/Cluster/Architecture.png | Bin 0 -> 55767 bytes

.../img/UserGuide/Cluster/Data-Partition.png | Bin 0 -> 106930 bytes

.../UserGuide/Cluster/DataNode-StateMachine-EN.jpg | Bin 0 -> 70582 bytes

.../UserGuide/Cluster/DataNode-StateMachine-ZH.jpg | Bin 0 -> 66988 bytes

.../img/UserGuide/Cluster/Preview1-Function.png | Bin 0 -> 256908 bytes

.../auto_create_sg_example.png | Bin 0 -> 81521 bytes

.../example_template_lifetime.png | Bin 0 -> 283522 bytes

.../example_template_lifetime_zh.png | Bin 0 -> 308440 bytes

.../Measurement-Template/example_with_template.png | Bin 0 -> 28982 bytes

.../example_without_template.png | Bin 0 -> 58632 bytes

.../Time-Partition/time_partition_example.png | Bin 0 -> 160113 bytes

.../UserGuide/Ecosystem-Integration/DBeaver/01.png | Bin 0 -> 163272 bytes

.../UserGuide/Ecosystem-Integration/DBeaver/02.png | Bin 0 -> 123947 bytes

.../UserGuide/Ecosystem-Integration/DBeaver/03.png | Bin 0 -> 144867 bytes

.../UserGuide/Ecosystem-Integration/DBeaver/04.png | Bin 0 -> 228587 bytes

.../UserGuide/Ecosystem-Integration/DBeaver/05.png | Bin 0 -> 198084 bytes

.../UserGuide/Ecosystem-Integration/DBeaver/06.png | Bin 0 -> 191463 bytes

.../UserGuide/Ecosystem-Integration/DBeaver/07.png | Bin 0 -> 222235 bytes

.../UserGuide/Ecosystem-Integration/DBeaver/08.png | Bin 0 -> 58150 bytes

.../UserGuide/Ecosystem-Integration/DBeaver/09.png | Bin 0 -> 350352 bytes

.../Grafana-plugin/add-empty-panel.png | Bin 0 -> 98208 bytes

.../Grafana-plugin/addvaribles.png | Bin 0 -> 196588 bytes

.../Grafana-plugin/alertPanel5.png | Bin 0 -> 42293 bytes

.../Grafana-plugin/alerting1.png | Bin 0 -> 103200 bytes

.../Grafana-plugin/alerting2.png | Bin 0 -> 44192 bytes

.../Grafana-plugin/alerting3.png | Bin 0 -> 119687 bytes

.../Grafana-plugin/alerting4.png | Bin 0 -> 130345 bytes

.../Grafana-plugin/alertpanel3.png | Bin 0 -> 250072 bytes

.../Grafana-plugin/alertpanel4.png | Bin 0 -> 85865 bytes

.../Grafana-plugin/alertpanel6.png | Bin 0 -> 164736 bytes

.../Grafana-plugin/alertpanle1.png | Bin 0 -> 333611 bytes

.../Grafana-plugin/alertpanle2.jpg | Bin 0 -> 137699 bytes

.../Grafana-plugin/applyvariables.png | Bin 0 -> 314991 bytes

.../Grafana-plugin/datasource_1.png | Bin 0 -> 275723 bytes

.../Grafana-plugin/datasource_2.png | Bin 0 -> 123473 bytes

.../Grafana-plugin/datasource_3.png | Bin 0 -> 167831 bytes

.../Grafana-plugin/distribution.png | Bin 0 -> 95592 bytes

.../Grafana-plugin/grafana-plugin-build.png | Bin 0 -> 48467 bytes

.../Grafana-plugin/grafana_input.png | Bin 0 -> 279162 bytes

.../Grafana-plugin/grafana_input2.png | Bin 0 -> 299017 bytes

.../Grafana-plugin/grafana_input_style.png | Bin 0 -> 268438 bytes

.../Grafana-plugin/manage.png | Bin 0 -> 224614 bytes

.../Grafana-plugin/setconf.png | Bin 0 -> 197642 bytes

.../Grafana-plugin/variablesinput3-1.png | Bin 0 -> 316272 bytes

.../Grafana-plugin/variablesinput3.png | Bin 0 -> 95470 bytes

.../Grafana-plugin/variblesinput.png | Bin 0 -> 92755 bytes

.../Grafana-plugin/variblesinput2-1.png | Bin 0 -> 94878 bytes

.../Grafana-plugin/variblesinput2-2.png | Bin 0 -> 326277 bytes

.../Grafana-plugin/variblesinput2.png | Bin 0 -> 92655 bytes

.../Architecture/Structure-of-Apache-IoTDB-cn.png | Bin 0 -> 126257 bytes

.../Architecture/Structure-of-Apache-IoTDB.png | Bin 0 -> 103140 bytes

.../public/img/UserGuide/OtherMaterial-Sample.Data | 516 +++++++++++++++++++++

.../Process-Data/Continuous-Query/pic1.png | Bin 0 -> 28418 bytes

.../Process-Data/Continuous-Query/pic2.png | Bin 0 -> 25023 bytes

.../Process-Data/Continuous-Query/pic3.png | Bin 0 -> 32982 bytes

.../Process-Data/Continuous-Query/pic4.png | Bin 0 -> 36135 bytes

.../Process-Data/GroupBy/groupBySession.jpeg | Bin 0 -> 45630 bytes

.../Process-Data/GroupBy/groupByVariation.jpeg | Bin 0 -> 59469 bytes

.../Process-Data/Triggers/ForwardQueueConsume.png | Bin 0 -> 190973 bytes

.../Process-Data/Triggers/Trigger_Process_Flow.jpg | Bin 0 -> 25591 bytes

.../Triggers/Trigger_Process_Strategy.jpg | Bin 0 -> 70240 bytes

.../UDF-User-Defined-Function/countWindow.png | Bin 0 -> 102766 bytes

.../UDF-User-Defined-Function/sessionWindow.png | Bin 0 -> 109806 bytes

.../UDF-User-Defined-Function/stateWindow.png | Bin 0 -> 94322 bytes

.../UDF-User-Defined-Function/timeWindow.png | Bin 0 -> 100258 bytes

.../UserGuide/System-Tools/Metrics/dashboard.png | Bin 0 -> 203647 bytes

.../Metrics/iotdb_prometheus_grafana.png | Bin 0 -> 304191 bytes

.../System-Tools/Metrics/metrics_demo_1.png | Bin 0 -> 262783 bytes

.../System-Tools/Metrics/metrics_demo_2.png | Bin 0 -> 191559 bytes

.../img/UserGuide/System-Tools/Sync-Tool/pipe2.png | Bin 0 -> 58248 bytes

...752940-50407b00-43a5-11eb-94fb-3e3be222183c.png | Bin 0 -> 169114 bytes

...752945-5171a800-43a5-11eb-8614-53b3276a3ce2.png | Bin 0 -> 87397 bytes

...752947-520a3e80-43a5-11eb-8fb1-8fac471c8c7e.png | Bin 0 -> 173739 bytes

...752948-52a2d500-43a5-11eb-9156-0c55667eb4cd.png | Bin 0 -> 125270 bytes

...251336-cf03c000-624f-11eb-8395-de5e349f47b5.png | Bin 0 -> 99963 bytes

...251353-d32fdd80-624f-11eb-80c1-fdb4197939fe.png | Bin 0 -> 112717 bytes

...251369-d7f49180-624f-11eb-9d19-fc7341582b90.png | Bin 0 -> 89864 bytes

...251377-daef8200-624f-11eb-9678-b1d5440be2de.png | Bin 0 -> 111910 bytes

...251391-df1b9f80-624f-11eb-9f1f-66823839acba.png | Bin 0 -> 94191 bytes

...251411-e5aa1700-624f-11eb-8ca8-00c0627b1e96.png | Bin 0 -> 98958 bytes

...254214-6cacbe80-6253-11eb-8532-d6a1829f8f66.png | Bin 0 -> 95325 bytes

...426760-73e3da80-8d73-11eb-9a8f-9232d1f2033b.png | Bin 0 -> 76603 bytes

...125919-f4850800-9929-11eb-8211-81d4c04af1ec.png | Bin 0 -> 142774 bytes

...957896-a9791080-a537-11eb-9962-541412bdcee6.png | Bin 0 -> 110029 bytes

...790229-23e34900-b8c8-11eb-87da-ac01dd117f28.png | Bin 0 -> 32058 bytes

...833923-182ffc00-bf32-11eb-8b3f-9f95d3729ad2.png | Bin 0 -> 324124 bytes

...668849-b1c69280-d1ec-11eb-83cb-3b73c40bdf72.png | Bin 0 -> 85937 bytes

...542457-5f511d00-d77c-11eb-8006-562d83069baa.png | Bin 0 -> 85488 bytes

...951720-707f1ee8-32ee-4fde-9252-048caebd232e.png | Bin 0 -> 293510 bytes

...178733-a0919d17-0663-4672-9c4f-1efad6f463c2.png | Bin 0 -> 101545 bytes

...181449-00d563c8-7bce-4ecd-a031-ec120ca42c3f.png | Bin 0 -> 66497 bytes

...183015-93b56644-3330-4acf-ae9e-d718a02b5f4c.png | Bin 0 -> 16451 bytes

...018765-6fda9391-ebcf-4c80-98c5-26f34bd74df0.png | Bin 0 -> 350636 bytes

...577195-f94d7500-1ef3-11e9-999a-b4f67055d80e.png | Bin 0 -> 41935 bytes

...577204-fe122900-1ef3-11e9-9e89-2eb1d46e24b8.png | Bin 0 -> 221206 bytes

...577216-09fdeb00-1ef4-11e9-9005-542ad7d9e9e0.png | Bin 0 -> 203454 bytes

...579014-695ef980-1efa-11e9-8cbc-e9e7ee4fa0d8.png | Bin 0 -> 861503 bytes

...579033-7ed42380-1efa-11e9-889f-fb4180291a9e.png | Bin 0 -> 386176 bytes

...579064-8f849980-1efa-11e9-8cd6-a7339cd0540f.jpg | Bin 0 -> 303859 bytes

...579080-96aba780-1efa-11e9-87ac-940c45b19dd7.jpg | Bin 0 -> 234375 bytes

...579095-a4f9c380-1efa-11e9-9f95-17165ec55568.jpg | Bin 0 -> 200091 bytes

...664777-2766ae00-1ff5-11e9-9d2f-7489f8ccbfc2.png | Bin 0 -> 277087 bytes

...664842-554bf280-1ff5-11e9-97d2-54eebe0b2ca1.png | Bin 0 -> 333531 bytes

...664878-6e54a380-1ff5-11e9-9718-4d0e24627fa8.png | Bin 0 -> 276994 bytes

...937461-14296f80-a303-11e9-9602-a7bed624bfb3.png | Bin 0 -> 238093 bytes

...922722-35180400-f05a-11e9-8ff0-7dd51716e4a8.png | Bin 0 -> 16824 bytes

...943956-39c1e800-fc16-11e9-8da2-a662f8246816.png | Bin 0 -> 213188 bytes

...109512-f808bc80-0ab2-11ea-9e4d-b2b2f58fb474.png | Bin 0 -> 16914 bytes

...792176-1718f400-1201-11ea-861a-1a83c07ca144.jpg | Bin 0 -> 14952 bytes

...357432-0c71cf80-75e4-11ea-98aa-c43a54d469ce.png | Bin 0 -> 38174 bytes

...357469-1bf11880-75e4-11ea-978f-a53996667a0d.png | Bin 0 -> 25267 bytes

...351839-bd288900-7f6b-11ea-8d12-feb18c35adad.png | Bin 0 -> 179218 bytes

...414865-5f815480-7fde-11ea-800c-47c7dbad7648.png | Bin 0 -> 101410 bytes

...462909-53a53e80-91e8-11ea-98df-0012380da0b2.png | Bin 0 -> 77209 bytes

...462914-5738c580-91e8-11ea-94d1-4ff6607e7e2c.png | Bin 0 -> 121334 bytes

...464569-725e0200-91f5-11ea-9ff9-49745f4c9ef2.png | Bin 0 -> 115173 bytes

...464639-ed271d00-91f5-11ea-91a0-b4fe9cb8204e.png | Bin 0 -> 160280 bytes

...768477-b874d780-950d-11ea-80ca-8807b9bd0970.png | Bin 0 -> 476193 bytes

...768490-bf034f00-950d-11ea-9b56-fef3edca0958.png | Bin 0 -> 332540 bytes

...197835-99a64980-1f62-11eb-84af-8301b8a6aad5.png | Bin 0 -> 71304 bytes

...197920-be9abc80-1f62-11eb-9efb-027f0590031c.png | Bin 0 -> 71488 bytes

...197948-cf4b3280-1f62-11eb-9c8c-c97d1adf032c.png | Bin 0 -> 116419 bytes

...633970-73671c00-235d-11eb-9913-f38e570fcfc8.png | Bin 0 -> 36452 bytes

...787878-47b51480-2b5b-11eb-8ed3-84088c5c30f7.png | Bin 0 -> 112663 bytes

.../img/zh/development/howtocontributecode/01.png | Bin 0 -> 89974 bytes

.../img/zh/development/howtocontributecode/02.png | Bin 0 -> 121641 bytes

.../img/zh/development/howtocontributecode/03.png | Bin 0 -> 214508 bytes

.../zh/development/howtocontributecode/issue.png | Bin 0 -> 108398 bytes

site/src/main/.vuepress/public/logo.png | Bin 0 -> 21687 bytes

313 files changed, 1810 insertions(+), 1277 deletions(-)

diff --git a/docs/UserGuide/API/InfluxDB-Protocol.md b/docs/UserGuide/API/InfluxDB-Protocol.md

index 9fcad8b2d5..2530c655e4 100644

--- a/docs/UserGuide/API/InfluxDB-Protocol.md

+++ b/docs/UserGuide/API/InfluxDB-Protocol.md

@@ -51,9 +51,9 @@ InfluxDB influxDB = IoTDBInfluxDBFactory.connect(openurl, username, password);

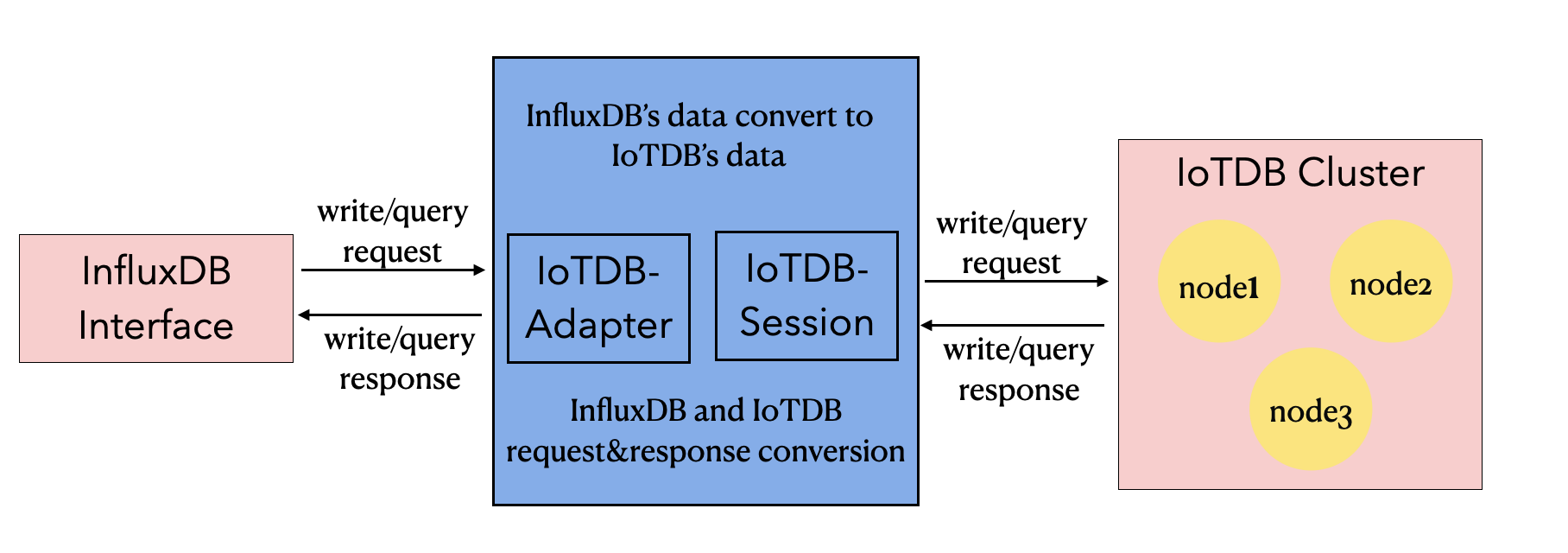

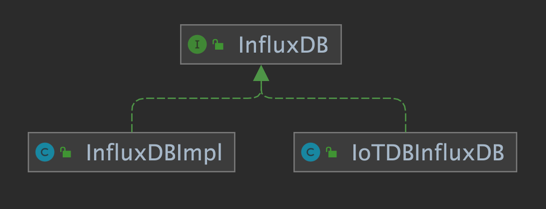

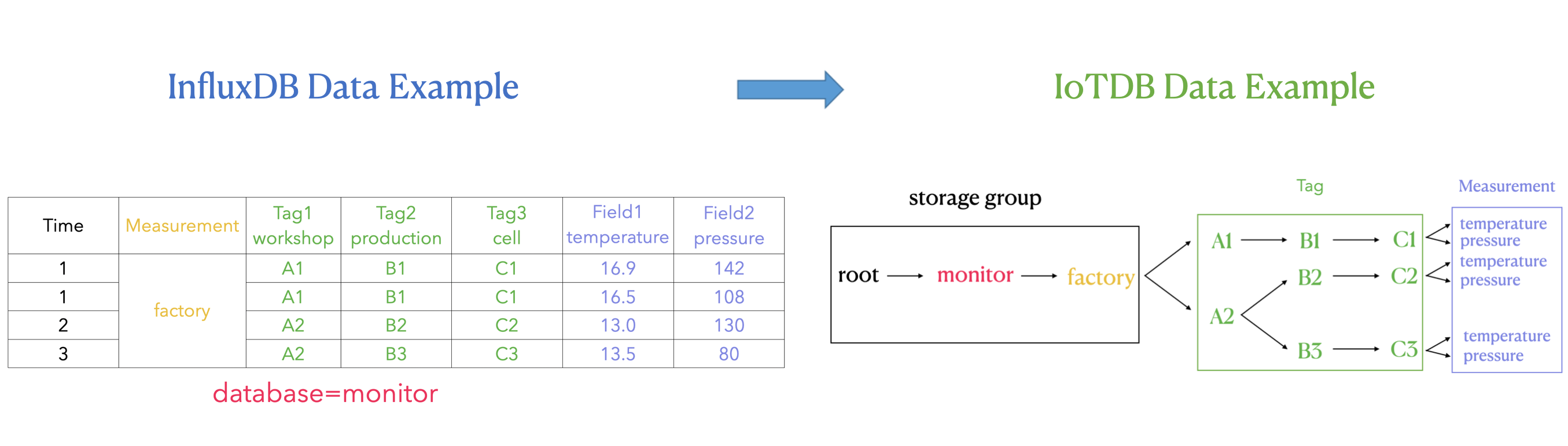

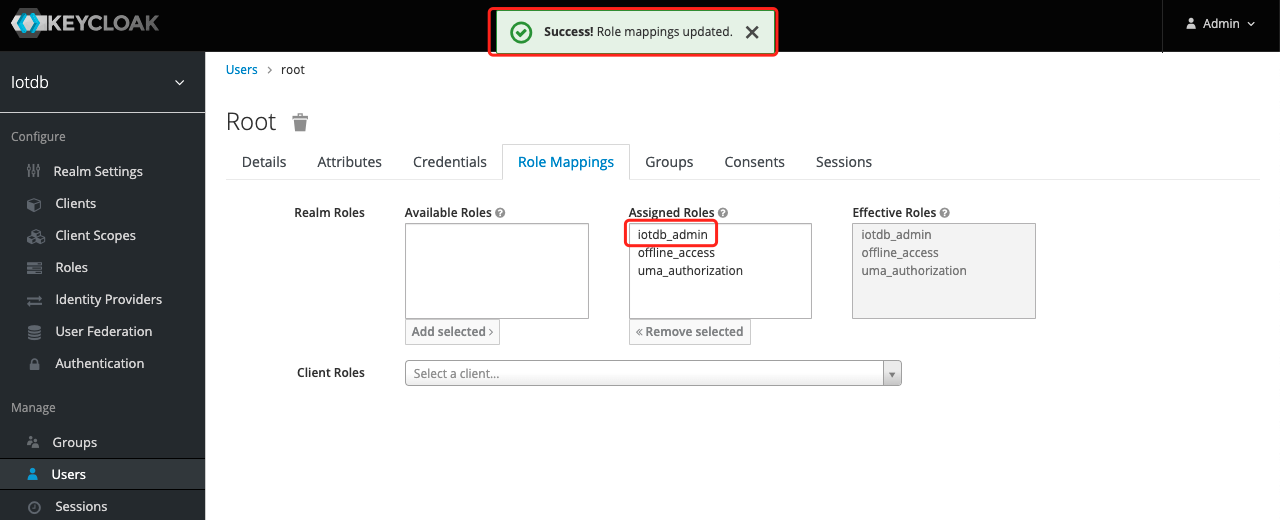

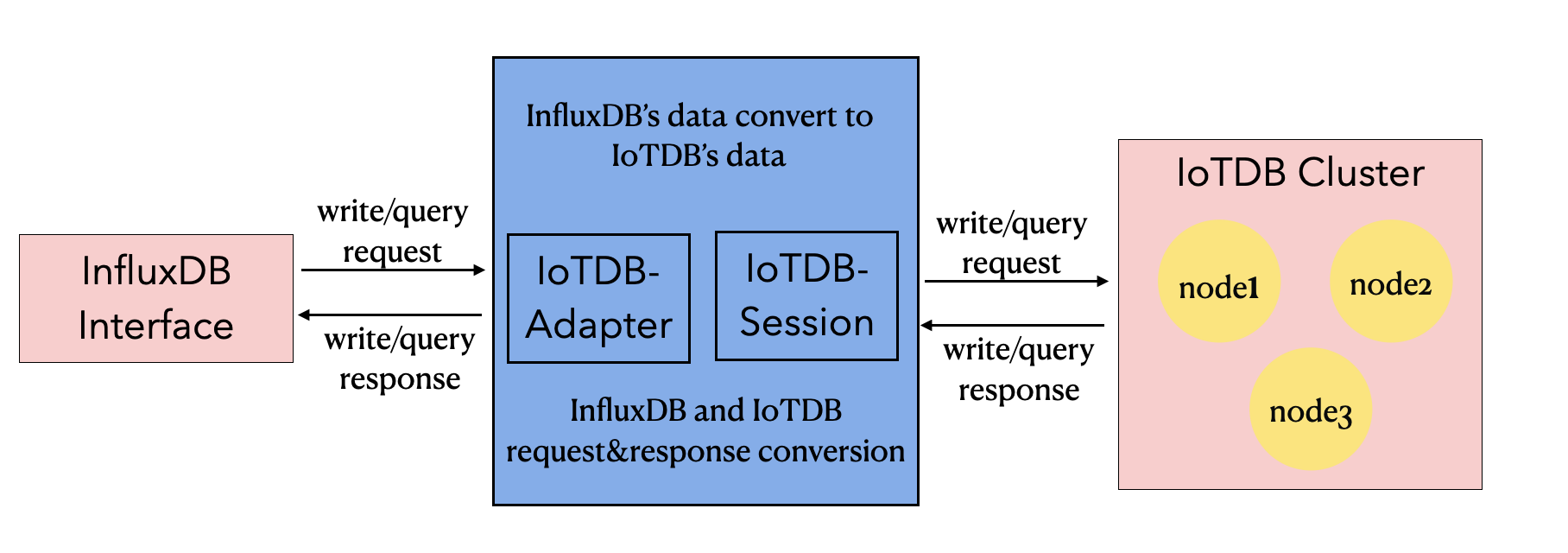

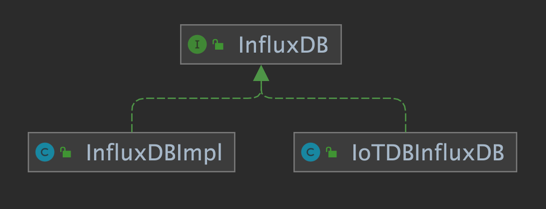

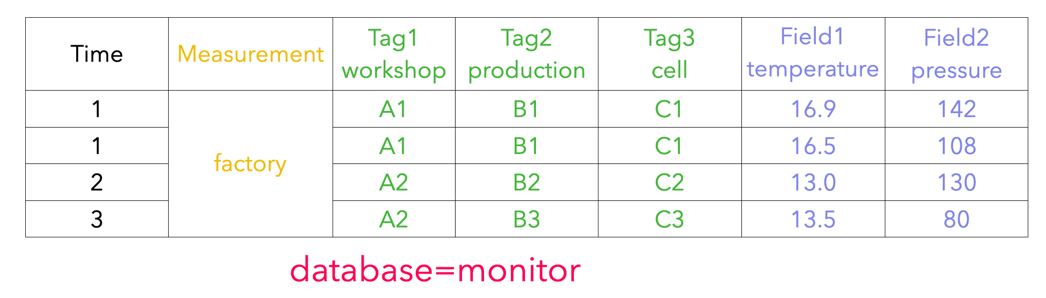

Based on the IoTDB Java ServiceProvider interface, the adapter implements the 'interface InfluxDB' of the java interface of InfluxDB, and provides users with all the interface methods of InfluxDB. End users can use the InfluxDB protocol to initiate write and read requests to IoTDB without perception.

-

+

-

+

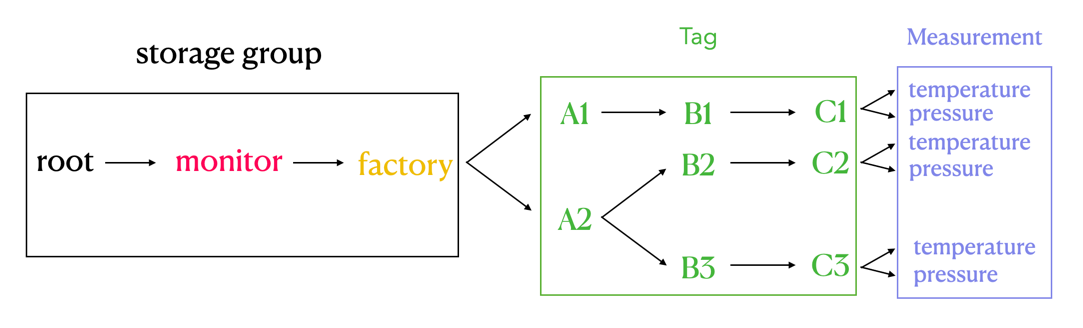

### 2.2 Metadata Format Conversion

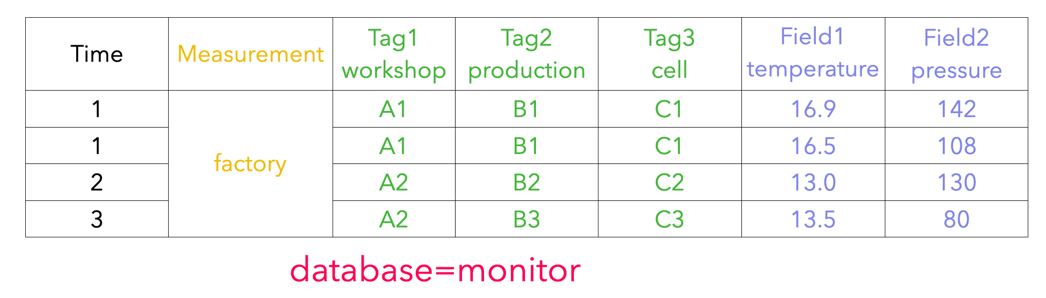

@@ -66,7 +66,7 @@ The metadata of InfluxDB is tag field model, and the metadata of IoTDB is tree m

3. tags: various indexed attributes.

4. fields: various record values(attributes without index).

-

+

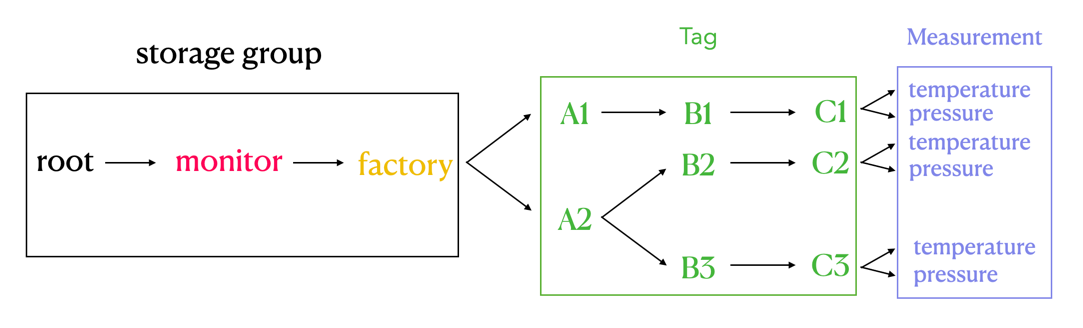

#### 2.2.2 IoTDB Metadata

@@ -74,7 +74,7 @@ The metadata of InfluxDB is tag field model, and the metadata of IoTDB is tree m

2. path(time series ID): storage path.

3. measurement: physical quantity.

-

+

#### 2.2.3 Mapping relationship between the two

@@ -87,7 +87,7 @@ The transformation relationship from InfluxDB metadata to IoTDB metadata can be

`root.{database}.{measurement}.{tag value 1}.{tag value 2}...{tag value N-1}.{tag value N}.{field key}`

-

+

As shown in the figure above, it can be seen that:

diff --git a/docs/UserGuide/API/Programming-JDBC.md b/docs/UserGuide/API/Programming-JDBC.md

index 3122634563..0329282ad1 100644

--- a/docs/UserGuide/API/Programming-JDBC.md

+++ b/docs/UserGuide/API/Programming-JDBC.md

@@ -64,7 +64,7 @@ It requires including the packages containing the JDBC classes needed for databa

**NOTE: For faster insertion, the insertTablet() in Session is recommended.**

-```Java

+```java

import java.sql.*;

import org.apache.iotdb.jdbc.IoTDBSQLException;

diff --git a/docs/UserGuide/API/Programming-MQTT.md b/docs/UserGuide/API/Programming-MQTT.md

index 4d3f6a9fc7..84838a5ec1 100644

--- a/docs/UserGuide/API/Programming-MQTT.md

+++ b/docs/UserGuide/API/Programming-MQTT.md

@@ -27,7 +27,7 @@ It is useful for connections with remote locations where a small code footprint

IoTDB supports the MQTT v3.1(an OASIS Standard) protocol.

IoTDB server includes a built-in MQTT service that allows remote devices send messages into IoTDB server directly.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://user-images.githubusercontent.com/6711230/78357432-0c71cf80-75e4-11ea-98aa-c43a54d469ce.png">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/github/78357432-0c71cf80-75e4-11ea-98aa-c43a54d469ce.png">

### Built-in MQTT Service

@@ -56,7 +56,7 @@ or

```

or json array of the above two.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://user-images.githubusercontent.com/6711230/78357469-1bf11880-75e4-11ea-978f-a53996667a0d.png">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/github/78357469-1bf11880-75e4-11ea-978f-a53996667a0d.png">

### MQTT Configurations

The IoTDB MQTT service load configurations from `${IOTDB_HOME}/${IOTDB_CONF}/iotdb-datanode.properties` by default.

@@ -112,7 +112,7 @@ Steps:

<dependency>

<groupId>org.apache.iotdb</groupId>

<artifactId>iotdb-server</artifactId>

- <version>${project.version}</version>

+ <version>1.1.0-SNAPSHOT</version>

</dependency>

```

* Define your implementation which implements `org.apache.iotdb.db.protocol.mqtt.PayloadFormatter`

diff --git a/docs/UserGuide/API/Programming-Python-Native-API.md b/docs/UserGuide/API/Programming-Python-Native-API.md

index c1cd8995ad..3539eef37c 100644

--- a/docs/UserGuide/API/Programming-Python-Native-API.md

+++ b/docs/UserGuide/API/Programming-Python-Native-API.md

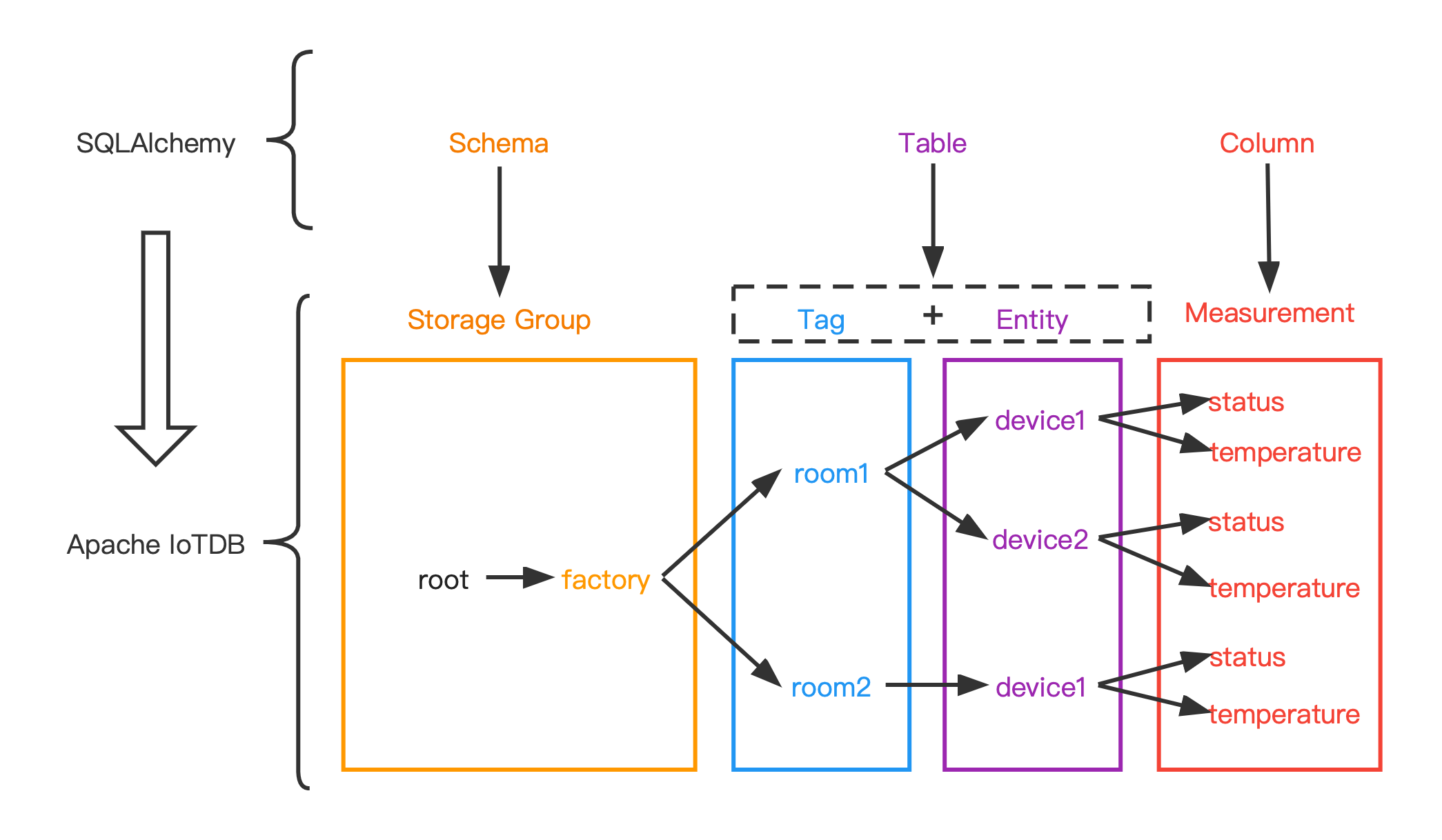

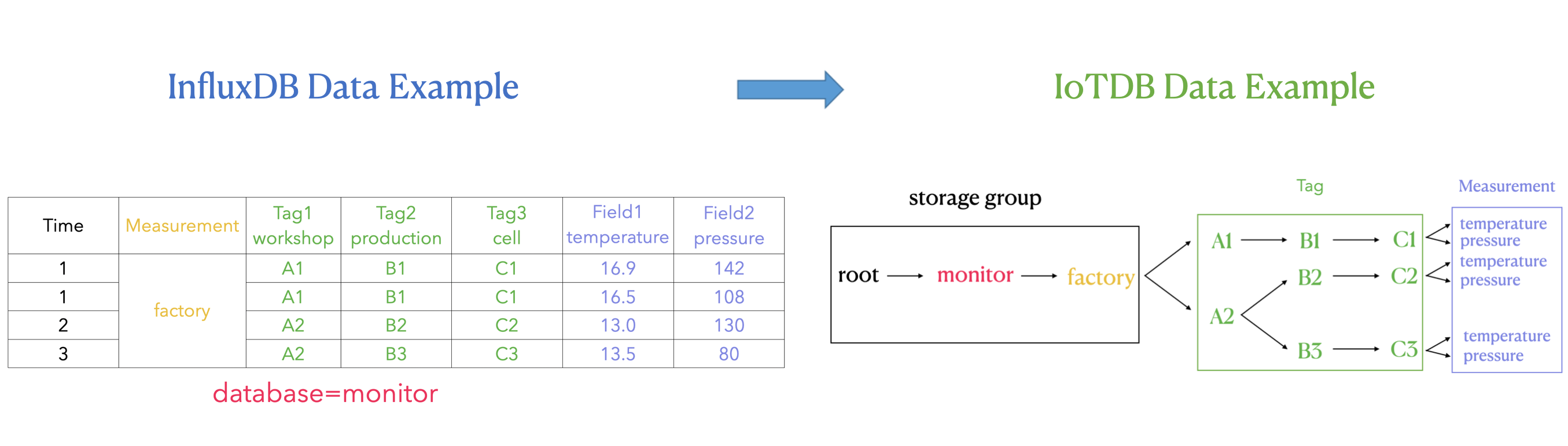

@@ -513,7 +513,7 @@ The mapping relationship between them is:

The following figure shows the relationship between the two more intuitively:

-

+

#### Data type mapping

| data type in IoTDB | data type in SQLAlchemy |

diff --git a/docs/UserGuide/Cluster/Cluster-Concept.md b/docs/UserGuide/Cluster/Cluster-Concept.md

index 25773dd10b..5131adc865 100644

--- a/docs/UserGuide/Cluster/Cluster-Concept.md

+++ b/docs/UserGuide/Cluster/Cluster-Concept.md

@@ -27,7 +27,7 @@ Apache IoTDB Cluster contains two types of nodes: ConfigNode and DataNode, each

An illustration of the cluster architecture:

-<img style="width:100%; max-width:500px; max-height:400px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Cluster/Architecture.png?raw=true">

+<img style="width:100%; max-width:500px; max-height:400px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Cluster/Architecture.png?raw=true">

ConfigNode is the control node of the cluster, which manages the cluster's node status, partition information, etc. All ConfigNodes in the cluster form a highly available group, which is fully replicated.

@@ -98,7 +98,7 @@ A region is the basic unit of replication. Multiple replicas of a region constru

An illustration of the partition allocation in cluster:

-<img style="width:100%; max-width:500px; max-height:500px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Cluster/Data-Partition.png?raw=true">

+<img style="width:100%; max-width:500px; max-height:500px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Cluster/Data-Partition.png?raw=true">

The figure contains 1 SchemaRegionGroup, and the schema_replication_factor is 3, so the 3 white SchemaRegion-0s form a replication group.

diff --git a/docs/UserGuide/Cluster/Cluster-Maintenance.md b/docs/UserGuide/Cluster/Cluster-Maintenance.md

index ab1c6ec4b1..0d61b46914 100644

--- a/docs/UserGuide/Cluster/Cluster-Maintenance.md

+++ b/docs/UserGuide/Cluster/Cluster-Maintenance.md

@@ -125,7 +125,7 @@ It costs 0.006s

### DataNode status definition

The state machine of DataNode is shown in the figure below:

-<img style="width:100%; max-width:500px; max-height:500px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Cluster/DataNode-StateMachine-EN.jpg?raw=true">

+<img style="width:100%; max-width:500px; max-height:500px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Cluster/DataNode-StateMachine-EN.jpg?raw=true">

The DataNode statuses are defined as follows:

diff --git a/docs/UserGuide/Data-Concept/Data-Model-and-Terminology.md b/docs/UserGuide/Data-Concept/Data-Model-and-Terminology.md

index 5fc169cbda..482bfded97 100644

--- a/docs/UserGuide/Data-Concept/Data-Model-and-Terminology.md

+++ b/docs/UserGuide/Data-Concept/Data-Model-and-Terminology.md

@@ -25,7 +25,7 @@ A wind power IoT scenario is taken as an example to illustrate how to creat a co

According to the enterprise organization structure and equipment entity hierarchy, it is expressed as an attribute hierarchy structure, as shown below. The hierarchical from top to bottom is: power group layer - power plant layer - entity layer - measurement layer. ROOT is the root node, and each node of measurement layer is a leaf node. In the process of using IoTDB, the attributes on the path from ROOT node is directly connected to each leaf node with ".", thus forming the name of a ti [...]

-<center><img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://user-images.githubusercontent.com/19167280/122668849-b1c69280-d1ec-11eb-83cb-3b73c40bdf72.png"></center>

+<center><img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/github/122668849-b1c69280-d1ec-11eb-83cb-3b73c40bdf72.png"></center>

Here are the basic concepts of the model involved in IoTDB.

@@ -132,7 +132,7 @@ When querying, you can query each timeseries separately.

When inserting data, it is allowed to insert null value in the aligned timeseries.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://user-images.githubusercontent.com/19167280/114125919-f4850800-9929-11eb-8211-81d4c04af1ec.png">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/github/114125919-f4850800-9929-11eb-8211-81d4c04af1ec.png">

In the following chapters of data definition language, data operation language and Java Native Interface, various operations related to aligned timeseries will be introduced one by one.

diff --git a/docs/UserGuide/Data-Concept/Schema-Template.md b/docs/UserGuide/Data-Concept/Schema-Template.md

index a3d97622f1..2285ca330c 100644

--- a/docs/UserGuide/Data-Concept/Schema-Template.md

+++ b/docs/UserGuide/Data-Concept/Schema-Template.md

@@ -29,7 +29,7 @@ In order to enable different entities of the same type to share metadata, reduce

The following picture illustrates the data model of petrol vehicle scenario. The velocity, fuel amount, acceleration, and angular velocity of each petrol vehicle spread over cities will be collected. Obviously, the measurements of single petrol vehicle are the same as those of another.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Data%20Concept/Measurement%20Template/example_without_template.png?raw=true" alt="example without template">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Data-Concept/Measurement-Template/example_without_template.png" alt="example without template">

## Concept

@@ -45,7 +45,7 @@ In the following chapters of data definition language, data operation language a

After applying schema template, the following picture illustrates the new data model of petrol vehicle scenario. All petrol vehicles share the schemas defined in template. There are no redundancy storage of measurement schemas.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Data%20Concept/Measurement%20Template/example_with_template.png?raw=true" alt="example with template">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Data-Concept/Measurement-Template/example_with_template.png" alt="example with template">

### Lifetime of Schema Template

@@ -60,7 +60,7 @@ The term about lifetime of schema template may help you utilize it in a better w

It should be complemented that the distinction between SET and ACTIVATE is meant to serve an ubiquitous scenario where massive nodes with a common ancestor may need to apply the template. Under this circumstance, it is more feasible to SET the template on the common ancestor rather than all those descendant. For those who needs to apply the template, ACTIVATE is a more appropriate arrangement.

-<img style="width:100%; max-width:800px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Data%20Concept/Measurement%20Template/example_template_lifetime.png?raw=true" alt="example with template">

+<img style="width:100%; max-width:800px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Data-Concept/Measurement-Template/example_template_lifetime.png" alt="example with template">

## Usage

diff --git a/docs/UserGuide/Data-Concept/Time-Partition.md b/docs/UserGuide/Data-Concept/Time-Partition.md

index ddd781d4b3..f67919e1e9 100644

--- a/docs/UserGuide/Data-Concept/Time-Partition.md

+++ b/docs/UserGuide/Data-Concept/Time-Partition.md

@@ -38,7 +38,7 @@ Time partition divides data according to time, and a time partition is used to s

Enable time partition and set partition_interval to 86400000 (one day), then the data distribution is shown as the following figure:

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Data%20Concept/Time-Partition/time_partition_example.png?raw=true" alt="time partition example">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Data-Concept/Time-Partition/time_partition_example.png?raw=true" alt="time partition example">

* Insert one datapoint with timestamp 0, calculate 0/86400000 = 0, then this datapoint will be stored in TsFile under folder 0

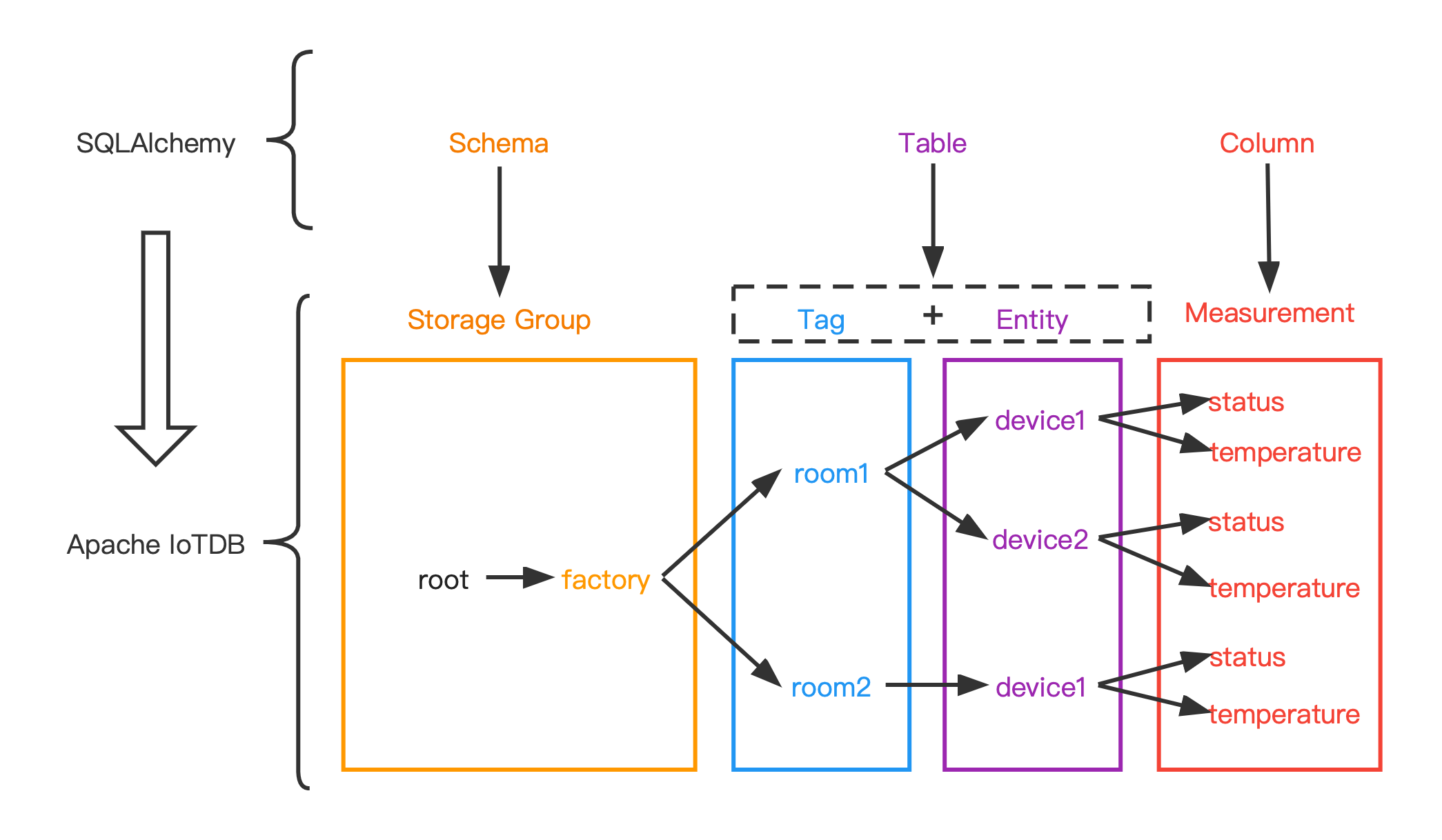

diff --git a/docs/UserGuide/Ecosystem-Integration/DBeaver.md b/docs/UserGuide/Ecosystem-Integration/DBeaver.md

index 25159978d5..5392b50c59 100644

--- a/docs/UserGuide/Ecosystem-Integration/DBeaver.md

+++ b/docs/UserGuide/Ecosystem-Integration/DBeaver.md

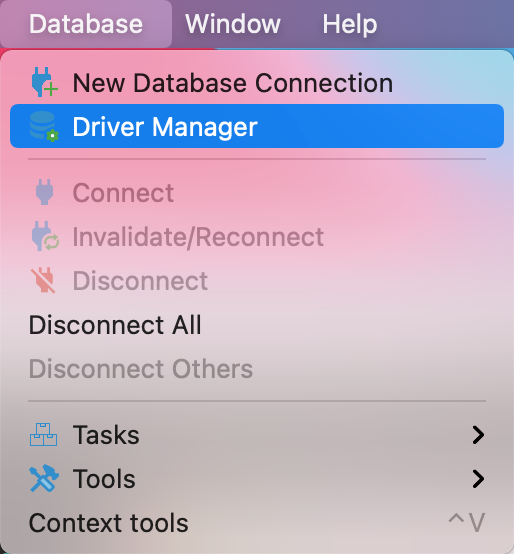

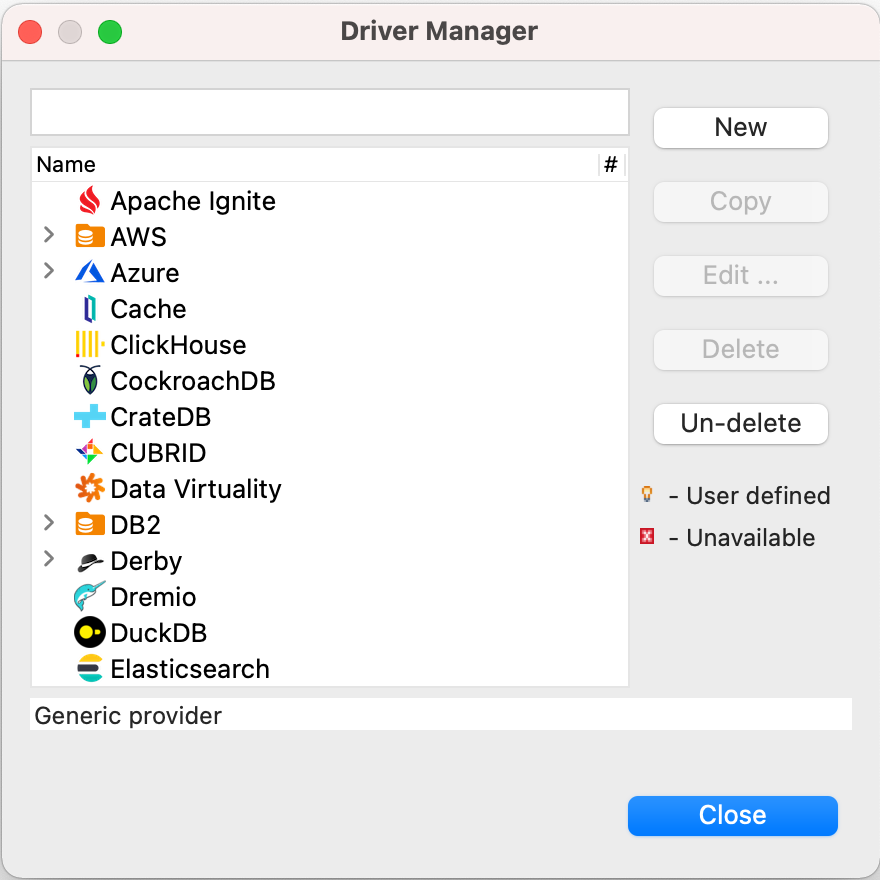

@@ -45,11 +45,11 @@ DBeaver is a SQL client software application and a database administration tool.

2. Start DBeaver

3. Open Driver Manager

-

+

4. Create a new driver type for IoTDB

-

+

5. Download [Sources](https://iotdb.apache.org/Download/),unzip it and compile jdbc driver by the following command

@@ -58,15 +58,15 @@ DBeaver is a SQL client software application and a database administration tool.

```

6. Find and add a lib named `apache-iotdb-jdbc-{version}-jar-with-dependencies.jar`, which should be under `jdbc/target/`, then select `Find Class`.

-

+

8. Edit the driver Settings

-

+

9. Open New DataBase Connection and select iotdb

-

+

10. Edit JDBC Connection Settings

@@ -75,12 +75,12 @@ DBeaver is a SQL client software application and a database administration tool.

Username: root

Password: root

```

-

+

11. Test Connection

-

+

12. Enjoy IoTDB with DBeaver

-

+

diff --git a/docs/UserGuide/Ecosystem-Integration/Grafana-Connector.md b/docs/UserGuide/Ecosystem-Integration/Grafana-Connector.md

index 1c9b12227b..72d26ca401 100644

--- a/docs/UserGuide/Ecosystem-Integration/Grafana-Connector.md

+++ b/docs/UserGuide/Ecosystem-Integration/Grafana-Connector.md

@@ -128,15 +128,15 @@ Username and password are both "admin" by default.

Select `Data Sources` and then `Add data source`, select `SimpleJson` in `Type` and `URL` is http://localhost:8888.

After that, make sure IoTDB has been started, click "Save & Test", and "Data Source is working" will be shown to indicate successful configuration.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://user-images.githubusercontent.com/13203019/51664777-2766ae00-1ff5-11e9-9d2f-7489f8ccbfc2.png">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/github/51664777-2766ae00-1ff5-11e9-9d2f-7489f8ccbfc2.png">

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://user-images.githubusercontent.com/13203019/51664842-554bf280-1ff5-11e9-97d2-54eebe0b2ca1.png">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/github/51664842-554bf280-1ff5-11e9-97d2-54eebe0b2ca1.png">

#### Design in dashboard

Add diagrams in dashboard and customize your query. See http://docs.grafana.org/guides/getting_started/

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://user-images.githubusercontent.com/13203019/51664878-6e54a380-1ff5-11e9-9718-4d0e24627fa8.png">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/github/51664878-6e54a380-1ff5-11e9-9718-4d0e24627fa8.png">

### config grafana

diff --git a/docs/UserGuide/Ecosystem-Integration/Grafana-Plugin.md b/docs/UserGuide/Ecosystem-Integration/Grafana-Plugin.md

index abe2bf6537..1b63767f9e 100644

--- a/docs/UserGuide/Ecosystem-Integration/Grafana-Plugin.md

+++ b/docs/UserGuide/Ecosystem-Integration/Grafana-Plugin.md

@@ -80,7 +80,7 @@ go get: module github.com/grafana/grafana-plugin-sdk-go: Get "https://proxy.gola

If compiling successful, you can see the `dist` directory , which contains the compiled Grafana-Plugin:

-<img style="width:100%; max-width:333px; max-height:545px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/grafana-plugin-build.png?raw=true">

+<img style="width:100%; max-width:333px; max-height:545px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/grafana-plugin-build.png?raw=true">

##### Method 3: The distribution package of IoTDB is fully compiled

@@ -94,7 +94,7 @@ Execute following command in the IoTDB root directory:

If compiling successful, you can see that the `distribution/target` directory contains the compiled Grafana-Plugin:

-<img style="width:100%; max-width:333px; max-height:545px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/distribution.png?raw=true">

+<img style="width:100%; max-width:333px; max-height:545px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/distribution.png?raw=true">

#### Install Grafana-Plugin

@@ -171,9 +171,9 @@ Grafana displays data in a web page dashboard. Please open your browser and visi

Click the `Settings` icon on the left, select the `Data Source` option, and then click `Add data source`.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/datasource_1.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/datasource_1.png?raw=true">

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/datasource_2.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/datasource_2.png?raw=true">

Select the `Apache IoTDB` data source.

@@ -184,22 +184,22 @@ Select the `Apache IoTDB` data source.

Click `Save & Test`, and `Success` will appear.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/datasource_3.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/datasource_3.png?raw=true">

#### Create a new Panel

Click the `Dashboards` icon on the left, and select `Manage` option.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/manage.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/manage.png?raw=true">

Click the `New Dashboard` icon on the top right, and select `Add an empty panel` option.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/add%20empty%20panel.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/add-empty-panel.png?raw=true">

Grafana plugin supports SQL: Full Customized mode and SQL: Drop-down List mode, and the default mode is SQL: Full Customized mode.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/grafana_input_style.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/grafana_input_style.png?raw=true">

##### SQL: Full Customized input method

@@ -207,7 +207,7 @@ Enter content in the SELECT, FROM , WHERE and CONTROL input box, where the WHERE

If a query involves multiple expressions, we can click `+` on the right side of the SELECT input box to add expressions in the SELECT clause, or click `+` on the right side of the FROM input box to add a path prefix:

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/grafana_input.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/grafana_input.png?raw=true">

SELECT input box: contents can be the time series suffix, function, udf, arithmetic expression, or nested expressions. You can also use the as clause to rename the result.

@@ -245,7 +245,7 @@ Tip: Statements like `select * from root.xx.**` are not recommended because thos

Select a time series in the TIME-SERIES selection box, select a function in the FUNCTION option, and enter the contents in the SAMPLING INTERVAL、SLIDING STEP、LEVEL、FILL input boxes, where TIME-SERIES is a required item and the rest are non required items.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/grafana_input2.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/grafana_input2.png?raw=true">

#### Support for variables and template functions

@@ -253,34 +253,34 @@ Both SQL: Full Customized and SQL: Drop-down List input methods support the vari

After creating a new Panel, click the Settings button in the upper right corner:

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/setconf.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/setconf.png?raw=true">

Select `Variables`, click `Add variable`:

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/addvaribles.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/addvaribles.png?raw=true">

Example 1:Enter `Name`, `Label`, and `Query`, and then click the `Update` button:

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/variblesinput.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/variblesinput.png?raw=true">

Apply Variables, enter the variable in the `grafana panel` and click the `save` button:

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/applyvariables.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/applyvariables.png?raw=true">

Example 2: Nested use of variables:

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/variblesinput2.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/variblesinput2.png?raw=true">

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/variblesinput2-1.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/variblesinput2-1.png?raw=true">

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/variblesinput2-2.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/variblesinput2-2.png?raw=true">

Example 3: using function variables

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/variablesinput3.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/variablesinput3.png?raw=true">

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/variablesinput3-1.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/variablesinput3-1.png?raw=true">

The Name in the above figure is the variable name and the variable name we will use in the panel in the future. Label is the display name of the variable. If it is empty, the variable of Name will be displayed. Otherwise, the name of the Label will be displayed.

There are Query, Custom, Text box, Constant, DataSource, Interval, Ad hoc filters, etc. in the Type drop-down, all of which can be used in IoTDB's Grafana Plugin

@@ -304,30 +304,30 @@ This plugin supports Grafana alert function.

1. In the Grafana sidebar, hover over the `Alerting` icon and click `Notification channels`.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/alerting1.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/alerting1.png?raw=true">

2. Click Add Channel.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/alerting2.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/alerting2.png?raw=true">

3. Fill in the fields described below or select options. There are many types of Type, including DingDing, Email, Slack, WebHook, Prometheus Alertmanager, etc.

This sample Type uses `Prometheus Alertmanager`. Prometheus Alertmanager needs to be installed in advance. For more detailed configuration and parameter introduction, please refer to the official documentation: https://grafana.com/docs/grafana/v8.0/alerting/old- alerting/notifications/.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/alerting3.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/alerting3.png?raw=true">

4. Click the `Test` button, the `Test notification sent` appears, click the `Save` button to save

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/alerting4.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/alerting4.png?raw=true">

5. After creating a new Panel, enter the query parameters and click Save, then select `Alert` and click `Create Alert`, as shown in the following figure:

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/alertpanle1.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/alertpanle1.png?raw=true">

6、Fill out the fields described below or select an option, `Name`- Enter a descriptive name. The name will be displayed in the Alert Rules list. This field supports templating.

`Evaluate every` - Specify how often the scheduler should evaluate the alert rule. This is referred to as the evaluation interval.

`For` - Specify how long the query needs to violate the configured thresholds before the alert notification triggers.。`Conditions`- Represents query criteria. Multiple combined query criteria can be configured.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/alertpanle2.jpg?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/alertpanle2.jpg?raw=true">

Query conditions in the figure:avg() OF query(A,5m,now) IS ABOVE -1

@@ -344,19 +344,19 @@ More details can be found in the official documents:https://grafana.com/docs/gra

7、Click the `Test rule` button and the `firing: true` appears, the configuration is successful, click the `save` button

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/alertpanel3.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/alertpanel3.png?raw=true">

8、The following figure shows the alarm displayed in the grafana panel

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/alertpanel4.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/alertpanel4.png?raw=true">

9、View alert rules

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/alertPanel5.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/alertPanel5.png?raw=true">

10、View alert records in promehthus alertmanager

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/Ecosystem%20Integration/Grafana-plugin/alertpanel6.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/Ecosystem-Integration/Grafana-plugin/alertpanel6.png?raw=true">

### More Details about Grafana

diff --git a/docs/UserGuide/Ecosystem-Integration/NiFi-IoTDB.md b/docs/UserGuide/Ecosystem-Integration/NiFi-IoTDB.md

index 6382bd647f..8852740795 100644

--- a/docs/UserGuide/Ecosystem-Integration/NiFi-IoTDB.md

+++ b/docs/UserGuide/Ecosystem-Integration/NiFi-IoTDB.md

@@ -129,7 +129,7 @@ This is a processor that reads the sql query from the incoming FlowFile and usin

| Username | Username to access the IoTDB. | null | true |

| Password | Password to access the IoTDB. | null | true |

| Record Writer | Specifies the Controller Service to use for writing results to a FlowFile. The Record Writer may use Inherit Schema to emulate the inferred schema behavior, i.e. An explicit schema need not be defined in the writer, and will be supplied by the same logic used to infer the schema from the column types. | null | true |

-| iotdb-query | The IoTDB query to execute. <bbr> Note: If there are incoming connections, then the query is created from incoming FlowFile's content otherwise"it is created from this property. | null | false |

+| iotdb-query | The IoTDB query to execute. <br> Note: If there are incoming connections, then the query is created from incoming FlowFile's content otherwise"it is created from this property. | null | false |

| iotdb-query-chunk-size | Chunking can be used to return results in a stream of smaller batches (each has a partial results up to a chunk size) rather than as a single response. Chunking queries can return an unlimited number of rows. Note: Chunking is enable when result chunk size is greater than 0 | 0 | false |

diff --git a/docs/UserGuide/Ecosystem-Integration/Spark-IoTDB.md b/docs/UserGuide/Ecosystem-Integration/Spark-IoTDB.md

index f53319b102..f7c987e178 100644

--- a/docs/UserGuide/Ecosystem-Integration/Spark-IoTDB.md

+++ b/docs/UserGuide/Ecosystem-Integration/Spark-IoTDB.md

@@ -93,7 +93,7 @@ Take the following TsFile structure as an example: There are three Measurements

The existing data in the TsFile is as follows:

-<img width="517" alt="SI " src="https://user-images.githubusercontent.com/69114052/98197835-99a64980-1f62-11eb-84af-8301b8a6aad5.png">

+<img width="517" alt="SI " src="/img/github/98197835-99a64980-1f62-11eb-84af-8301b8a6aad5.png">

The wide(default) table form is as follows:

diff --git a/docs/UserGuide/Ecosystem-Integration/Spark-TsFile.md b/docs/UserGuide/Ecosystem-Integration/Spark-TsFile.md

index 02fa7dea2c..2d0becf7f9 100644

--- a/docs/UserGuide/Ecosystem-Integration/Spark-TsFile.md

+++ b/docs/UserGuide/Ecosystem-Integration/Spark-TsFile.md

@@ -94,7 +94,7 @@ The way to display TsFile is dependent on the schema. Take the following TsFile

The existing data in the TsFile are:

-<img width="519" alt="ST 1" src="https://user-images.githubusercontent.com/69114052/98197920-be9abc80-1f62-11eb-9efb-027f0590031c.png">

+<img width="519" alt="ST 1" src="/img/github/98197920-be9abc80-1f62-11eb-9efb-027f0590031c.png">

The corresponding SparkSQL table is:

@@ -239,7 +239,7 @@ The way to display TsFile is related to TsFile Schema. Take the following TsFile

The existing data in the file are:

-<img width="817" alt="ST 2" src="https://user-images.githubusercontent.com/69114052/98197948-cf4b3280-1f62-11eb-9c8c-c97d1adf032c.png">

+<img width="817" alt="ST 2" src="/img/github/98197948-cf4b3280-1f62-11eb-9c8c-c97d1adf032c.png">

A set of time-series data

diff --git a/docs/UserGuide/Ecosystem-Integration/Writing-Data-on-HDFS.md b/docs/UserGuide/Ecosystem-Integration/Writing-Data-on-HDFS.md

index 9d0cffb1ca..646aae78f1 100644

--- a/docs/UserGuide/Ecosystem-Integration/Writing-Data-on-HDFS.md

+++ b/docs/UserGuide/Ecosystem-Integration/Writing-Data-on-HDFS.md

@@ -29,7 +29,7 @@ Currently, TsFiles(including both TsFile and related data files) are supported t

When you config to store TSFile on HDFS, your data files will be in distributed storage. The system architecture is as below:

-<img style="width:100%; max-width:700px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://user-images.githubusercontent.com/19167280/66922722-35180400-f05a-11e9-8ff0-7dd51716e4a8.png">

+<img style="width:100%; max-width:700px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/github/66922722-35180400-f05a-11e9-8ff0-7dd51716e4a8.png">

#### Config and usage

diff --git a/docs/UserGuide/Ecosystem-Integration/Zeppelin-IoTDB.md b/docs/UserGuide/Ecosystem-Integration/Zeppelin-IoTDB.md

index b218b3ed2c..c5f509f3e7 100644

--- a/docs/UserGuide/Ecosystem-Integration/Zeppelin-IoTDB.md

+++ b/docs/UserGuide/Ecosystem-Integration/Zeppelin-IoTDB.md

@@ -25,7 +25,7 @@

Zeppelin is a web-based notebook that enables interactive data analytics. You can connect to data sources and perform interactive operations with SQL, Scala, etc. The operations can be saved as documents, just like Jupyter. Zeppelin has already supported many data sources, including Spark, ElasticSearch, Cassandra, and InfluxDB. Now, we have enabled Zeppelin to operate IoTDB via SQL.

-

+

@@ -113,7 +113,7 @@ In the interpreter page:

Now you are ready to use your interpreter.

-

+

We provide some simple SQL to show the use of Zeppelin-IoTDB interpreter:

@@ -147,7 +147,7 @@ We provide some simple SQL to show the use of Zeppelin-IoTDB interpreter:

The screenshot is as follows:

-

+

You can also design more fantasy documents referring to [[1]](https://zeppelin.apache.org/docs/0.9.0/usage/display_system/basic.html) and others.

@@ -159,7 +159,7 @@ The above demo notebook can be found at `$IoTDB_HOME/zeppelin-interpreter/Zeppe

You can configure the connection parameters in http://127.0.0.1:8080/#/interpreter :

-

+

The parameters you can configure are as follows:

diff --git a/docs/UserGuide/Edge-Cloud-Collaboration/Sync-Tool.md b/docs/UserGuide/Edge-Cloud-Collaboration/Sync-Tool.md

index 2214646b59..4aa356db73 100644

--- a/docs/UserGuide/Edge-Cloud-Collaboration/Sync-Tool.md

+++ b/docs/UserGuide/Edge-Cloud-Collaboration/Sync-Tool.md

@@ -31,7 +31,7 @@ You can use SQL commands to start or close a synchronization task at the sender,

## 2.Model definition

-

+

Two machines A and B, which are installed with iotdb, we want to continuously synchronize the data from A to B. To better describe this process, we introduce the following concepts.

@@ -131,7 +131,7 @@ All parameters are in `$IOTDB_ HOME$/conf/iotdb-common.properties`, after all mo

- Show all PipeSink types supported by IoTDB.

-```Plain%20Text

+```

IoTDB> SHOW PIPESINKTYPE

IoTDB>

+-----+

diff --git a/docs/UserGuide/Integration-Test/Integration-Test-refactoring-tutorial.md b/docs/UserGuide/Integration-Test/Integration-Test-refactoring-tutorial.md

index 136b06116d..3fc6c6749e 100644

--- a/docs/UserGuide/Integration-Test/Integration-Test-refactoring-tutorial.md

+++ b/docs/UserGuide/Integration-Test/Integration-Test-refactoring-tutorial.md

@@ -51,7 +51,7 @@ Generally, there are three steps to finish the integration test, (1) constructin

#### 1. Integration Test Class (IT Class) and Annotations

-When writing new IT classes, the developers are encouraged to create the new ones in the [integration-test](https://github.com/apache/iotdb/tree/master/integration-test) module. Except for the classes serving the other test cases, the classes containing integration tests to evaluate the functionality of IoTDB should be named "function"+"IT". For example, the test for auto-registration metadata in IoTDB is named “<font color=green>IoTDBAutoCreateSchema</font><font color=red>IT</font>”.

+When writing new IT classes, the developers are encouraged to create the new ones in the [integration-test](https://github.com/apache/iotdb/tree/master/integration-test) module. Except for the classes serving the other test cases, the classes containing integration tests to evaluate the functionality of IoTDB should be named "function"+"IT". For example, the test for auto-registration metadata in IoTDB is named “<span style="color:green">IoTDBAutoCreateSchema</span><span style="color:red [...]

- Category`` Annotation. **When creating new IT classes, the ```@Category``` should be introduced explicitly**, and the test environment should be specified by ```LocalStandaloneIT.class```, ```ClusterIT.class```, and ```RemoteIT.class```, which corresponds to the Local Standalone, Cluster and Remote environment respectively. **In general, ```LocalStandaloneIT.class``` and ```ClusterIT.class``` should both be included**. Only in the case when some functionalities are only supported in t [...]

- RunWith Annotation. The ```@RunWith(IoTDBTestRunner.class)``` annotation should be included in every IT class.

@@ -108,7 +108,7 @@ public static void tearDown() throws Exception {

#### 3. Implementing the logic of IT

-IT of Apache IoTDB should be implemented as black-box testing. Please name the method as "functionality"+"Test", e.g., "<font color=green>selectWithAlias</font><font color=red>Test</font>". The interaction should be implemented through JDBC or Session API.

+IT of Apache IoTDB should be implemented as black-box testing. Please name the method as "functionality"+"Test", e.g., "<span style="color:green">selectWithAlias</span><span style="color:red">Test</span>". The interaction should be implemented through JDBC or Session API.

1 With JDBC

diff --git a/docs/UserGuide/IoTDB-Introduction/Architecture.md b/docs/UserGuide/IoTDB-Introduction/Architecture.md

index b6b581cb4a..bff327c3b2 100644

--- a/docs/UserGuide/IoTDB-Introduction/Architecture.md

+++ b/docs/UserGuide/IoTDB-Introduction/Architecture.md

@@ -25,7 +25,7 @@ Besides IoTDB engine, we also developed several components to provide better IoT

IoTDB suite can provide a series of functions in the real situation such as data collection, data writing, data storage, data query, data visualization and data analysis. Figure 1.1 shows the overall application architecture brought by all the components of the IoTDB suite.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://github.com/apache/iotdb-bin-resources/blob/main/docs/UserGuide/IoTDB-Introduction/Architecture/Structure%20of%20Apache%20IoTDB.png?raw=true">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/UserGuide/IoTDB-Introduction/Architecture/Structure-of-Apache-IoTDB.png?raw=true">

As shown in Figure 1.1, users can use JDBC to import timeseries data collected by sensor on the device to local/remote IoTDB. These timeseries data may be system state data (such as server load and CPU memory, etc.), message queue data, timeseries data from applications, or other timeseries data in the database. Users can also write the data directly to the TsFile (local or on HDFS).

diff --git a/docs/UserGuide/IoTDB-Introduction/Scenario.md b/docs/UserGuide/IoTDB-Introduction/Scenario.md

index 3709ba5b5a..c3e0e72ec0 100644

--- a/docs/UserGuide/IoTDB-Introduction/Scenario.md

+++ b/docs/UserGuide/IoTDB-Introduction/Scenario.md

@@ -31,11 +31,11 @@ In order to improve the quality of the printing, it is necessary for the company

At this point, the data can be stored using TsFile component, TsFileSync tool, and Hadoop/Spark integration component in the IoTDB suite.That is, each time a new chip is printed, a data is written on the SPI device using the SDK, which ultimately forms a TsFile. Through the TsFileSync tool, the generated TsFile will be synchronized to the data center according to certain rules (such as daily) and analyzed by data analysts tools.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://user-images.githubusercontent.com/13203019/51579014-695ef980-1efa-11e9-8cbc-e9e7ee4fa0d8.png">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/github/51579014-695ef980-1efa-11e9-8cbc-e9e7ee4fa0d8.png">

In this scenario, only TsFile and TsFileSync are required to be deployed on a PC, and a Hadoop/Spark cluster is required. Figure below shows the architecture at this time.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://user-images.githubusercontent.com/25913899/81768490-bf034f00-950d-11ea-9b56-fef3edca0958.png">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/github/81768490-bf034f00-950d-11ea-9b56-fef3edca0958.png">

* Scenario 2

@@ -43,11 +43,11 @@ A company has several wind turbines which are installed hundreds of sensors on e

In order to ensure the normal operation of the turbines and timely monitoring and analysis of the turbines, the company needs to collect these sensor data, perform partial calculation and analysis in the turbines working environment, and upload the original data collected to the data center.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://user-images.githubusercontent.com/13203019/51579033-7ed42380-1efa-11e9-889f-fb4180291a9e.png">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/github/51579033-7ed42380-1efa-11e9-889f-fb4180291a9e.png">

In this situation, IoTDB, TsFileSync tools, and Hadoop/Spark integration components in the IoTDB suite can be used. A PC needs to be deployed with IoTDB and TsFileSync tools installed to support reading and writing data, local computing and analysis, and uploading data to the data center. In addition, Hadoop/Spark clusters need to be deployed for data storage and analysis on the data center side. Figure below shows the architecture at this time.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://user-images.githubusercontent.com/13203019/51579064-8f849980-1efa-11e9-8cd6-a7339cd0540f.jpg">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/github/51579064-8f849980-1efa-11e9-8cd6-a7339cd0540f.jpg">

* Scenario 3

@@ -57,11 +57,11 @@ A variety of sensors are installed on each robotic device to monitor the robot's

In order to ensure that the data of the robot can be monitored and analyzed in time, the company needs to collect the information of these robot sensors, send them to the server that can connect to the external network, and then upload the original data information to the data center for complex calculation and analysis.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://user-images.githubusercontent.com/13203019/51579080-96aba780-1efa-11e9-87ac-940c45b19dd7.jpg">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/github/51579080-96aba780-1efa-11e9-87ac-940c45b19dd7.jpg">

At this point, IoTDB, IoTDB-Client tools, TsFileSync tools, and Hadoop/Spark integration components in the IoTDB suite can be used. IoTDB-Client tool is installed on the robot and each of them is connected to the LAN of the factory. When sensors generate real-time data, the data will be uploaded to the server in the factory. The IoTDB server and TsFileSync is installed on the server connected to the external network. Once triggered, the data on the server will be upload to the data cente [...]

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://user-images.githubusercontent.com/25913899/81768477-b874d780-950d-11ea-80ca-8807b9bd0970.png">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/github/81768477-b874d780-950d-11ea-80ca-8807b9bd0970.png">

* Scenario 4

@@ -73,4 +73,4 @@ At this point, IoTDB, IoTDB-Client, and Hadoop/Spark integration components in t

In addition, Hadoop/Spark clusters need to be deployed for data storage and analysis on the data center side. As shown in Figure below.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://user-images.githubusercontent.com/13203019/51579095-a4f9c380-1efa-11e9-9f95-17165ec55568.jpg">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/github/51579095-a4f9c380-1efa-11e9-9f95-17165ec55568.jpg">

diff --git a/docs/UserGuide/Maintenance-Tools/JMX-Tool.md b/docs/UserGuide/Maintenance-Tools/JMX-Tool.md

index 58f41b4489..3ac1eb645b 100644

--- a/docs/UserGuide/Maintenance-Tools/JMX-Tool.md

+++ b/docs/UserGuide/Maintenance-Tools/JMX-Tool.md

@@ -48,12 +48,12 @@ Step 4: Use jvisualvm

1. Make sure jdk 8 is installed. For versions later than jdk 8, you need to [download visualvm](https://visualvm.github.io/download.html)

2. Open jvisualvm

3. Right-click at the left navigation area -> Add JMX connection

-<img style="width:100%; max-width:300px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://user-images.githubusercontent.com/19167280/81464569-725e0200-91f5-11ea-9ff9-49745f4c9ef2.png">

+<img style="width:100%; max-width:300px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/github/81464569-725e0200-91f5-11ea-9ff9-49745f4c9ef2.png">

4. Fill in information and log in as below. Remember to check "Do not require SSL connection".

An example is:

Connection:192.168.130.15:31999

Username:iotdb

Password:passw!d

-<img style="width:100%; max-width:300px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://user-images.githubusercontent.com/19167280/81464639-ed271d00-91f5-11ea-91a0-b4fe9cb8204e.png">

+<img style="width:100%; max-width:300px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/github/81464639-ed271d00-91f5-11ea-91a0-b4fe9cb8204e.png">

diff --git a/docs/UserGuide/Maintenance-Tools/Log-Tool.md b/docs/UserGuide/Maintenance-Tools/Log-Tool.md

index 5395274642..0ce3c0512e 100644

--- a/docs/UserGuide/Maintenance-Tools/Log-Tool.md

+++ b/docs/UserGuide/Maintenance-Tools/Log-Tool.md

@@ -35,14 +35,14 @@ Here we use JConsole to connect with JMX.

Start the JConsole, establish a new JMX connection with the IoTDB Server (you can select the local process or input the IP and PORT for remote connection, the default operation port of the IoTDB JMX service is 31999). Fig 4.1 shows the connection GUI of JConsole.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://user-images.githubusercontent.com/13203019/51577195-f94d7500-1ef3-11e9-999a-b4f67055d80e.png">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/github/51577195-f94d7500-1ef3-11e9-999a-b4f67055d80e.png">

After connected, click `MBean` and find `ch.qos.logback.classic.default.ch.qos.logback.classic.jmx.JMXConfigurator`(As shown in fig 4.2).

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://user-images.githubusercontent.com/13203019/51577204-fe122900-1ef3-11e9-9e89-2eb1d46e24b8.png">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/github/51577204-fe122900-1ef3-11e9-9e89-2eb1d46e24b8.png">

In the JMXConfigurator Window, there are 6 operations provided, as shown in fig 4.3. You can use these interfaces to perform operation.

-<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="https://user-images.githubusercontent.com/13203019/51577216-09fdeb00-1ef4-11e9-9005-542ad7d9e9e0.png">

+<img style="width:100%; max-width:800px; max-height:600px; margin-left:auto; margin-right:auto; display:block;" src="/img/github/51577216-09fdeb00-1ef4-11e9-9005-542ad7d9e9e0.png">

#### Interface Instruction

diff --git a/docs/UserGuide/Maintenance-Tools/Maintenance-Command.md b/docs/UserGuide/Maintenance-Tools/Maintenance-Command.md

index eeb441de97..28e1051919 100644

--- a/docs/UserGuide/Maintenance-Tools/Maintenance-Command.md

+++ b/docs/UserGuide/Maintenance-Tools/Maintenance-Command.md

@@ -121,7 +121,7 @@ This command is used to display all ongoing queries, here are usage scenarios:

### Grammar

-```SQL

+```sql

SHOW QUERIES | (QUERY PROCESSLIST)

[WHERE whereCondition]

[ORDER BY sortKey {ASC | DESC}]

@@ -153,7 +153,7 @@ Note:

#### Example1:Obtain all current queries whose execution time is longer than 30 seconds

SQL string:

-```SQL

+```sql

SHOW QUERIES WHERE ElapsedTime > 30

```

@@ -173,12 +173,12 @@ SQL result: