You are viewing a plain text version of this content. The canonical link for it is here.

Posted to commits@doris.apache.org by lu...@apache.org on 2023/07/26 03:16:05 UTC

[doris-website] branch master updated: [feature](i18n) remove zh_CN (#272)

This is an automated email from the ASF dual-hosted git repository.

luzhijing pushed a commit to branch master

in repository https://gitbox.apache.org/repos/asf/doris-website.git

The following commit(s) were added to refs/heads/master by this push:

new be1fbfafb97 [feature](i18n) remove zh_CN (#272)

be1fbfafb97 is described below

commit be1fbfafb97be1df40ed3c63c11abc96892e9d19

Author: Jeffrey <co...@gmail.com>

AuthorDate: Wed Jul 26 11:15:59 2023 +0800

[feature](i18n) remove zh_CN (#272)

---

i18n/zh-CN/code.json | 798 -------------------

.../docusaurus-plugin-content-blog/1.1 Release.md | 400 ----------

i18n/zh-CN/docusaurus-plugin-content-blog/360.md | 175 ----

.../docusaurus-plugin-content-blog/Annoucing.md | 74 --

.../BestPractice_Kwai.md | 181 -----

.../docusaurus-plugin-content-blog/Compaction.md | 219 -----

.../Data Lakehouse.md | 290 -------

i18n/zh-CN/docusaurus-plugin-content-blog/Douyu.md | 192 -----

.../docusaurus-plugin-content-blog/Duyansoft.md | 192 -----

.../Flink-realtime-write.md | 159 ----

i18n/zh-CN/docusaurus-plugin-content-blog/HCDS.md | 343 --------

i18n/zh-CN/docusaurus-plugin-content-blog/HYXJ.md | 275 -------

.../High_concurrency.md | 319 --------

.../Inverted Index.md | 281 -------

.../docusaurus-plugin-content-blog/JD_OLAP.md | 88 --

i18n/zh-CN/docusaurus-plugin-content-blog/LY.md | 129 ---

.../Memory_Management.md | 184 -----

.../Midland Realty.md | 249 ------

i18n/zh-CN/docusaurus-plugin-content-blog/Moka.md | 163 ----

i18n/zh-CN/docusaurus-plugin-content-blog/NIO.md | 223 ------

.../docusaurus-plugin-content-blog/Netease.md | 253 ------

.../Tencent Music.md | 312 --------

.../docusaurus-plugin-content-blog/Tianyancha.md | 175 ----

i18n/zh-CN/docusaurus-plugin-content-blog/jd.md | 136 ----

.../docusaurus-plugin-content-blog/linkedcare.md | 259 ------

.../docusaurus-plugin-content-blog/meituan.md | 182 -----

.../docusaurus-plugin-content-blog/options.json | 14 -

.../principle-of-Doris-SQL-parsing.md | 273 -------

.../principle-of-Doris-Stream-Load.md | 131 ---

.../release-1.1.1.md | 83 --

.../release-1.1.2.md | 94 ---

.../release-1.1.3.md | 94 ---

.../release-1.1.4.md | 75 --

.../release-1.1.5.md | 70 --

.../release-1.2.0.md | 624 ---------------

.../release-1.2.1.md | 195 -----

.../release-1.2.3.md | 173 ----

.../release-note-0.15.0.md | 225 ------

.../release-note-1.0.0.md | 254 ------

.../docusaurus-plugin-content-blog/scenario.md | 213 -----

i18n/zh-CN/docusaurus-plugin-content-blog/ssb.md | 616 --------------

.../zh-CN/docusaurus-plugin-content-blog/summit.md | 200 -----

i18n/zh-CN/docusaurus-plugin-content-blog/tpch.md | 884 ---------------------

.../zh-CN/docusaurus-plugin-content-blog/xiaomi.md | 240 ------

.../xiaomi_vector.md | 168 ----

.../current.json | 30 -

i18n/zh-CN/docusaurus-theme-classic/footer.json | 46 --

i18n/zh-CN/docusaurus-theme-classic/navbar.json | 30 -

src/pages/users/index.tsx | 3 +-

src/theme/BlogListPage/index.tsx | 5 +-

src/theme/Footer/Links/MultiColumn/index.tsx | 17 +-

.../NavbarItem/LocaleDropdownNavbarItem/index.tsx | 4 +

userCases/zh_CN.json | 86 --

53 files changed, 9 insertions(+), 11089 deletions(-)

diff --git a/i18n/zh-CN/code.json b/i18n/zh-CN/code.json

deleted file mode 100644

index 9fc5e106da2..00000000000

--- a/i18n/zh-CN/code.json

+++ /dev/null

@@ -1,798 +0,0 @@

-{

- "theme.blog.post.readingTime.plurals": {

- "message": "{readingTime} 分钟阅读",

- "description": "Pluralized label for \"{readingTime} min read\". Use as much plural forms (separated by \"|\") as your language support (see https://www.unicode.org/cldr/cldr-aux/charts/34/supplemental/language_plural_rules.html)"

- },

- "theme.ErrorPageContent.title": {

- "message": "页面已崩溃。",

- "description": "The title of the fallback page when the page crashed"

- },

- "theme.ErrorPageContent.tryAgain": {

- "message": "重试",

- "description": "The label of the button to try again when the page crashed"

- },

- "theme.NotFound.title": {

- "message": "找不到页面",

- "description": "The title of the 404 page"

- },

- "theme.NotFound.p1": {

- "message": "我们找不到您要找的页面。",

- "description": "The first paragraph of the 404 page"

- },

- "theme.NotFound.p2": {

- "message": "请联系原始链接来源网站的所有者,并告知他们链接已损坏。",

- "description": "The 2nd paragraph of the 404 page"

- },

- "theme.AnnouncementBar.closeButtonAriaLabel": {

- "message": "关闭",

- "description": "The ARIA label for close button of announcement bar"

- },

- "theme.BackToTopButton.buttonAriaLabel": {

- "message": "回到顶部",

- "description": "The ARIA label for the back to top button"

- },

- "theme.blog.archive.title": {

- "message": "历史博文",

- "description": "The page & hero title of the blog archive page"

- },

- "theme.blog.archive.description": {

- "message": "历史博文",

- "description": "The page & hero description of the blog archive page"

- },

- "theme.blog.paginator.navAriaLabel": {

- "message": "博文列表分页导航",

- "description": "The ARIA label for the blog pagination"

- },

- "theme.blog.paginator.newerEntries": {

- "message": "较新的博文",

- "description": "The label used to navigate to the newer blog posts page (previous page)"

- },

- "theme.blog.paginator.olderEntries": {

- "message": "较旧的博文",

- "description": "The label used to navigate to the older blog posts page (next page)"

- },

- "theme.blog.post.readMoreLabel": {

- "message": "阅读 {title} 的全文",

- "description": "The ARIA label for the link to full blog posts from excerpts"

- },

- "theme.blog.post.readMore": {

- "message": "阅读更多",

- "description": "The label used in blog post item excerpts to link to full blog posts"

- },

- "theme.blog.post.paginator.navAriaLabel": {

- "message": "博文分页导航",

- "description": "The ARIA label for the blog posts pagination"

- },

- "theme.blog.post.paginator.newerPost": {

- "message": "较新一篇",

- "description": "The blog post button label to navigate to the newer/previous post"

- },

- "theme.blog.post.paginator.olderPost": {

- "message": "较旧一篇",

- "description": "The blog post button label to navigate to the older/next post"

- },

- "theme.blog.post.plurals": {

- "message": "{count} 篇博文",

- "description": "Pluralized label for \"{count} posts\". Use as much plural forms (separated by \"|\") as your language support (see https://www.unicode.org/cldr/cldr-aux/charts/34/supplemental/language_plural_rules.html)"

- },

- "theme.blog.tagTitle": {

- "message": "{nPosts} 含有标签「{tagName}」",

- "description": "The title of the page for a blog tag"

- },

- "theme.tags.tagsPageLink": {

- "message": "查看所有标签",

- "description": "The label of the link targeting the tag list page"

- },

- "theme.colorToggle.ariaLabel": {

- "message": "切换浅色/暗黑模式(当前为{mode})",

- "description": "The ARIA label for the navbar color mode toggle"

- },

- "theme.colorToggle.ariaLabel.mode.dark": {

- "message": "暗黑模式",

- "description": "The name for the dark color mode"

- },

- "theme.colorToggle.ariaLabel.mode.light": {

- "message": "浅色模式",

- "description": "The name for the light color mode"

- },

- "theme.docs.breadcrumbs.home": {

- "message": "主页面",

- "description": "The ARIA label for the home page in the breadcrumbs"

- },

- "theme.docs.breadcrumbs.navAriaLabel": {

- "message": "页面路径",

- "description": "The ARIA label for the breadcrumbs"

- },

- "theme.docs.DocCard.categoryDescription": {

- "message": "{count} 个项目",

- "description": "The default description for a category card in the generated index about how many items this category includes"

- },

- "theme.docs.paginator.navAriaLabel": {

- "message": "文档分页导航",

- "description": "The ARIA label for the docs pagination"

- },

- "theme.docs.paginator.previous": {

- "message": "上一页",

- "description": "The label used to navigate to the previous doc"

- },

- "theme.docs.paginator.next": {

- "message": "下一页",

- "description": "The label used to navigate to the next doc"

- },

- "theme.docs.tagDocListPageTitle.nDocsTagged": {

- "message": "{count} 篇文档带有标签",

- "description": "Pluralized label for \"{count} docs tagged\". Use as much plural forms (separated by \"|\") as your language support (see https://www.unicode.org/cldr/cldr-aux/charts/34/supplemental/language_plural_rules.html)"

- },

- "theme.docs.tagDocListPageTitle": {

- "message": "{nDocsTagged}「{tagName}」",

- "description": "The title of the page for a docs tag"

- },

- "theme.docs.versionBadge.label": {

- "message": "版本:{versionLabel}"

- },

- "theme.docs.versions.unreleasedVersionLabel": {

- "message": "此为 {siteTitle} {versionLabel} 版本的文档。",

- "description": "The label used to tell the user that he's browsing an unreleased doc version"

- },

- "theme.docs.versions.unmaintainedVersionLabel": {

- "message": "此为 {siteTitle} {versionLabel} 版的文档,现已不再积极维护。",

- "description": "The label used to tell the user that he's browsing an unmaintained doc version"

- },

- "theme.docs.versions.latestVersionSuggestionLabel": {

- "message": "最新的文档请参阅 {latestVersionLink} ({versionLabel})。",

- "description": "The label used to tell the user to check the latest version"

- },

- "theme.docs.versions.latestVersionLinkLabel": {

- "message": "最新版本",

- "description": "The label used for the latest version suggestion link label"

- },

- "theme.common.editThisPage": {

- "message": "编辑此页",

- "description": "The link label to edit the current page"

- },

- "theme.common.headingLinkTitle": {

- "message": "标题的直接链接",

- "description": "Title for link to heading"

- },

- "theme.lastUpdated.atDate": {

- "message": "于 {date} ",

- "description": "The words used to describe on which date a page has been last updated"

- },

- "theme.lastUpdated.byUser": {

- "message": "由 {user} ",

- "description": "The words used to describe by who the page has been last updated"

- },

- "theme.lastUpdated.lastUpdatedAtBy": {

- "message": "最后{byUser}{atDate}更新",

- "description": "The sentence used to display when a page has been last updated, and by who"

- },

- "theme.navbar.mobileVersionsDropdown.label": {

- "message": "选择版本",

- "description": "The label for the navbar versions dropdown on mobile view"

- },

- "theme.common.skipToMainContent": {

- "message": "跳到主要内容",

- "description": "The skip to content label used for accessibility, allowing to rapidly navigate to main content with keyboard tab/enter navigation"

- },

- "theme.tags.tagsListLabel": {

- "message": "标签:",

- "description": "The label alongside a tag list"

- },

- "theme.blog.sidebar.navAriaLabel": {

- "message": "最近博文导航",

- "description": "The ARIA label for recent posts in the blog sidebar"

- },

- "theme.CodeBlock.copied": {

- "message": "复制成功",

- "description": "The copied button label on code blocks"

- },

- "theme.CodeBlock.copyButtonAriaLabel": {

- "message": "复制代码到剪贴板",

- "description": "The ARIA label for copy code blocks button"

- },

- "theme.CodeBlock.copy": {

- "message": "复制",

- "description": "The copy button label on code blocks"

- },

- "theme.CodeBlock.wordWrapToggle": {

- "message": "切换自动换行",

- "description": "The title attribute for toggle word wrapping button of code block lines"

- },

- "theme.DocSidebarItem.toggleCollapsedCategoryAriaLabel": {

- "message": "打开/收起侧边栏菜单「{label}」",

- "description": "The ARIA label to toggle the collapsible sidebar category"

- },

- "theme.navbar.mobileLanguageDropdown.label": {

- "message": "选择语言",

- "description": "The label for the mobile language switcher dropdown"

- },

- "theme.TOCCollapsible.toggleButtonLabel": {

- "message": "本页总览",

- "description": "The label used by the button on the collapsible TOC component"

- },

- "theme.docs.sidebar.collapseButtonTitle": {

- "message": "收起侧边栏",

- "description": "The title attribute for collapse button of doc sidebar"

- },

- "theme.docs.sidebar.collapseButtonAriaLabel": {

- "message": "收起侧边栏",

- "description": "The title attribute for collapse button of doc sidebar"

- },

- "theme.navbar.mobileSidebarSecondaryMenu.backButtonLabel": {

- "message": "← 回到主菜单",

- "description": "The label of the back button to return to main menu, inside the mobile navbar sidebar secondary menu (notably used to display the docs sidebar)"

- },

- "theme.docs.sidebar.expandButtonTitle": {

- "message": "展开侧边栏",

- "description": "The ARIA label and title attribute for expand button of doc sidebar"

- },

- "theme.docs.sidebar.expandButtonAriaLabel": {

- "message": "展开侧边栏",

- "description": "The ARIA label and title attribute for expand button of doc sidebar"

- },

- "theme.SearchBar.noResultsText": {

- "message": "没有找到任何文档"

- },

- "theme.SearchBar.seeAll": {

- "message": "查看全部结果"

- },

- "theme.SearchBar.label": {

- "message": "搜索",

- "description": "The ARIA label and placeholder for search button"

- },

- "theme.SearchPage.existingResultsTitle": {

- "message": "“{query}” 的搜索结果",

- "description": "The search page title for non-empty query"

- },

- "theme.SearchPage.emptyResultsTitle": {

- "message": "搜索文档",

- "description": "The search page title for empty query"

- },

- "theme.SearchPage.documentsFound.plurals": {

- "message": "共找到 {count} 篇文档",

- "description": "Pluralized label for \"{count} documents found\". Use as much plural forms (separated by \"|\") as your language support (see https://www.unicode.org/cldr/cldr-aux/charts/34/supplemental/language_plural_rules.html)"

- },

- "theme.SearchPage.noResultsText": {

- "message": "没有找到任何文档",

- "description": "The paragraph for empty search result"

- },

- "homepage.more": {

- "message": "了解更多",

- "description": "more link"

- },

- "coreFeatures.title.f1": {

- "message": "简单易用"

- },

- "coreFeatures.subTitle.f1": {

- "message": "部署只需两个进程,不依赖其他系统;在线集群扩缩容,自动副本修复;兼容 MySQL 协议,并且使用标准 SQL"

- },

- "coreFeatures.title.f2": {

- "message": "高性能"

- },

- "coreFeatures.subTitle.f2": {

- "message": "依托列式存储引擎、现代的 MPP 架构、向量化查询引擎、预聚合物化视图、数据索引的实现,在低延迟和高吞吐查询上, 都达到了极速性能"

- },

- "coreFeatures.title.f3": {

- "message": "统一数仓"

- },

- "coreFeatures.subTitle.f3": {

- "message": "单一系统,可以同时支持实时数据服务、交互数据分析和离线数据处理场景"

- },

- "coreFeatures.title.f4": {

- "message": "联邦查询"

- },

- "coreFeatures.subTitle.f4": {

- "message": "支持对 Hive、Iceberg、Hudi 等数据湖和 MySQL、Elasticsearch 等数据库的联邦查询分析"

- },

- "coreFeatures.title.f5": {

- "message": "多种导入"

- },

- "coreFeatures.subTitle.f5": {

- "message": "支持从 HDFS/S3 等批量拉取导入和 MySQL Binlog/Kafka 等流式拉取导入;支持通过HTTP接口进行微批量推送写入和 JDBC 中使用 Insert 实时推送写入"

- },

- "coreFeatures.title.f6": {

- "message": "生态丰富"

- },

- "coreFeatures.subTitle.f6": {

- "message": "Spark 利用 Spark Doris Connector 读取和写入 Doris;Flink Doris Connector 配合 Flink CDC 实现数据 Exactly Once 写入 Doris;利用 DBT Doris Adapter,可以很容易的在 Doris 中完成数据转化"

- },

- "community.title.c1": {

- "message": "邮件列表"

- },

- "community.title.c2": {

- "message": "讨论区"

- },

- "community.title.c3": {

- "message": "参与贡献"

- },

- "community.title.c4": {

- "message": "源代码"

- },

- "community.title.c5": {

- "message": "改进建议"

- },

- "community.title.c6": {

- "message": "Doris 团队"

- },

- "homepage.news": {

- "message": "1月6日-7日,Doris Summit 2022 于线上全面开启!",

- "description": "The label for the link to homepage news"

- },

- "homepage.what": {

- "message": "Apache Doris 定位",

- "description": "What is Apache Doris"

- },

- "homepage.features": {

- "message": "核心优势",

- "description": "Core Features"

- },

- "homepage.join": {

- "message": "加入社区",

- "description": "Join The Community"

- },

- "homepage.start.title": {

- "message": "准备踏上 Doris 之旅 ?"

- },

- "homepage.start.downloadButton": {

- "message": "下载"

- },

- "homepage.start.docsButton": {

- "message": "文档"

- },

- "learnmore": {

- "message": "了解更多"

- },

- "sotry.summary.meituan": {

- "message": "Apache Doris 可以较好地处理汇总与明细数据查询、变化维的历史回溯、非预设维的灵活应用、准实时的批处理等场景。"

- },

- "sotry.summary.jindong": {

- "message": "Apache Doris 不仅可以应对海量数据的秒级查询,更可以满足实时、准实时的分析需求。"

- },

- "footer.follow": {

- "message": "分享",

- "description": "Footer Follow"

- },

- "download.quick.download": {

- "message": "快速下载",

- "description": "Quick Download"

- },

- "download.release": {

- "message": "所有版本"

- },

- "download.flink.connector": {

- "message": "Flink Doris Connector",

- "description": "Flink Doris Connector"

- },

- "download.maven": {

- "message": "Maven",

- "description": "Maven"

- },

- "download.spark.connector": {

- "message": "Spark Doris Connector",

- "description": "Spark Doris Connector"

- },

- "download.verify": {

- "message": "验证",

- "description": "Verify"

- },

- "doc.version": {

- "message": "版本",

- "description": "Version"

- },

- "footer.language": {

- "message": "语言",

- "description": "Footer Language"

- },

- "download.binary.version": {

- "message": "二进制版本",

- "description": "Binary Version"

- },

- "download.cpu.model": {

- "message": "CPU 型号",

- "description": "CPU Model"

- },

- "download.jdk.version": {

- "message": "JDK 版本",

- "description": "JDK Version"

- },

- "download.download.link": {

- "message": "下载链接",

- "description": "Download"

- },

- "download.quick.download.intr.prefix": {

- "message": "如果 CPU 不支持 avx2 指令集,请选择 noavx2 版本,您可以通过"

- },

- "download.quick.download.intr.suffix": {

- "message": "查看 CPU 是否支持。avx2 指令将会提升 Bloom Filter 等数据结构的计算效率。"

- },

- "download.release.more": {

- "message": "查看更多"

- },

- "download.all.release.version": {

- "message": "版本"

- },

- "download.all.release.date": {

- "message": "发布日期"

- },

- "download.all.release.note": {

- "message": "版本通告"

- },

- "download.flink.connector.version": {

- "message": "版本"

- },

- "download.flink.release.date": {

- "message": "发布日期"

- },

- "download.flink.version": {

- "message": "Flink 版本"

- },

- "download.flink.scala.version": {

- "message": "Scala 版本"

- },

- "download.flink.doris.version": {

- "message": "Doris 版本"

- },

- "download.spark.connector.version": {

- "message": "版本"

- },

- "download.spark.release.date": {

- "message": "发布日期"

- },

- "download.spark.version": {

- "message": "Spark 版本"

- },

- "download.spark.scala.version": {

- "message": "Scala 版本"

- },

- "download.spark.doris.version": {

- "message": "Doris 版本"

- },

- "download.verify.w1": {

- "message": "关于如何校验下载文件,请参阅 "

- },

- "download.verify.w2": {

- "message": "校验下载文件"

- },

- "download.verify.w3": {

- "message": ",并使用这些"

- },

- "download.verify.w4": {

- "message": "KEYS"

- },

- "download.verify.w5": {

- "message": "。校验完成后,可以参阅"

- },

- "download.verify.w6": {

- "message": "编译文档"

- },

- "download.verify.w7": {

- "message": "以及"

- },

- "download.verify.w8": {

- "message": "安装与部署文档"

- },

- "download.verify.w9": {

- "message": "进行 Doris 的编译、安装与部署。"

- },

- "user.companies": {

- "message": "他们都在使用 Apache Doris",

- "description": "Companies That Trust Apache Doris"

- },

- "user.case": {

- "message": "案例研究",

- "description": "Case Studies"

- },

- "user.add..your.company": {

- "message": "添加你的企业信息",

- "description": "Add Your Company"

- },

- "homepage.banner.title": {

- "message": "Apache Doris"

- },

- "homepage.banner.subTitle": {

- "message": "简单易用、高性能和统一的分析数据库"

- },

- "download.all.release.download": {

- "message": "下载"

- },

- "download.source.binary": {

- "message": "源码 / 二进制"

- },

- "download.all.binary": {

- "message": "二进制"

- },

- "download.source": {

- "message": "源码"

- },

- "download": {

- "message": "下载"

- },

- "homepage.banner.button1": {

- "message": "快速开始"

- },

- "sotry.summary.xiaomi": {

- "message": "Apache Doris 在小米得到了广泛的使用,目前已经服务了数十个业务,并形成了一套以 Apache Doris 为核心的数据生态。"

- },

- "navbar.download": {

- "message": "下载"

- },

- "homepage.title": {

- "message": "首页"

- },

- "download.title": {

- "message": "下载"

- },

- "users.title": {

- "message": "用户"

- },

- "sitemap.title": {

- "message": "学习路径"

- },

- "sitemap.subTitle": {

- "message": ""

- },

- "sitemap.page.title": {

- "message": "学习路径"

- },

- "documentation.feedback": {

- "message": "问题反馈"

- },

- "theme.PwaReloadPopup.info": {

- "message": "有可用的新版本",

- "description": "The text for PWA reload popup"

- },

- "theme.PwaReloadPopup.refreshButtonText": {

- "message": "刷新",

- "description": "The text for PWA reload button"

- },

- "theme.PwaReloadPopup.closeButtonAriaLabel": {

- "message": "关闭",

- "description": "The ARIA label for close button of PWA reload popup"

- },

- "Introduction to Apache Doris": {

- "message": "Apache Doris 总体介绍"

- },

- "Get Started": {

- "message": "快速开始"

- },

- "Installation and deployment": {

- "message": "安装部署"

- },

- "Compilation": {

- "message": "源码编译"

- },

- "Table Design": {

- "message": "数据表设计"

- },

- "Data Model": {

- "message": "数据模型"

- },

- "Data Partition": {

- "message": "数据划分"

- },

- "Guidelines for Creating Table": {

- "message": "建表指南"

- },

- "Rollup and Query": {

- "message": "Rollup与查询"

- },

- "Practices of Creating Table": {

- "message": "建表实践"

- },

- "Index": {

- "message": "索引"

- },

- "Data Import": {

- "message": "数据导入"

- },

- "Import Overview": {

- "message": "导入总览"

- },

- "Import Local Data": {

- "message": "导入本地数据"

- },

- "Import External Storage Data": {

- "message": "导入外部存储数据"

- },

- "Subscribe Kafka Data": {

- "message": "订阅 Kafka 日志"

- },

- "Synchronize Data Through External Table": {

- "message": "通过外部表同步数据"

- },

- "Data Export": {

- "message": "数据导出"

- },

- "Export Data": {

- "message": "导出数据"

- },

- "Export Query Result": {

- "message": "导出查询结果集"

- },

- "Export Table Structure or Data": {

- "message": "导出表结构或数据"

- },

- "Data Backup": {

- "message": "数据备份"

- },

- "Update and Delete": {

- "message": "数据更新及删除"

- },

- "Update": {

- "message": "数据更新"

- },

- "Delete": {

- "message": "删除操作"

- },

- "Batch Delete": {

- "message": "批量删除"

- },

- "Sequence Column": {

- "message": "Sequence 列"

- },

- "Advanced Usage": {

- "message": "进阶使用"

- },

- "Schema Change": {

- "message": "表结构变更"

- },

- "Dynamic Partition": {

- "message": "动态分区"

- },

- "Data Cache": {

- "message": "数据缓存"

- },

- "Join Optimization": {

- "message": "Join 优化"

- },

- "Materialized view": {

- "message": "物化视图"

- },

- "BITMAP Precise De-duplication": {

- "message": "BITMAP 精确去重"

- },

- "HLL ApproximateDe-duplication": {

- "message": "HLL 近似去重"

- },

- "Variables": {

- "message": "变量"

- },

- "Time Zone": {

- "message": "时区"

- },

- "File Manager": {

- "message": "文件管理器"

- },

- "Ecosystem": {

- "message": "生态拓展"

- },

- "Doris on ES": {

- "message": "Doris on ES"

- },

- "Doris on Hudi": {

- "message": "Doris on Hudi"

- },

- "Doris on Iceberg": {

- "message": "Doris on Iceberg"

- },

- "Doris on Hive": {

- "message": "Doris on Hive"

- },

- "Doris on ODBC": {

- "message": "Doris on ODBC"

- },

- "Spark Doris Connector": {

- "message": "Spark Doris Connector"

- },

- "Flink Doris Connector": {

- "message": "Flink Doris Connector"

- },

- "Seatunnel Connector": {

- "message": "Seatunnel Connector"

- },

- "DataX doriswriter": {

- "message": "DataX doriswriter"

- },

- "UDF": {

- "message": "UDF"

- },

- "Audit log plugin": {

- "message": "审计日记插件"

- },

- "SQL Manual": {

- "message": "SQL 手册"

- },

- "SQL Function": {

- "message": "SQL 函数"

- },

- "DDL": {

- "message": "DDL"

- },

- "DML": {

- "message": "DML"

- },

- "Data Types": {

- "message": "数据类型"

- },

- "Utility": {

- "message": "辅助命令"

- },

- "Cluster Management": {

- "message": "集群管理"

- },

- "Cluster Upgrade": {

- "message": "集群升级"

- },

- "Elastic scaling": {

- "message": "弹性扩缩容"

- },

- "Statistics of query execution": {

- "message": "查询分析"

- },

- "Maintenance and Monitor": {

- "message": "监控报警"

- },

- "Metadata Operation": {

- "message": "元数据运维"

- },

- "Error Code": {

- "message": "错误码"

- },

- "Config": {

- "message": "配置管理"

- },

- "Authority Management": {

- "message": "权限管理"

- },

- "Multi-tenancy": {

- "message": "多租户与资源管理"

- },

- "FAQ": {

- "message": "常见问题"

- },

- "FAQs of Operation and Maintenance": {

- "message": "运维常见问题"

- },

- "FAQs of Data Operation": {

- "message": "数据操作问题"

- },

- "SQL FAQs": {

- "message": "SQL 问题"

- },

- "sitemap.page.subTitle": {

- "message": "从这里开启您的 Apache Doris 之旅,与 Apache Doris 一起发现无限可能"

- },

- "download.quick.download.version.tips": {

- "message": "apache-doris-1.1.2-bin-x86-noavx2 版本暂不提供下载,我们会在进行更新。"

- },

- "Notice": {

- "message": "注意事项"

- },

- "download.quick.download.notice": {

- "message": "1.2.1 版本暂不支持使用 JDK11 运行,会在后续版本修复。"

- },

- "1.2.6": {

- "message": "Apache Doris 1.2.6 is released now.",

- "description": "Apache Doris 1.2.6 is released now."

- },

- "download.document": {

- "message": "Document",

- "description": "文档"

- },

- "user.logos": {

- "message": "Companies That Trust Apache Doris",

- "description": "Companies That Trust Apache Doris"

- },

- "user.user-case": {

- "message": "Companies Powerd by Apache Doris",

- "description": "Companies Powerd by Apache Doris"

- },

- "user.case-description": {

- "message": "There are more than 1,000 companies worldwide leveraging Apache Doris to build their unified data analytical database. Some of them are listed below:",

- "description": "There are more than 1,000 companies worldwide leveraging Apache Doris to build their unified\n data analytical database. Some of them are listed below:"

- },

- "download.version": {

- "message": "版本",

- "description": "Binary Version"

- }

-}

\ No newline at end of file

diff --git a/i18n/zh-CN/docusaurus-plugin-content-blog/1.1 Release.md b/i18n/zh-CN/docusaurus-plugin-content-blog/1.1 Release.md

deleted file mode 100644

index 94b2882c27b..00000000000

--- a/i18n/zh-CN/docusaurus-plugin-content-blog/1.1 Release.md

+++ /dev/null

@@ -1,400 +0,0 @@

----

-{

- 'title': 'Apache Doris 1.1 Release 版本正式发布',

- 'summary': '亲爱的社区小伙伴们,我们很高兴地宣布,Apache Doris 在 2022 年 7 月 14 日迎来 1.1 Release 版本的正式发布!这是 Apache Doris 正式从 Apache 孵化器毕业后并成为 Apache 顶级项目后发布的第一个 Release 版本。在 1.1 版本中,有 90 位 Contributor 为 Apache Doris 提交了超过 450 项优化和修复,感谢每一个让 Apache Doris 变得更好的你!',

- 'date': '2022-07-14',

- 'author': 'Apache Doris',

- 'tags': ['版本发布'],

-}

----

-

-<!--

-Licensed to the Apache Software Foundation (ASF) under one

-or more contributor license agreements. See the NOTICE file

-distributed with this work for additional information

-regarding copyright ownership. The ASF licenses this file

-to you under the Apache License, Version 2.0 (the

-"License"); you may not use this file except in compliance

-with the License. You may obtain a copy of the License at

-

- http://www.apache.org/licenses/LICENSE-2.0

-

-Unless required by applicable law or agreed to in writing,

-software distributed under the License is distributed on an

-"AS IS" BASIS, WITHOUT WARRANTIES OR CONDITIONS OF ANY

-KIND, either express or implied. See the License for the

-specific language governing permissions and limitations

-under the License.

--->

-

-亲爱的社区小伙伴们,我们很高兴地宣布,Apache Doris 在 2022 年 7 月 14 日迎来 1.1 Release 版本的正式发布!这是 Apache Doris 正式从 Apache 孵化器毕业后并成为 Apache 顶级项目后发布的第一个 Release 版本。在 1.1 版本中,有 90 位 Contributor 为 Apache Doris 提交了超过 450 项优化和修复,感谢每一个让 Apache Doris 变得更好的你!

-

-在 1.1 版本中,**我们实现了计算层和存储层的全面向量化、正式将向量化执行引擎作为稳定功能进行全面启用**,所有查询默认通过向量化执行引擎来执行,**性能较之前版本有 3-5 倍的巨大提升**;增加了直接访问 Apache Iceberg 外部表的能力,支持对 Doris 和 Iceberg 中的数据进行联邦查询,**扩展了 Apache Doris 在数据湖上的分析能力**;在原有的 LZ4 基础上增加了 ZSTD 压缩算法,进一步提升了数据压缩率;**修复了诸多之前版本存在的性能与稳定性问题**,使系统稳定性得到大幅提升。欢迎大家下载使用。

-

-## 升级说明

-

-### 向量化执行引擎默认开启

-

-在 Apache Doris 1.0 版本中,我们引入了向量化执行引擎作为实验性功能。用户需要在执行 SQL 查询手工开启,通过 `set batch_size = 4096` 和 `set enable_vectorized_engine = true `配置 session 变量来开启向量化执行引擎。

-

-在 1.1 版本中,我们正式将向量化执行引擎作为稳定功能进行了全面启用,session 变量`enable_vectorized_engine` 默认设置为 true,无需用户手工开启,所有查询默认通过向量化执行引擎来执行。

-

-### BE 二进制文件更名

-

-BE 二进制文件从原有的 palo_be 更名为 doris_be ,如果您以前依赖进程名称进行集群管理和其他操作,请注意修改相关脚本。

-

-### Segment 存储格式升级

-

-Apache Doris 早期版本的存储格式为 Segment V1,在 0.12 版本中我们实现了新的存储格式 Segment V2 ,引入了 Bitmap 索引、内存表、Page Cache、字典压缩以及延迟物化等诸多特性。从 0.13 版本开始,新建表的默认存储格式为 Segment V2,与此同时也保留了对 Segment V1 格式的兼容。

-

-为了保证代码结构的可维护性、降低冗余历史代码带来的额外学习及开发成本,我们决定从下一个版本起不再支持 Segment v1 存储格式,预计在 Apache Doris 1.2 版本中将删除这部分代码,还请所有仍在使用 Segment V1 存储格式的用户务必在 1.1 版本中完成数据格式的转换,操作手册请参考以下链接:

-

-[https://doris.apache.org/zh-CN/docs/1.0/administrator-guide/segment-v2-usage

-](https://doris.apache.org/zh-CN/docs/1.0/administrator-guide/segment-v2-usage)

-

-### 正常升级

-

-正常升级操作请按照官网上的集群升级文档进行滚动升级即可。

-

-[https://doris.apache.org/zh-CN/docs/admin-manual/cluster-management/upgrade](https://doris.apache.org/zh-CN/docs/admin-manual/cluster-management/upgrade)

-

-## 重要功能

-

-### 支持数据随机分布 [实验性功能] [#8259](https://github.com/apache/doris/pull/8259) [#8041](https://github.com/apache/doris/pull/8041)

-

-在某些场景中(例如日志分析类场景),用户可能无法找到一个合适的分桶键来避免数据倾斜,因此需要由系统提供额外的分布方式来解决数据倾斜的问题。

-

-因此通过在建表时可以不指定具体分桶键,选择使用随机分布对数据进行分桶`DISTRIBUTED BY random BUCKET number`,数据导入时将会随机写入单个 Tablet ,以减少加载过程中的数据扇出,并减少资源开销、提升系统稳定性。

-

-### 支持创建 Iceberg 外部表 [实验性功能] [#7391](https://github.com/apache/doris/pull/7391) [#7981](https://github.com/apache/doris/pull/7981) [#8179](https://github.com/apache/doris/pull/8179)

-

-Iceberg 外部表为 Apache Doris 提供了直接访问存储在 Iceberg 数据的能力。通过 Iceberg 外部表可以实现对本地存储和 Iceberg 存储的数据进行联邦查询,省去繁琐的数据加载工作、简化数据分析的系统架构,并进行更复杂的分析操作。

-

-在 1.1 版本中,Apache Doris 支持了创建 Iceberg 外部表并查询数据,并支持通过 REFRESH 命令实现 Iceberg 数据库中所有表 Schema 的自动同步。

-

-### 增加 ZSTD 压缩算法 [#8923](https://github.com/apache/doris/pull/8923) [#9747](https://github.com/apache/doris/pull/9747)

-

-目前 Apache Doris 中数据压缩方法是系统统一指定的,默认为 LZ4。针对部分对数据存储成本敏感的场景,例如日志类场景,原有的数据压缩率需求无法得到满足。

-

-在 1.1 版本中,用户建表时可以在表属性中设置`"compression"="zstd"` 将压缩方法指定为 ZSTD。在 25GB 1.1 亿行的文本日志测试数据中,**最高获得了近 10 倍的压缩率、较原有压缩率提升了 53%,从磁盘读取数据并进行解压缩的速度提升了 30%** 。

-

-## 功能优化

-

-### **更全面的向量化支持**

-

-在 1.1 版本中,我们实现了计算层和存储层的全面向量化,包括:

-

-- 实现了所有内置函数的向量化

-

-- 存储层实现向量化,并支持了低基数字符串列的字典优化

-

-- 优化并解决了向量化引擎的大量性能和稳定性问题。

-

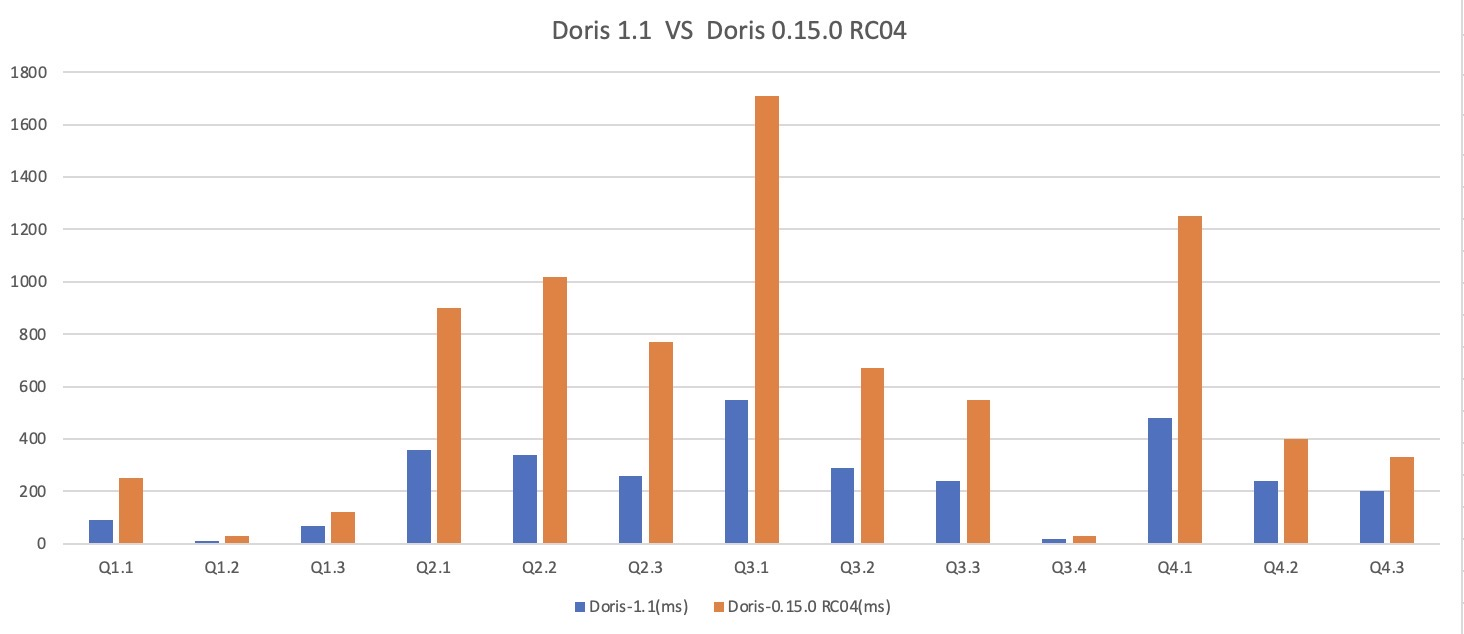

-我们对 Apache Doris 1.1 版本与 0.15 版本分别在 SSB 和 TPC-H 标准测试数据集上进行了性能测试:

-

-- 在 SSB 测试数据集的全部 13 个 SQL 上,1.1 版本均优于 0.15 版本,整体性能约提升了 3 倍,解决了 1.0 版本中存在的部分场景性能劣化问题;

-

-- 在 TPC-H 测试数据集的全部 22 个 SQL 上,1.1 版本均优于 0.15 版本,整体性能约提升了 4.5 倍,部分场景性能达到了十余倍的提升;

-

-

-

-<p align='center'>SSB 测试数据集</p>

-

-

-

-<p align='center'>TPC-H 测试数据集</p>

-

-**性能测试报告:**

-

-[https://doris.apache.org/zh-CN/docs/benchmark/ssb](https://doris.apache.org/zh-CN/docs/benchmark/ssb)

-

-[https://doris.apache.org/zh-CN/docs/benchmark/tpch](https://doris.apache.org/zh-CN/docs/benchmark/tpch)

-

-### Compaction 逻辑优化与实时性保证 [#10153](https://github.com/apache/doris/pull/10153)

-

-在 Apache Doris 中每次 Commit 都会产生一个数据版本,在高并发写入场景下,容易出现因数据版本过多且 Compaction 不及时而导致的 -235 错误,同时查询性能也会随之下降。

-

-在 1.1 版本中我们引入了 QuickCompaction,增加了主动触发式的 Compaction 检查,在数据版本增加的时候主动触发 Compaction,同时通过提升分片元信息扫描的能力,快速发现数据版本过多的分片并触发 Compaction。通过主动式触发加被动式扫描的方式,彻底解决数据合并的实时性问题。

-

-同时,针对高频的小文件 Cumulative Compaction,实现了 Compaction 任务的调度隔离,防止重量级的 Base Compaction 对新增数据的合并造成影响。

-

-最后,针对小文件合并,优化了小文件合并的策略,采用梯度合并的方式,每次参与合并的文件都属于同一个数据量级,防止大小差别很大的版本进行合并,逐渐有层次的合并,减少单个文件参与合并的次数,能够大幅地节省系统的 CPU 消耗。

-

-

-

-在数据上游维持每秒 10w 的写入频率时(20 个并发写入任务、每个作业 5000 行、 Checkpoint 间隔 1s),1.1 版本表现如下:

-

-- 数据快速合并:Tablet 数据版本维持在 50 以下,Compaction Score 稳定。相较于之前版本高并发写入时频繁出现的 -235 问题,**Compaction 合并效率有 10 倍以上的提升**。

-

-<!---->

-

-- CPU 资源消耗显著降低:针对小文件 Compaction 进行了策略优化,在上述高并发写入场景下,**CPU 资源消耗降低 25%** ;

-

-<!---->

-

-- 查询耗时稳定:提升了数据整体有序性,大幅降低查询耗时的波动性,**高并发写入时的查询耗时与仅查询时持平**,查询性能较之前版本**有 3-4 倍提升**。

-

-

-

-### Parquet 和 ORC 文件的读取效率优化 [#9472](https://github.com/apache/doris/pull/9472)

-

-通过调整 Arrow 参数,利用 Arrow 的多线程读取能力来加速 Arrow 对每个 row_group 的读取,并修改成 SPSC 模型,通过预取来降低等待网络的代价。优化前后对 Parquet 文件导入的性能有 4 ~ 5 倍的提升。

-

-### 更安全的元数据 Checkpoint [#9180](https://github.com/apache/doris/pull/9180) [#9192](https://github.com/apache/doris/pull/9192)

-

-通过对元数据检查点后生成的 image 文件进行双重检查和保留历史 image 文件的功能,解决了 image 文件错误导致的元数据损坏问题。

-

-## Bug 修复

-

-### 修复由于缺少数据版本而无法查询数据的问题。(严重)[#9267](https://github.com/apache/doris/pull/9267) [#9266](https://github.com/apache/doris/pull/9266)

-

-问题描述:`failed to initialize storage reader. tablet=924991.xxxx, res=-214, backend=xxxx`

-

-该问题是在版本 1.0 中引入的,可能会导致多个副本的数据版本丢失。

-

-### 解决了资源隔离对加载任务的资源使用限制无效的问题(中等)[#9492](https://github.com/apache/doris/pull/9492)

-

-在 1.1 版本中, Broker Load 和 Routine Load 将使用具有指定资源标记的 BE 节点进行加载。

-

-### 修复使用 HTTP BRPC 超过 2GB 传输网络数据包导致数据传输错误的问题(中等)[#9770](https://github.com/apache/doris/pull/9770)

-

-在以前的版本中,当通过 BRPC 在后端之间传输的数据超过 2GB 时,可能会导致数据传输错误。

-

-## 其他

-

-### 禁用 Mini Load

-

-Mini Load 与 Stream Load 的导入实现方式完全一致,都是通过 HTTP 协议提交和传输数据,在导入功能支持上 Stream Load 更加完备。

-

-在 1.1 版本中,默认情况下 Mini Load 接口 `/_load` 将处于禁用状态,请统一使用 Stream Load 来替换 Mini Load。您也可以通过关闭 FE 配置项 `disable_mini_load` 来重新启用 Mini Load 接口。在版本 1.2 中,将彻底删除 Mini Load 。

-

-### 完全禁用 SegmentV1 存储格式

-

-在 1.1 版本中将不再允许新创建 SegmentV1 存储格式的数据,现有数据仍可以继续正常访问。

-

-您可以使用 ADMIN SHOW TABLET STORAGE FORMAT 语句检查集群中是否仍然存在 SegmentV1 格式的数据,如果存在请务必通过数据转换命令转换为 SegmentV2。

-

-在 Apache Doris 1.2 版本中不再支持对 Segment V1 数据的访问,同时 Segment V1 代码将被彻底删除。

-

-### 限制 String 类型的最大长度 [#8567](https://github.com/apache/doris/pull/8567)

-

-String 类型是 Apache Doris 在 0.15 版本中引入的新数据类型,在过去 String 类型的最大长度允许为 2GB。

-

-在 1.1 版本中,我们将 String 类型的最大长度限制为 1 MB,超过此长度的字符串无法再写入,同时不再支持将 String 类型用作表的 Key 列、分区列以及分桶列。

-

-已写入的字符串类型可以正常访问。

-

-### 修复 fastjson 相关漏洞 [#9763](https://github.com/apache/doris/pull/9763)

-

-对 Canal 版本进行更新以修复 fastjson 安全漏洞

-

-### 添加了 ADMIN DIAGNOSE TABLET 命令 [#8839](https://github.com/apache/doris/pull/8839)

-

-通过 ADMIN DIAGNOSE TABLET tablet_id 命令可以快速诊断指定 Tablet 的问题。

-

-## 下载使用

-

-### 下载链接

-

-[https://doris.apache.org/zh-CN/download](https://doris.apache.org/zh-CN/download)

-

-### 升级说明

-

-您可以从 Apache Doris 1.0 Release 版本和 1.0.x 发行版本升级到 1.1 Release 版本,升级过程请官网参考文档。如果您当前是 0.15 Release 版本或 0.15.x 发行版本,可跳过 1.0 版本直接升级至 1.1。

-

-[https://doris.apache.org/zh-CN/docs/admin-manual/cluster-management/upgrade](https://doris.apache.org/zh-CN/docs/admin-manual/cluster-management/upgrade

-

-### 意见反馈

-

-如果您遇到任何使用上的问题,欢迎随时通过 GitHub Discussion 论坛或者 Dev 邮件组与我们取得联系。

-

-GitHub 论坛:[https://github.com/apache/incubator-doris/discussions](https://github.com/apache/incubator-doris/discussions)

-

-Dev 邮件组:[dev@doris.apache.org](dev@doris.apache.org)

-

-## 致谢

-

-Apache Doris 1.1 Release 版本的发布离不开所有社区用户的支持,在此向所有参与版本设计、开发、测试、讨论的社区贡献者们表示感谢,他们分别是:

-

-```

-

-@adonis0147

-

-@airborne12

-

-@amosbird

-

-@aopangzi

-

-@arthuryangcs

-

-@awakeljw

-

-@BePPPower

-

-@BiteTheDDDDt

-

-@bridgeDream

-

-@caiconghui

-

-@cambyzju

-

-@ccoffline

-

-@chenlinzhong

-

-@daikon12

-

-@DarvenDuan

-

-@dataalive

-

-@dataroaring

-

-@deardeng

-

-@Doris-Extras

-

-@emerkfu

-

-@EmmyMiao87

-

-@englefly

-

-@Gabriel39

-

-@GoGoWen

-

-@gtchaos

-

-@HappenLee

-

-@hello-stephen

-

-@Henry2SS

-

-@hewei-nju

-

-@hf200012

-

-@jacktengg

-

-@jackwener

-

-@Jibing-Li

-

-@JNSimba

-

-@kangshisen

-

-@Kikyou1997

-

-@kylinmac

-

-@Lchangliang

-

-@leo65535

-

-@liaoxin01

-

-@liutang123

-

-@lovingfeel

-

-@luozenglin

-

-@luwei16

-

-@luzhijing

-

-@mklzl

-

-@morningman

-

-@morrySnow

-

-@nextdreamblue

-

-@Nivane

-

-@pengxiangyu

-

-@qidaye

-

-@qzsee

-

-@SaintBacchus

-

-@SleepyBear96

-

-@smallhibiscus

-

-@spaces-X

-

-@stalary

-

-@starocean999

-

-@steadyBoy

-

-@SWJTU-ZhangLei

-

-@Tanya-W

-

-@tarepanda1024

-

-@tianhui5

-

-@Userwhite

-

-@wangbo

-

-@wangyf0555

-

-@weizuo93

-

-@whutpencil

-

-@wsjz

-

-@wunan1210

-

-@xiaokang

-

-@xinyiZzz

-

-@xlwh

-

-@xy720

-

-@yangzhg

-

-@Yankee24

-

-@yiguolei

-

-@yinzhijian

-

-@yixiutt

-

-@zbtzbtzbt

-

-@zenoyang

-

-@zhangstar333

-

-@zhangyifan27

-

-@zhannngchen

-

-@zhengshengjun

-

-@zhengshiJ

-

-@zingdle

-

-@zuochunwei

-

-@zy-kkk

-```

diff --git a/i18n/zh-CN/docusaurus-plugin-content-blog/360.md b/i18n/zh-CN/docusaurus-plugin-content-blog/360.md

deleted file mode 100644

index b38178a5c4e..00000000000

--- a/i18n/zh-CN/docusaurus-plugin-content-blog/360.md

+++ /dev/null

@@ -1,175 +0,0 @@

----

-{

- 'title': '日增百亿数据,查询结果秒出, Apache Doris 在 360商业化的统一 OLAP 应用实践',

- 'summary': "360商业化为助力业务团队更好推进商业化增长,实时数仓共经历了三种模式的演进,分别是 Storm + Druid + MySQL 模式、Flink + Druid + TiDB 的模式 以及 Flink + Doris 的模式,基于 Apache Doris 的新一代架构的成功落地使得 360商业化团队完成了实时数仓在 OLAP 引擎上的统一,成功实现广泛实时场景下的秒级查询响应。本文将为大家进行详细介绍演进过程以及新一代实时数仓在广告业务场景中的具体落地实践。",

- 'date': '2023-06-01',

- 'author': '360商业化数据团队',

- 'tags': ['最佳实践'],

-}

-

-

----

-

-<!--

-Licensed to the Apache Software Foundation (ASF) under one

-or more contributor license agreements. See the NOTICE file

-distributed with this work for additional information

-regarding copyright ownership. The ASF licenses this file

-to you under the Apache License, Version 2.0 (the

-"License"); you may not use this file except in compliance

-with the License. You may obtain a copy of the License at

-

- http://www.apache.org/licenses/LICENSE-2.0

-

-Unless required by applicable law or agreed to in writing,

-software distributed under the License is distributed on an

-"AS IS" BASIS, WITHOUT WARRANTIES OR CONDITIONS OF ANY

-KIND, either express or implied. See the License for the

-specific language governing permissions and limitations

-under the License.

--->

-

-**导读**:360商业化为助力业务团队更好推进商业化增长,实时数仓共经历了三种模式的演进,分别是 Storm + Druid + MySQL 模式、Flink + Druid + TIDB 的模式 以及 Flink + Doris 的模式,基于 [Apache Doris](https://doris.apache.org/) 的新一代架构的成功落地使得 360商业化团队完成了实时数仓在 OLAP 引擎上的统一,成功实现广泛实时场景下的秒级查询响应。本文将为大家进行详细介绍演进过程以及新一代实时数仓在广告业务场景中的具体落地实践。

-

-作者|360商业化数据团队 窦和雨、王新新

-

-360 公司致力于成为互联网和安全服务提供商,是互联网免费安全的倡导者,先后推出 360安全卫士、360手机卫士、360安全浏览器等安全产品以及 360导航、360搜索等用户产品。

-

-360商业化依托 360产品庞大的用户覆盖能力和超强的用户粘性,通过专业数据处理和算法实现广告精准投放,助力数十万中小企业和 KA 企业实现价值增长。360商业化数据团队主要是对整个广告投放链路中所产生的数据进行计算处理,为产品运营团队提供策略调整的分析数据,为算法团队提供模型训练的优化数据,为广告主提供广告投放的效果数据。

-

-## 业务场景

-

-在正式介绍 Apache Doris 在 360 商业化的应用之前,我们先对广告业务中的典型使用场景进行简要介绍:

-

-- **实时大盘:** 实时大盘场景是我们对外呈现数据的关键载体,需要从多个维度监控商业化大盘的指标情况,包括流量指标、消费指标、转化指标和变现指标,因此其对数据的准确性要求非常高(保证数据不丢不重),同时对数据的时效性和稳定性要求也很高,要求实现秒级延迟、分钟级数据恢复。

-- **广告账户的实时消费数据场景:** 通过监控账户粒度下的多维度指标数据,及时发现账户的消费变化,便于产品团队根据实时消费情况推动运营团队对账户预算进行调整。在该场景下数据一旦出现问题,就可能导致账户预算的错误调整,从而影响广告的投放,这对公司和广告主将造成不可估量的损失,因此在该场景中,同样对数据准确性有很高的要求。目前在该场景下遇到的困难是如何在数据量比较大、查询交叉的粒度比较细的前提下,实现秒级别查询响应。

-- **AB 实验平台:** 在广告业务中,算法和策略同学会针对不同的场景进行实验,在该场景下,具有报表维度不固定、多种维度灵活组合、数据分析比较复杂、数据量较大等特点,这就需要可以在百万级 QPS 下保证数据写入存储引擎的性能,因此我们需要针对业务场景进行特定的模型设计和处理上的优化,提高实时数据处理的性能以及数据查询分析的效率,只有这样才能满足算法和策略同学对实验报表的查询分析需求。

-

-

-## 实时数仓演进

-

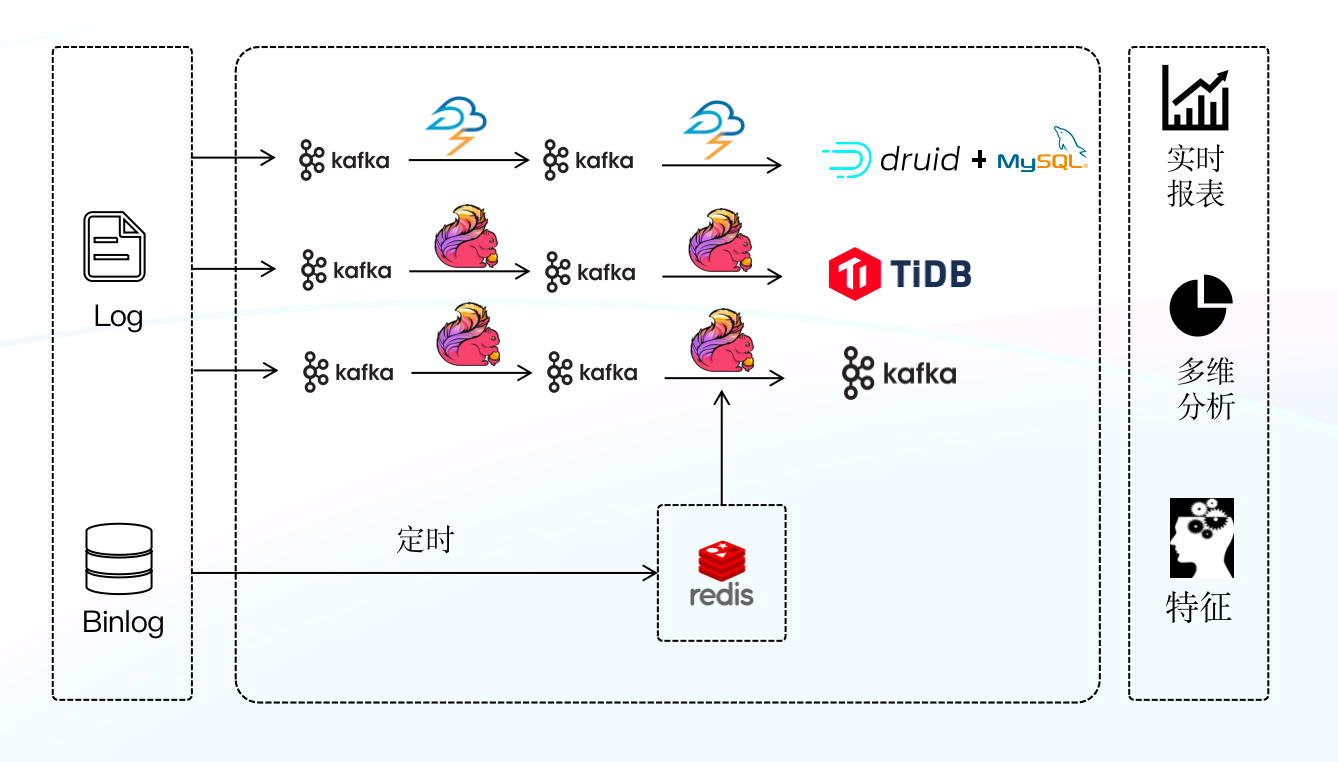

-为提升各场景下数据服务的效率,助力相关业务团队更好推进商业化增长,截至目前实时数仓共经历了三种模式的演进,分别是 Storm + Druid + MySQL 模式、Flink + Druid + TIDB 的模式 以及 Flink + Doris 的模式,本文将为大家进行详细介绍实时数仓演进过程以及新一代实时数仓在广告业务场景中的具体落地。

-

-### 第一代架构

-

-该阶段的实时数仓是基于 Storm + Druid + MySQL 来构建的,Storm 为实时处理引擎,数据经 Storm 处理后,将数据写入 Druid ,利用 Druid 的预聚合能力对写入数据进行聚合。

-

-

-

-**架构痛点:**

-

-最初我们试图依靠该架构解决业务上所有的实时问题,经由 Druid 统一对外提供数据查询服务,但是在实际的落地过程中我们发现 Druid 是无法满足某些分页查询和 Join 场景的,为解决该问题,我们只能利用 MySQL 定时任务的方式将数据定时从 Druid 写入 MySQL 中(类似于将 MySQL 作为 Druid 的物化视图),再通过 Druid + MySQL 的模式对外提供服务。通过这种方式暂时可以满足某些场景需求,但随着业务规模的逐步扩大,当面对更大规模数据下的查询分析需求时,该架构已难以为继,架构的缺陷也越发明显:

-

-- 面对数据量的持续增长,数据仓库压力空前剧增,已无法满足实时数据的时效性要求。

-- MySQL 的分库分表维护难度高、投入成本大,且 MySQL 表之间的数据一致性无法保障。

-

-

-### 第二代架构

-

-

-

-基于第一套架构存在的问题,我们进行了首次升级,这次升级的主要变化是将 Storm 替换成新的实时数据处理引擎 Flink ,Flink 相较于 Storm 不仅在许多语义和功能上进行了扩展,还对数据的一致性做了保证,这些特性使得报表的时效性大幅提升;其次我们使用 TiDB 替换了 MySQL ,利用 TIDB 分布式的特性,一定程度上解决了 MySQL 分库分表难以维护的问题(TiDB 在一定程度上比 MySQL 能够承载更大数据量,可以拆分更少表)。在升级完成后,我们按照不同业务场景的需求,将 Flink 处理完的数据分别写入 Druid 和 TiDB ,由 Druid 和 TIDB 对外提供数据查询服务。

-

-

-**架构痛点:**

-

-虽然该阶段的实时数仓架构有效提升了数据的时效性、降低了 MySQL 分库分表维护的难度,但在一段时间的使用之后又暴露出了新的问题,也迫使我们进行了第二次升级:

-

-- Flink + TIDB 无法实现端到端的一致性,原因是当其面对大规模的数据时,开启事务将对 TiDB 写入性能造成很大的影响,该场景下 TiDB 的事务形同虚设,心有余而力不足。

-- Druid 不支持标准 SQL ,使用有一定的门槛,相关团队使用数据时十分不便,这也直接导致了工作效率的下降。

-- 维护成本较高,需要维护两套引擎和两套查询逻辑,极大增加了维护和开发成本的投入。

-

-

-### 新一代实时数仓架构

-

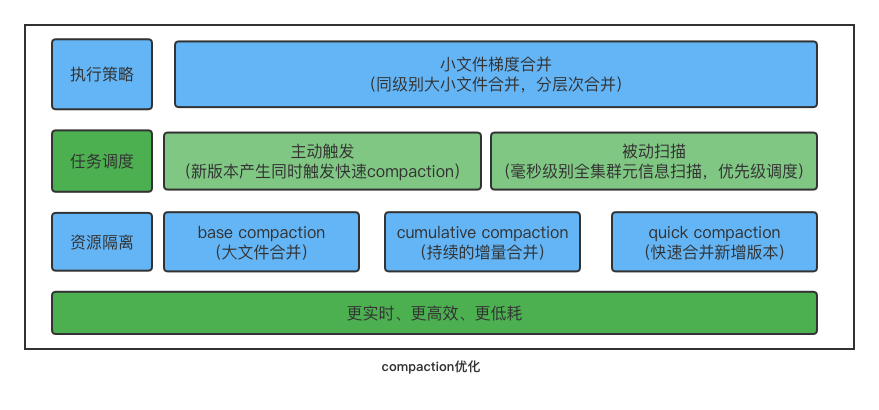

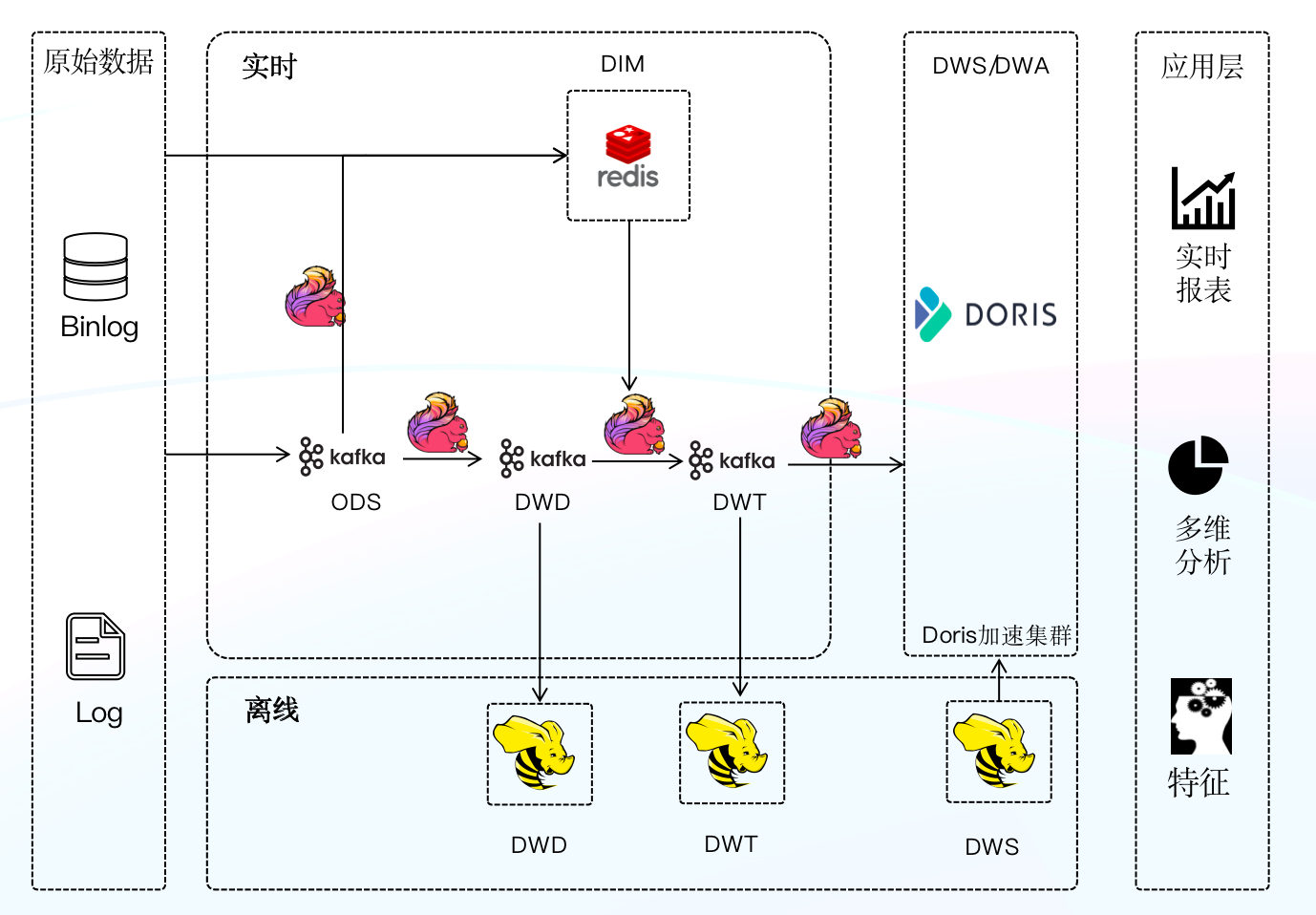

-第二次升级我们引入 Apache Doris 结合 Flink 构建了新一代实时数仓架构,借鉴离线数仓分层理念对实时数仓进行分层构建,并统一 Apache Doris 作为数仓 OLAP 引擎,由 Doris 统一对外提供服务。

-

-

-

-我们的数据主要源自于维表物料数据和业务打点日志。维表物料数据会定时全量同步到 Redis 或者 Aerospike (类似于 Redis 的 KV 存储)中,通过 Binlog 变更进行增量同步。业务数据由各个团队将日志收集到 Kafka,内部称为 ODS 原始数据(ODS 原始数据不做任何处理),我们对 ODS 层的数据进行归一化处理,包括字段命名、字段类型等,并对一些无效字段进行删减,并根据业务场景拆分生成 DWD 层数据,DWD 层的数据通过业务逻辑加工以及关联 Redis 中维表数据或者多流 Join,最后生成面向具体业务的大宽表(即 DWT 层数据),我们将 DWT 层数据经过聚合、经由 Stream Load 写入 Doris 中,由 Doris 对外提供数据查询服务。在离线数仓部分,同样也有一些场景需要每日将加工完的 DWS 数据经由 Broker Load 写入到 Doris 集群中,并利用 Doris 进行查询加速,以提升我们对外�

��供服务的效率。

-

-

-## 选择 Doris 的原因

-

-基于 Apache Doris 高性能、极简易用、实时统一等诸多特性,助力 360商业化成功构建了新一代实时数仓架构,本次升级不仅提升了实时数据的复用性、实现了 OLAP 引擎的统一,而且满足了各大业务场景严苛的数据查询分析需求,使得整体实时数据流程架构变得简单,大大降低了其维护和使用的成本。我们选择 Doris 作为统一 OLAP 引擎的重要原因大致可归结为以下几点:

-

-- **物化视图:** Doris 的物化视图与广告业务场景的特点契合度非常高,比如广告业务中大部分报表的查询维度相对比较固定,利用物化视图的特性可以提升查询的效率,同时 Doris 可以保证物化视图和底层数据的一致性,该特性可帮助我们降低维护成本的投入。

-- **数据一致性:** Doris 提供了 Stream Load Label 机制,我们可通过事务的方式与 Flink 二阶段提交进行结合,以保证幂等写入数据,另外我们通过自研 Flink Sink Doris 组件,实现了数据的端到端的一致性,保证了数据的准确性。

-- **SQL 协议兼容**:Doris 兼容 MySQL 协议,支持标准 SQL,这无论是对于开发同学,还是数据分析、产品同学,都可以实现无成本衔接,相关同学直接使用 SQL 就可以进行查询,使用门槛很低,为公司节省了大量培训和使用成本,同时也提升了工作效率。

-- **优秀的查询性能:** Apache Doris 已全面实现向量化查询引擎,使 Doris 的 OLAP 性能表现更加强悍,在多种查询场景下都有非常明显的性能提升,可极大优化了报表的询速度。同时依托列式存储引擎、现代的 MPP 架构、预聚合物化视图、数据索引的实现,在低延迟和高吞吐查询上,都达到了极速性能

-- **运维难度低:** Doris 对于集群和和数据副本管理上做了很多自动化工作,这些投入使得集群运维起来非常的简单,近乎于实现零门槛运维。

-

-## 在 AB 实验平台的具体落地

-

-Apache Doris 目前广泛应用于 360商业化内部的多个业务场景。比如在实时大盘场景中,我们利用 Doris 的 Aggregate 模型对请求、曝光、点击、转化等多个实时流进行事实表的 Join ;依靠 Doris 事务特性保证数据的一致性;通过多个物化视图,提前根据报表维度聚合数据、提升查询速度,由于物化视图和 Base 表的一致关系由 Doris 来维护保证,这也极大的降低了使用复杂度。比如在账户实时消费场景中,我们主要借助 Doris 优秀的查询优化器,通过 Join 来计算同环比......

-

-**接下来仅以 AB 实验平台这一典型业务场景为例,详尽的为大家介绍 Doris 在该场景下的落地实践,在上述所举场景中的应用将不再赘述。**

-

-

-AB 实验在广告场景中的应用非常广泛,是衡量设计、算法、模型、策略对产品指标提升的重要工具,也是精细化运营的重要手段,我们可以通过 AB实验平台对迭代方案进行测试,并结合数据进行分析和验证,从而优化产品方案、提升广告效果。

-

-在文章开头也有简单介绍,AB 实验场景所承载的业务相对比较复杂,这里再详细说明一下:

-

-- 各维度之间组合灵活度很高,例如需要对从 DSP 到流量类型再到广告位置等十几个维度进行分析,完成从请求、竞价、曝光、点击、转化等几十个指标的完整流量漏斗。

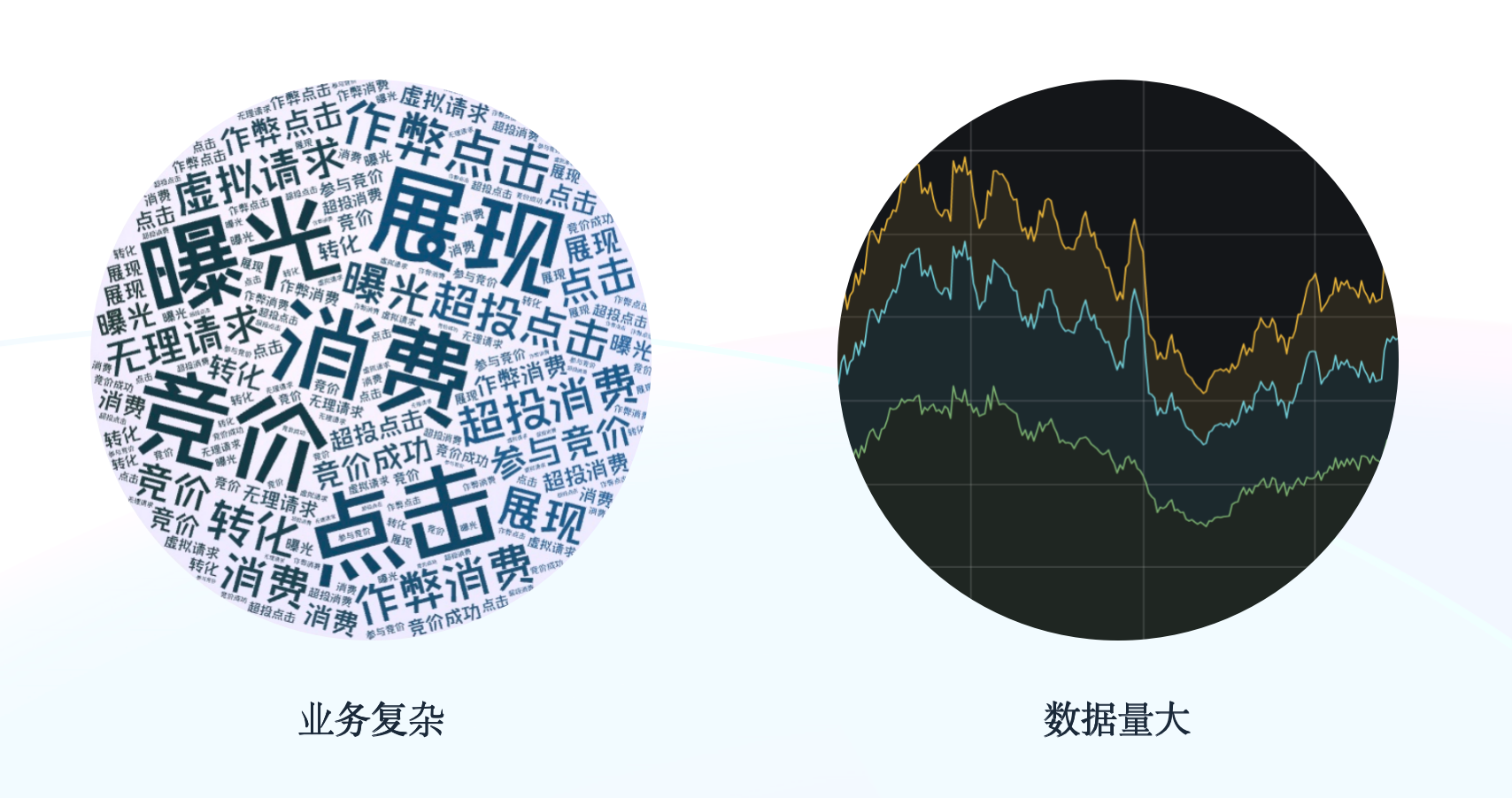

-- 数据量巨大,日均流量可以达到**百亿级别**,峰值可达**百万OPS**(Operations Per Second),一条流量可能包含**几十个实验标签 ID**。

-

-基于以上特点,我们在 AB实验场景中一方面需要保证数据算的快、数据延迟低、用户查询数据快,另一方面也要保证数据的准确性,保障数据不丢不重。

-

-

-

-

-### 数据落地

-

-当面对一条流量可能包含几十个实验标签 ID 的情况时,从分析角度出发,只需要选中一个实验标签和一个对照实验标签进行分析;而如果通过`like`的方式在几十个实验标签中去匹配选中的实验标签,实现效率就会非常低。

-

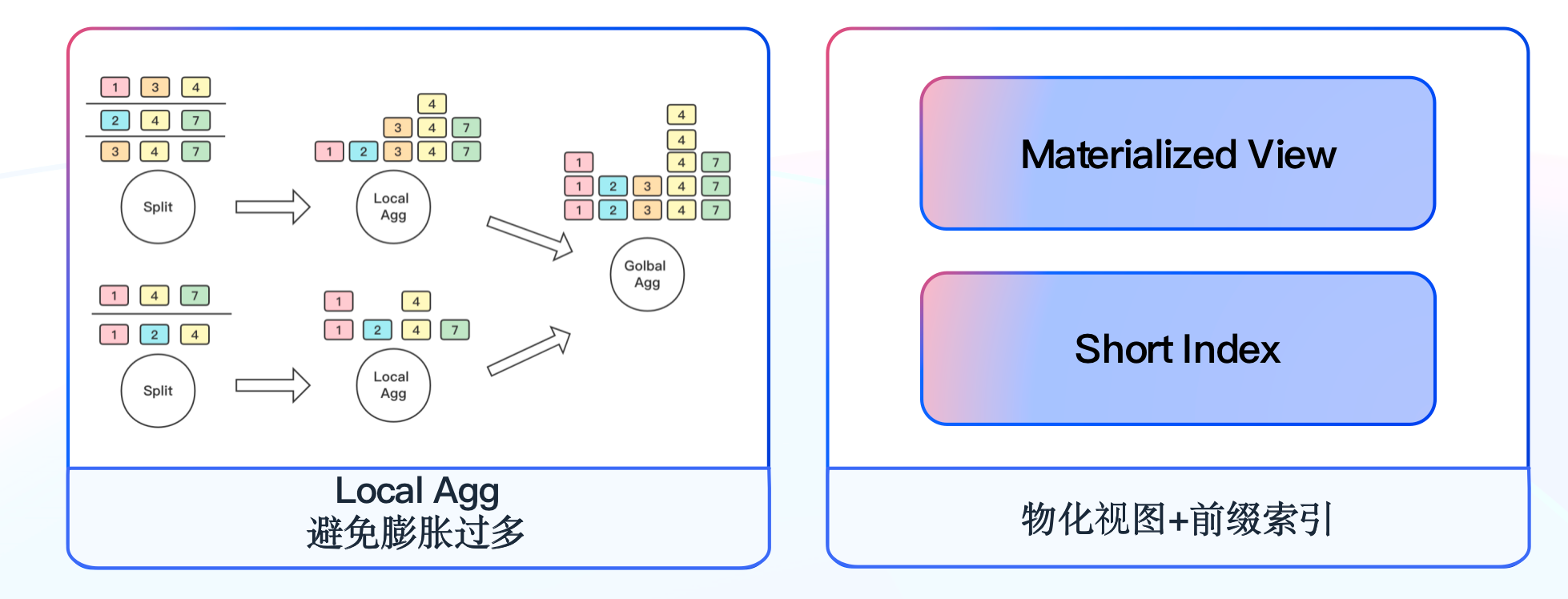

-最初我们期望从数据入口处将实验标签打散,将一条包含 20 个实验标签的流量拆分为 20 条只包含一个实验标签的流量,再导入 Doris 的聚合模型中进行数据分析。而在这个过程中我们遇到一个明显的问题,当数据被打散之后会膨胀数十倍,百亿级数据将膨胀为千亿级数据,即便 Doris 聚合模型会对数据再次压缩,但这个过程会对集群造成极大的压力。因此我们放弃该实现方式,开始尝试将压力分摊一部分到计算引擎,这里需要注意的是,如果将数据直接在 Flink 中打散,当 Job 全局 Hash 的窗口来 Merge 数据时,膨胀数十倍的数据也会带来几十倍的网络和 CPU 消耗。

-

-

-接着我们开始第三次尝试,这次尝试我们考虑在 Flink 端将数据拆分后立刻进行 Local Merge,在同一个算子的内存中开一个窗口,先将拆分的数据进行一层聚合,再通过 Job 全局 Hash 窗口进行第二层聚合,因为 Chain 在一起的两个算子在同一个线程内,因此可以大幅降低膨胀后数据在不同算子之间传输的网络消耗。该方式**通过两层窗口的聚合,再结合 Doris 的聚合模型,有效降低了数据的膨胀程度**,其次我们也同步推动实业务方定期清理已下线的实验,减少计算资源的浪费。

-

-

-

-考虑到 AB实验分析场景的特点,我们将实验 ID 作为 Doris 的第一个排序字段,利用前缀索引可以很快定位到目标查询的数据。另外根据常用的维度组合建立物化视图,进一步缩小查询的数据量,**Doris 物化视图基本能够覆盖 80% 的查询场景**,我们会定期分析查询 SQL 来调整物化视图。**最终我们通过模型的设计、前缀索引的应用,结合物化视图能力,使大部分实验查询结果能够实现秒级返回。**

-

-

-### 数据一致性保障

-

-数据的准确性是 AB实验平台的基础,当算法团队呕心沥血优化的模型使广告效果提升了几个百分点,却因数据丢失看不出实验效果,这样的结果确实无法令人接受,同时这也是我们内部不允许出现的问题。那么我们该如何避免数据丢失、保障数据的一致性呢?

-

-#### **自研 Flink Sink Doris 组件**

-

-我们内部已有一套 Flink Stream API 脚手架,因此借助 Doris 的幂等写特性和 Flink 的二阶段提交特性,自研了 Sink To Doris 组件,保证了数据端到端的一致性,并在此基础上新增了异常情况的数据保障机制。

-

-

-

-在 Doris 0.14 版本中(初期使用的版本),我们一般通过“同一个 Label ID 只会被写入一次”的机制来保证数据的一致性;在 Doris 1.0 版本之后,通过 “Doris 的事务结合 Flink 二阶段提交”的机制来保证数据的一致性。这里详细分享使用 Doris 1.0 版本之后,通过 “Doris 的事务结合 Flink 二阶段提交”机制保证数据的一致性的原理与实现。

-

-> 在 Flink 中做到数据端到端的一致性有两种方式,一种为通过至少一次结合幂等写,一种为通过恰好一次的二阶段事务。

-

-如右图所示,我们首先在数据写入阶段先将数据写入本地文件,一阶段过程中将数据预提交到 Doris,并保存事务 ID 到状态,如果 Checkpoint 失败,则手动放弃 Doris 事务;如果 Checkpoint 成功,则在二阶段进行事务提交。对于二阶段提交重试多次仍然失败的数据,将提供数据以及事务 ID 保存到 HDFS 的选项,通过 Broker Load 进行手动恢复。为了避免单次提交数据量过大,而导致 Stream Load 时长超过 Flink Checkpoint 时间的情况,我们提供了将单次 Checkpoint 拆分为多个事务的选项。**最终成功通过二阶段提交的机制实现了对数据一致性的保障。**

-

-

-**应用展示**

-

-下图为 Sink To Doris 的具体应用,整体工具屏蔽了 API 调用以及拓扑流的组装,只需要通过简单的配置即可完成 Stream Load 到 Doris 的数据写入 。

-

-

-

-

-### 集群监控

-

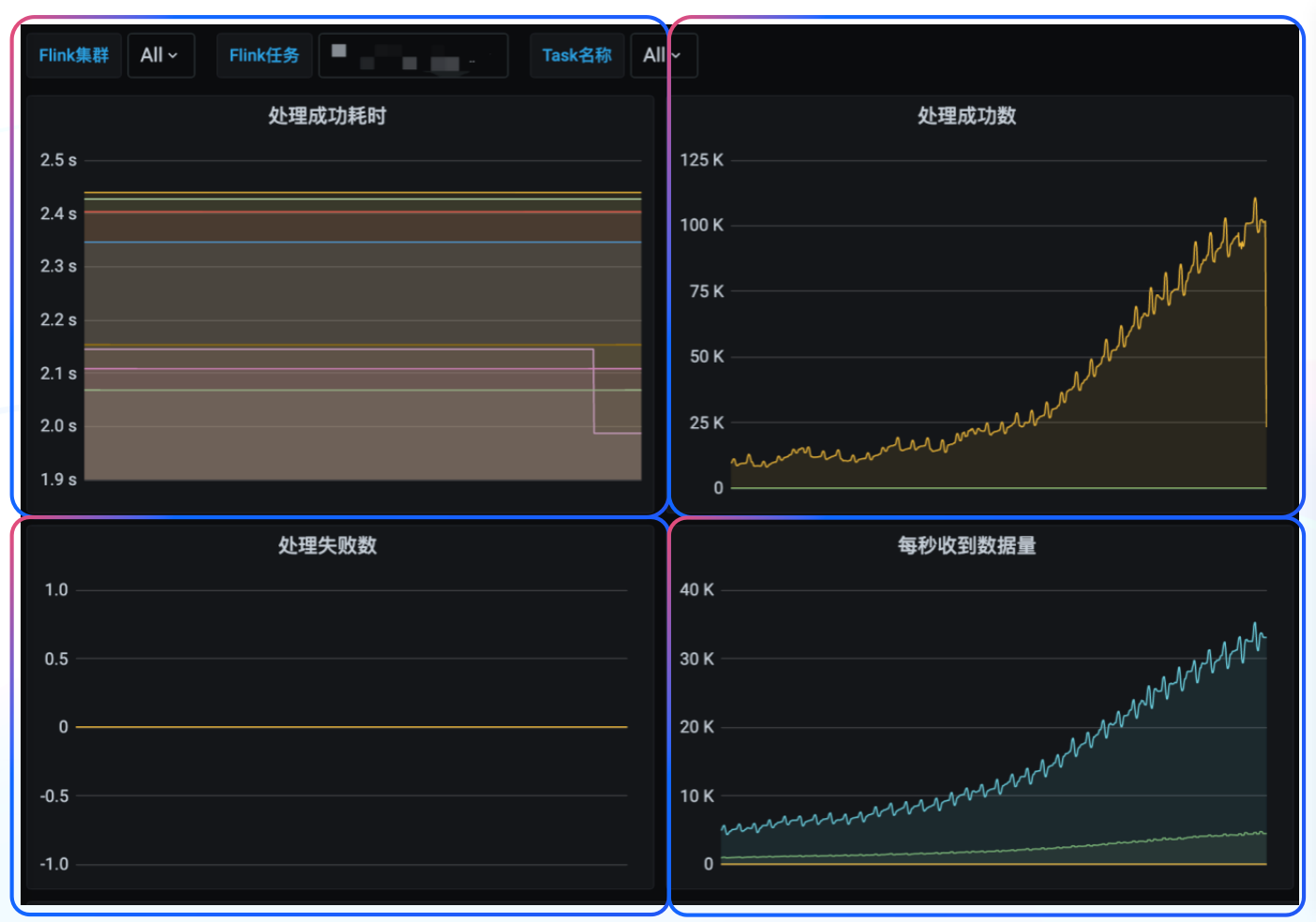

-在集群监控层面,我们采用了社区提供的监控模板,从集群指标监控、主机指标监控、数据处理监控三个方面出发来搭建 Doris 监控体系。其中集群指标监控和主机指标监控主要根据社区监控说明文档进行监控,以便我们查看集群整体运行的情况。除社区提供的模板之外,我们还新增了有关 Stream Load 的监控指标,比如对当前 Stream Load 数量以及写入数据量的监控,如下图所示:

-

-

-

-除此之外,我们对数据写入 Doris 的时长以及写入的速度也比较关注,根据自身业务的需求,我们对任务写入数据速度、处理数据耗时等数据处理相关指标进行监控,帮助我们及时发现数据写入和读取的异常情况,借助公司内部的报警平台进行监控告警,报警方式支持电话、短信、推推、邮件等

-

-

-

-

-

-## 总结与规划

-

-目前 Apache Doris 主要应用于广告业务场景,**已有数十台集群机器,覆盖近 70% 的实时数据分析场景,实现了全量离线实验平台以及部分离线 DWS 层数据查询加速。当前日均新增数据规模可以达到百亿级别,在大部分实时场景中,其查询延迟在 1s 内**。同时,Apache Doris 的成功落地使得我们完成了实时数仓在 OLAP 引擎上的统一。Doris 优异的分析性能及简单易用的特点,也使得数仓架构更加简洁。

-

-未来我们将对 Doris 集群进行扩展,根据业务优先级进行资源隔离,完善资源管理机制,并计划将 Doris 应用到 360商业化内部更广泛的业务场景中,充分发挥 Doris 在 OLAP 场景的优势。最后我们将更加深入的参与到 Doris 社区中来,积极回馈社区,与 Doris 并肩同行,共同进步!

diff --git a/i18n/zh-CN/docusaurus-plugin-content-blog/Annoucing.md b/i18n/zh-CN/docusaurus-plugin-content-blog/Annoucing.md

deleted file mode 100644

index 29e78a6902c..00000000000

--- a/i18n/zh-CN/docusaurus-plugin-content-blog/Annoucing.md

+++ /dev/null

@@ -1,74 +0,0 @@

----

-{

- 'title': '开源实时分析型数据库 Apache Doris 正式成为顶级项目',

- 'summary': 'Apache Doris 是一个基于 MPP 的现代化、高性能、实时的分析型数据库,以极速易用的特点被人们所熟知,仅需亚秒级响应时间即可返回海量数据下的查询结果,不仅可以支持高并发的点查询场景,也能支持高吞吐的复杂分析场景。基于此,Apache Doris 在多维报表、用户画像、即席查询、实时大屏等诸多业务领域都能得到很好应用。',

- 'date': '2022-06-16',

- 'author': '陈明雨',

- 'tags': ['重大新闻'],

-}

----

-

-<!--

-Licensed to the Apache Software Foundation (ASF) under one

-or more contributor license agreements. See the NOTICE file

-distributed with this work for additional information

-regarding copyright ownership. The ASF licenses this file

-to you under the Apache License, Version 2.0 (the

-"License"); you may not use this file except in compliance

-with the License. You may obtain a copy of the License at

-

- http://www.apache.org/licenses/LICENSE-2.0

-

-Unless required by applicable law or agreed to in writing,

-software distributed under the License is distributed on an

-"AS IS" BASIS, WITHOUT WARRANTIES OR CONDITIONS OF ANY

-KIND, either express or implied. See the License for the

-specific language governing permissions and limitations

-under the License.

--->

-

-Apache Doris 是一个基于 MPP 的现代化、高性能、实时的分析型数据库,以极速易用的特点被人们所熟知,仅需亚秒级响应时间即可返回海量数据下的查询结果,不仅可以支持高并发的点查询场景,也能支持高吞吐的复杂分析场景。基于此,Apache Doris 在多维报表、用户画像、即席查询、实时大屏等诸多业务领域都能得到很好应用。

-

-Apache Doris 最早是诞生于百度内部广告报表业务的 Palo 项目,2017 年正式对外开源,2018 年 7 月由百度捐赠给 Apache 基金会进行孵化,之后在 Apache 导师的指导下由孵化器项目管理委员会成员进行孵化和运营。

-

-我们很自豪 Doris 能够顺利从 Apache 孵化器毕业,这是一个重要的里程碑。在整个孵化阶段,依靠 Apache 理念的指导和孵化器导师的帮助,我们学会了如何以 Apache 的方式去发展我们的项目与社区,也在这一进程中获得了巨大的成长。

-

-目前 Apache Doris 社区已经聚集了来自不同行业近百家企业的 300 余位贡献者,并且每月活跃贡献者人数也接近 100 位。在孵化期间,Apache Doris 一共发布了 8 个重要版本,完成了包括存储引擎升级、向量化执行引擎等诸多重大功能,并正式发布了 1.0 版本。正是依靠这些来自开源贡献者的力量,才使得 Apache Doris 取得了今天的成绩。

-

-与此同时,Apache Doris 如今在中国乃至全球范围内都拥有着极为广泛的用户群体,截止目前, Apache Doris 已经在全球超过 500 家企业的生产环境中得到应用,在中国市值或估值排行前 50 的互联网公司中,有超过 80% 长期使用 Apache Doris,包括百度、美团、小米、京东、字节跳动、腾讯、快手、网易、微博、新浪、360 等知名公司。同时在一些传统行业如金融、能源、制造、电信等领域也有着丰富的应用。

-

-你可以基于 Apache Doris 快速构建一个简单易用并且性能强大的数据分析平台,非常易于上手,所需要付出的学习成本非常低。并且 Apache Doris 的分布式架构非常简洁,可以极大降低系统运维的工作量,这也是越来越多用户选择 Apache Doris 的关键因素。

-

-作为一款成熟的分析型数据库项目,Apache Doris 有以下优势:

-

-- 性能优异:自带高效的列式存储引擎,减少数据扫描量的同时还实现了超高的数据压缩比。同时 Doris 还提供了丰富的索引结构来加速数据读取与过滤,利用分区分桶裁剪功能,Doris 可以支持在线服务业务的超高并发,单节点最高可支持上千 QPS。更进一步,Apache Doris 结合了向量化执行引擎来充分发挥现代化 CPU 并行计算能力,辅以智能物化视图技术实现预聚合加速,并可以通过查询优化器同时进行基于规划和基于代价的查询优化。通过上述多种方式,实现了极致的查询性能。

-

-- 简单易用:支持标准 ANSI SQL 语法,包括单表聚合、排序、过滤和多表 Join、子查询等,还支持窗口函数、Grouping Set 等复杂 SQL 语法,同时用户可以通过 UDF 和 UDAF 等自定义函数来拓展系统功能。除此以外,Apache Doris 还实现了 MySQL 协议兼容,用户可以通过各类客户端工具来访问 Doris,并支持与 BI 工具的无缝对接。

-

-- 架构精简:系统只有两个 Frontend(FE)和 Backend(BE)两个模块,其中 FE 节点负责用户请求的接入、查询计划的解析、元数据存储及集群管理等工作,BE 节点负责数据存储和查询计划的执行,自身就是一个完备的分布式数据库管理系统,用户无需安装任何第三方管控组件即可运行起 Apache Doris 集群,并且部署和升级过程都非常简易。同时,任一模块都可以支持横向拓展,集群最高可以拓展到数百个节点,支持存储超过 10PB 的超大规模数据。

-

-- 稳定可靠:支持数据多副本存储,集群具备自愈功能,自身的分布式管理框架可以自动管理数据副本的分布、修复和均衡,副本损坏时系统可以自动感知并进行修复。节点扩容时,仅需一条 SQL 命令即可完成,数据分片会自动在节点间均衡,无需人工干预或操作。无论是扩容、缩容、单节点故障还是在升级过程中,系统都无需停止运行,可正常提供稳定可靠的在线服务。

-

-- 生态丰富:提供丰富的数据同步方式,支持快速加载来自本地、Hadoop、Flink、Spark、Kafka、SeaTunnel 等系统中的数据,也可以直接访问 MySQL、PostgreSQL、Oracle、S3、Hive、Iceberg、Elasticsearch 等系统中的数据而无需数据复制。同时存储在 Doris 中的数据也可以被 Spark、Flink 读取,并且可以输出给上游数据应用进行展示分析。

-

-毕业不是最终目标,它是新征程的起点。在过去,我们发起 Doris 的目标是为更多人提供体验更佳的数据分析工具、解决他们数据分析的难题。成为 Apache 顶级项目一方面是对 Apache Doris 社区过去所有贡献者一直以来辛勤工作的肯定,另一方面也意味着我们在 Apache Way 的指引下建立了一个强大的、繁荣的、可持续发展的开源社区。未来我们将会继续以 Apache 方式运作社区,相信会吸引到更多优秀的开源贡献者参与社区中来,社区也会在所有贡献者的帮助下得到进一步成长。

-

-Apache Doris 后续将开展更多富有挑战且有意义的工作,包括新的查询优化器、对湖仓一体化的支持,以及面向云上基础设施的架构演进等等。欢迎更多的开源技术爱好者加入 Apache Doris 的社区,携手共成长。

-

-我们再次由衷地感谢所有参与建设 Apache Doris 社区的贡献者们,以及所有使用 Apache Doris 并不断提出改进建议的用户们。同时也感谢一路走来,不断鼓励、支持和帮助过我们的孵化器导师、IPMC 成员以及各个开源项目社区的朋友们。

-

-**Apache Doris GitHub:**

-

-[https://github.com/apache/doris](https://github.com/apache/doris)

-

-**Apache Doris website:**

-

-[http://doris.apache.org](http://doris.apache.org)

-

-**Please contact us via:**

-

-[dev@doris.apache.org.](dev@doris.apache.org.)

-

-**See How to subscribe:**

-

-[https://doris.apache.org/zh-CN/community/subscribe-mail-list](https://doris.apache.org/zh-CN/community/subscribe-mail-list/)

diff --git a/i18n/zh-CN/docusaurus-plugin-content-blog/BestPractice_Kwai.md b/i18n/zh-CN/docusaurus-plugin-content-blog/BestPractice_Kwai.md

deleted file mode 100644

index 69f57c1d457..00000000000

--- a/i18n/zh-CN/docusaurus-plugin-content-blog/BestPractice_Kwai.md

+++ /dev/null

@@ -1,181 +0,0 @@

----

-{

- 'title': 'Doris on Es在快手商业化的最佳实践',

- 'language": "zh',

- 'summary': "快手商业化报表引擎为外部广告主提供广告投放效果的实时多维分析报表在线查询服务,以及为内部各商业化系统提供多维分析报表查询服务,致力于解决多维分析报表场景的高性能、高并发、高稳定的查询问题。早期Druid on Es的架构含有诸多弊端,通过调研我们选择了Doris on Es的数仓解决方案。使用Doris 之后,查询变得简单。我们仅需要按天同步事实表和维表,在查询的同时 Join即可。通过Doris替代Druid、Clickhouse的方案,基本覆盖了我们使用Druid 时的所有场景,大大提高了海量数据的聚合分析能力。在Apache Doris的使用过程中,我们还发现了一些意想不到的收益:例如,Routine Load和 Broker Load的导入方式较为简单,提升了查询速度;数据占用空间大幅降低;Doris支持MySQL协议,方便了数据分析师自助取数绘图等。",

- 'date': '2022-12-14',

- 'author': '贺祥',

- 'tags': ['最佳实践']

-}

----

-

-<!--

-Licensed to the Apache Software Foundation (ASF) under one

-or more contributor license agreements. See the NOTICE file

-distributed with this work for additional information

-regarding copyright ownership. The ASF licenses this file

-to you under the Apache License, Version 2.0 (the

-"License"); you may not use this file except in compliance

-with the License. You may obtain a copy of the License at

-

- http://www.apache.org/licenses/LICENSE-2.0

-

-Unless required by applicable law or agreed to in writing,

-software distributed under the License is distributed on an

-"AS IS" BASIS, WITHOUT WARRANTIES OR CONDITIONS OF ANY

-KIND, either express or implied. See the License for the

-specific language governing permissions and limitations

-under the License.

--->

-

-> 作者:贺祥,数据架构高级工程师,快手商业化团队

-

-

-

-# 1 关于快手

-

-## 1.1 快手

-

-快手(HKG: 1024)是一个短视频和潮流社交网络。发现有趣的短片,通过生活中的录音、视频、玩日常挑战或喜欢最好的动效模版和视频来为虚拟社区做出贡献。用短视频分享生活,并从数十种神奇的效果和滤镜中选择喜欢的方式。

-

-## 1.2 快手商业化报表引擎

-

-快手商业化报表引擎为外部广告主提供广告投放效果的实时多维分析报表在线查询服务,以及为内部各商业化系统提供多维分析报表查询服务,致力于解决多维分析报表场景的高性能、高并发、高稳定的查询问题。

-

-# 2 初期架构

-

-## 2.1 需求背景

-

-传统 OLAP 引擎应对多维分析时更多是以预建模的方式,通过构建数据立方体(Cube)对事实数据进行下钻、上卷、切片、切块等操作。现代 OLAP 分析引入了关系模型的理念,在二维关系表中描绘数据。而在建模过程中,往往有两种建模方式,一是采用宽表模型、将多张表的数据通过 Join 写入进一张宽表中,另一种方式是采用星型模型、将数据表区分为事实表和维度表、查询时对事实表与维度表进行 Join 。

-以上两种方案各有部分优缺点:

-

-宽表模型:

-

-采取空间换时间的思路,理论上都是维表主键为唯一 ID 来填充所有维度,冗余存储了多条维度数据。其优势在于查询时非常方便,无需关联额外维表,性能表现更佳。其弊端在于如果有维度数据变化,需要对全表数据进行重刷,无法支撑高频的 Update。

-

-星型模型:

-

-维度数据与事实数据完全分离,维度数据往往用专门的引擎存储 (如 MySQL、Elasticsearch 等),查询时通过主键关联查询维度数据,其优势在于维度数据变化不影响事实数据、可支持高频 Update 操作。其弊端在于查询逻辑相对更复杂,且多表 Join 可能导致性能受损。

-

-## 2.2 业务需求

-

-在快手的业务场景中,商业化报表引擎承载了外部广告主实时查询广告投放效果的需求,在构建报表引擎时,我们期望可以满足如下要求:

-- 超大数据量:单表原始数据每天增量百亿

-- 查询高 QPS:平均 QPS千级别

-- 高稳定性要求:在线服务要求稳定性4个9

-最为重要的是,由于维度数据经常发生变更,维度表需要支持高达上千 QPS 的 Update 操作,同时还要进一步支持模糊匹配、分词检索等需求。

-基于以上需求,我们选择了星型模型来建模,并以 Apache Druid 和 Elasticsearch 为核心构建了早期的报表引擎架构。

-

-## 2.3 初期架构:基于Apache Druid的架构

-

-我们选择了引擎结合的方式,用Elasticsearch适配Druid引擎来实现。在数据写入阶段,我们通过Flink对数据进行分钟级预聚合,利用Kafka对数据进行小时级别的数据预聚合。在数据查询中,App端发起查询需求,对RE Front统一接口进行查询,Re Query根据引擎适配,向维表引擎(Elasticsearch和MySQL)及扩展引擎分别发起查询。

-

-Druid则是一款基于时序的查询引擎,支持数据实时摄入,用来存储和查询大量的事实数据。而选用Elasticsearch作为维度数据存储引擎,主要是因为如下原因:

-- 支持高频实时更新,可以支撑上千 QPS的 Update操作

-- 支持分词模糊检索,适用于快手的业务

-- 支持量级较高的维表数据,不用像MySQL数据库一样做分库分表才能满足

-- 支持数据同步监控,同时拥有检查和恢复的服务

-

-## 2.4 报表引擎

-

-报表引擎架构整体分为REFront 和 REQuery两层,REMeta为独立的元数据管理模块。报表引擎在REQuery内部实现MEM Join。支持Druid引擎中的事实数据与ES引擎中的维度数据做关联查询。为上层业务提供虚拟的cube表查询。屏蔽复杂的跨引擎管理查询逻辑。

-

-

-

-## 3 基于Apache Doris的架构

-

-## 3.1 架构遗留的问题

-

-首先,我们在使用报表引擎时,发现了这样的一个问题。Mem Join是单机实现与串行执行,到单次从ES中拉取的数据量超过10W时,响应时间已经接近10s,用户体验差。而且单节点实现大规模数据Join处理,内存消耗大,有Full GC风险。

-

-其次,Druid的Lookup Join了功能不够完善是一个较大的问题,不能完全满足真实业务需求。

-

-## 3.2 选型调研

-

-于是我们对业界常见的 OLAP 数据库进行了调研,其中最具代表性的为 Apache Doris和 Clickhouse。在进一步的调研中我们发现,Apache Doris在大宽表Join的能力更强。ClickHouse能够支持 Broadcast 基于内存的Join,但是对于大数据量千万级以上大宽表的Join,ClickHouse 的性能表现不好。Doris 和 Clickhouse 都支持明细数据存储,但Clickhouse支持的并发度较低,相反Doris支持高并发低延时的查询服务,单机最高支持上千QPS。在并发增加时,线性扩充FE和BE即可支持。而Clickhouse的数据导入没有事务支持功能,无法实现exactly once语义,对标准sql的支持也是有限的。相比之下,Doris提供了数据导入的事务支持和原子性,Doris 自身能够保证不丢不重的订阅 Kafka 中的消息,即 Exactly-Once 消费语义。ClickHouse使用门槛高、运维成本高和分布式能力弱,需要较多的定制化和较深的技术实力也

是另一个难题,Doris则不同,只有FE、BE两个核心组件,外 [...]

-

-由此看来Doris可以比较好的提升Join的性能,在迁移成本、横向扩容、并发程度等其他方面也比较优秀。不过在高频Update上,Elasticsearch具有先天的优势。

-

-通过 Doris 创建 ES 外表的方式来同时应对高频Upate和Join性能问题,会是比较理想的解决方案。

-

-## 3.3 Doris+Doris on ES完美配合

-

-Doris on ES 的查询性能究竟如何呢?

-

-首先,Apache Doris 是一个基于MPP 架构的实时分析型数据库,性能强劲、横向扩展能力能力强。Doris on ES构建在这个能力之上,并且对查询做了大量的优化。其次,在这些之上,融合Elasticsearch的能力之后,我们还对查询功能做出了大量的优化:

-- Shard级别并发

-- 行列扫描自动适配,优先列式扫描

-- 顺序读取,提前终止

-- 两阶段查询变为一阶段查询

-- Join场景使用Broadcast Join,对于小批量数据Join特别友好

-

-

-

-## 3.4 基于Doris on Elasticsearch的架构实现

-

-### 3.4.1 数据链路升级

-

-数据链路的升级适配比较简单。第一步,由Doris构建新的Olap表,配置好物化视图。第二步,基于之前事实数据的kafka topic启动routine load,导入实时数据。第三步,从Hive中通broker load导入离线数据。最后一步,通过Doris创建Es外表。

-

-

-

-### 3.4.2 报表引擎适配升级

-

-

-

-注:上图关联的mysql维表是基于未来规划,目前主要是ES做维表引擎

-

-报表引擎适配

-- 抽象基于Doris的星型模型虚拟cube表

-- 适配cube表查询解析,智能下推

-- 支持灰度上线

-

-# 4 线上表现

-

-## 4.1 查询响应时间

-

-### 4.1.1 事实表查询表现对比

-

-Druid

-

-

-

-Doris

-

-

-

-99分位耗时Druid大概为270ms,Doris为150ms,延时下降45%

-

-### 4.1.2 Join场景下cube表查询表现对比

-

-Druid

-

-

-

-Doris

-

-

-

-99分位耗时Druid大概为660ms,Doris为440ms,延时下降33%

-

-### 4.1.3 收益总结

-

-- P99整体耗时下降35%左右

-- 资源节省50%左右

-- 去除报表引擎内部Mem Join的复杂逻辑,下沉至Doris通过DOE实现,在大查询场景下(维表结果超过10W,性能提升超过10倍,10s->1s)

-- 更丰富的查询语义(原本Mem Join实现比较简单,不支持复杂的查询)

-

-# 5 总结与未来规划

-

-在快手商业化业务里面,维度数据与事实数据Join查询是非常普遍的。使用Doris 之后,查询变得简单。我们仅需要按天同步事实表和维表,在查询的同时 Join即可。通过Doris替代Druid、Clickhouse的方案,基本覆盖了我们使用Druid 时的所有场景,大大提高了海量数据的聚合分析能力。在Apache Doris的使用过程中,我们还发现了一些意想不到的收益:例如,Routine Load和 Broker Load的导入方式较为简单,提升了查询速度;数据占用空间大幅降低;Doris支持MySQL协议,方便了数据分析师自助取数绘图等。

-

-尽管Doris on ES的解决方案比较成功的满足了我们的报表业务,ES外表映射仍然需要手工建表。但Apache Doris于近日完成了最新版本V1.2.0的发布,新版本功能新增了Multi-Catlog,提供了无缝接入Hive、ES、Hudi、Iceberg 等外部数据源的能力。用户可以通过 CREATE CATALOG 命令连接到外部数据源,Doris 会自动映射外部数据源的库、表信息。如此一来,以后我们就不需要再手动创建Es外表完成映射,大大节省了开发的时间成本,提升了研发效率。而全面向量化、Ligt Schema Change、Merge-on-Write、Java UDF等其他新功能的实现,也让我们对Apache Doris有了全新的期待。祝福Apache Doris!

-

-

-# 联系我们

-

-官网:http://doris.apache.org

-

-Github:https://github.com/apache/doris

-

-dev邮件组:dev@doris.apache.org

diff --git a/i18n/zh-CN/docusaurus-plugin-content-blog/Compaction.md b/i18n/zh-CN/docusaurus-plugin-content-blog/Compaction.md

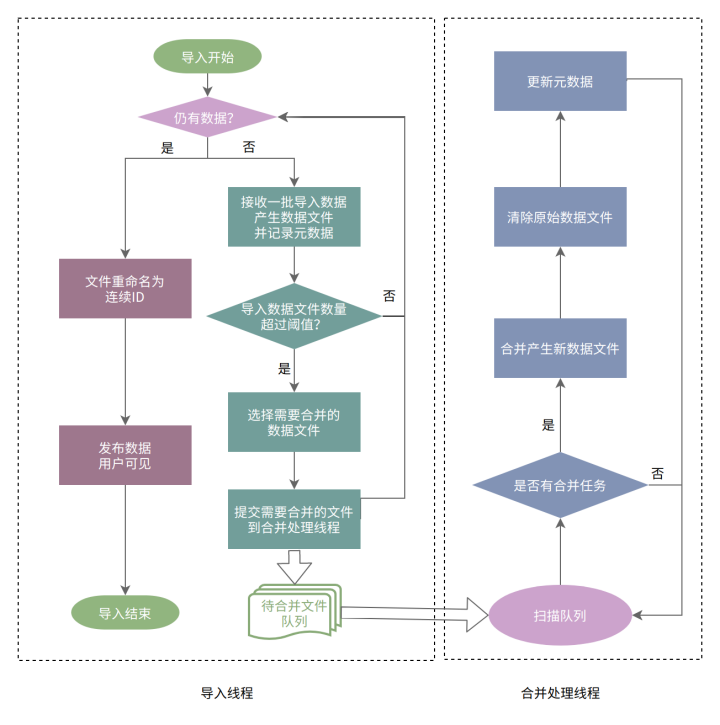

deleted file mode 100644

index 277aeb9a3d7..00000000000

--- a/i18n/zh-CN/docusaurus-plugin-content-blog/Compaction.md

+++ /dev/null

@@ -1,219 +0,0 @@

----

-{

- 'title': '资源消耗降低 90%,速度提升 50%,解读 Apache Doris Compaction 最新优化与实现',

- 'summary': "在 Apache Doris 最新的 1.2.2 版本和即将发布的 2.0.0 版本中,我们对系统 Compaction 能力进行了全方位增强,在触发策略、执行方式、工程实现以及参数配置上都进行了大幅优化,在实时性、易用性与稳定性得到提升的同时更是彻底解决了查询效率问题。",

- 'date': '2023-06-09',

- 'author': 'Apache Doris',

- 'tags': ['技术解析'],

-}

-

-

----

-

-<!--

-Licensed to the Apache Software Foundation (ASF) under one

-or more contributor license agreements. See the NOTICE file

-distributed with this work for additional information

-regarding copyright ownership. The ASF licenses this file

-to you under the Apache License, Version 2.0 (the

-"License"); you may not use this file except in compliance

-with the License. You may obtain a copy of the License at

-

- http://www.apache.org/licenses/LICENSE-2.0

-

-Unless required by applicable law or agreed to in writing,

-software distributed under the License is distributed on an

-"AS IS" BASIS, WITHOUT WARRANTIES OR CONDITIONS OF ANY

-KIND, either express or implied. See the License for the

-specific language governing permissions and limitations

-under the License.

--->

-

-# 背景

-

-LSM-Tree( Log Structured-Merge Tree)是数据库中最为常见的存储结构之一,其核心思想在于充分发挥磁盘连续读写的性能优势、以短时间的内存与 IO 的开销换取最大的写入性能,数据以 Append-only 的方式写入 Memtable、达到阈值后冻结 Memtable 并 Flush 为磁盘文件、再结合 Compaction 机制将多个小文件进行多路归并排序形成新的文件,最终实现数据的高效写入。

-

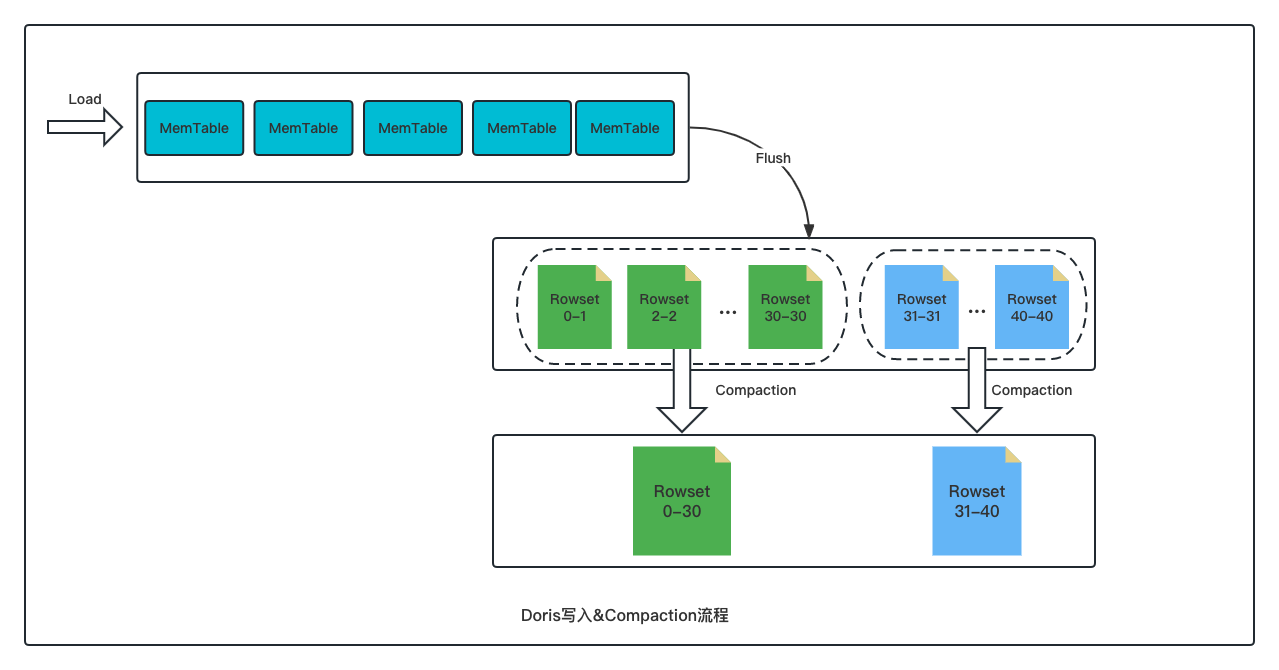

-[Apache Doris](https://github.com/apache/doris) 的存储模型也是采用类似的 LSM-Tree 数据模型。用户不同批次导入的数据会先写入内存结构,随后在磁盘上形成一个个的 Rowset 文件,每个 Rowset 文件对应一次数据导入版本。而 Doris 的 Compaction 则是负责将这些 Rowset 文件进行合并,将多个 Rowset 小文件合并成一个 Rowset 大文件。

-

-

-

-在此过程中 Compaction 发挥着以下作用:

-

-- 每个 Rowset 内的数据是按主键有序的,但 Rowset 与 Rowset 之间数据是无序的,Compaction 会将多个 Rowset 的数据从无序变为有序,提升数据在读取时的效率;

-- 数据以 Append-only 的方式进行写入,因此 Delete、Update 等操作都是标记写入,Compaction 会将标记的数据进行真正删除或更新,避免数据在读取时进行额外的扫描及过滤;

-- 在 Aggregate 模型上,Compaction 还可以将不同 Rowset 中相同 Key 的数据进行预聚合,减少数据读取时的聚合计算,进一步提升读取效率。

-

-# 问题与思考

-

-尽管 Compaction 在写入和查询性能方面发挥着十分关键的作用,但 Compaction 任务执行期间的写放大问题以及随之而来的磁盘 I/O 和 CPU 资源开销,也为系统稳定性和性能的充分发挥带来了新的挑战。

-

-在用户真实场景中,往往面临着各式各样的数据写入需求,并行写入任务的多少、单次提交数据量的大小、提交频次的高低等,各种场景可能需要搭配不同的 Compaction 策略。而不合理的 Compaction 策略则会带来一系列问题:

-

-- Compaction 任务调度不及时导致大量版本堆积、Compaction Score 过高,最终导致写入失败(-235/-238);

-- Compaction 任务执行速度慢,CPU 消耗高;

-- Compaction 任务内存占用高,影响查询性能甚至导致 BE OOM;

-

-与此同时,尽管 Apache Doris 提供了多个参数供用户进行调整,但相关参数众多且语义复杂,用户理解成本过高,也为人工调优增加了难度。

-

-

-

-

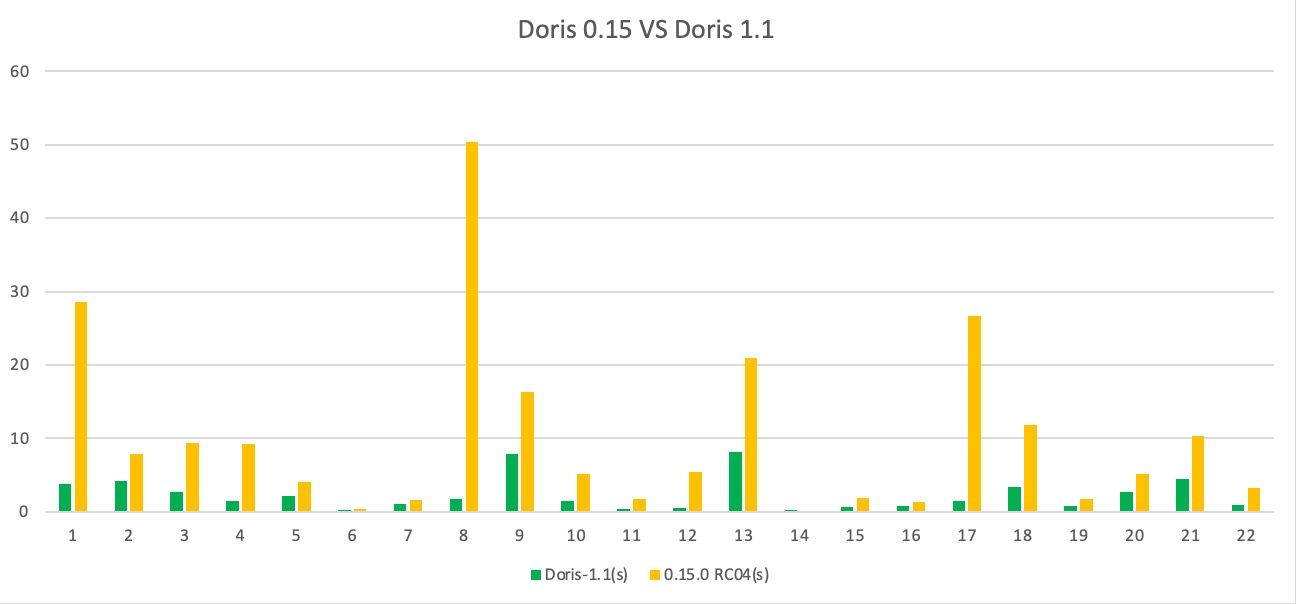

-基于以上问题,从 Apache Doris 1.1.0 版本开始,我们增加了主动触发式 QuickCompaction、引入了 Cumulative Compaction 任务的隔离调度并增加了小文件合并的梯度合并策略,对高并发写入和数据实时可见等场景都进行了针对性优化。

-

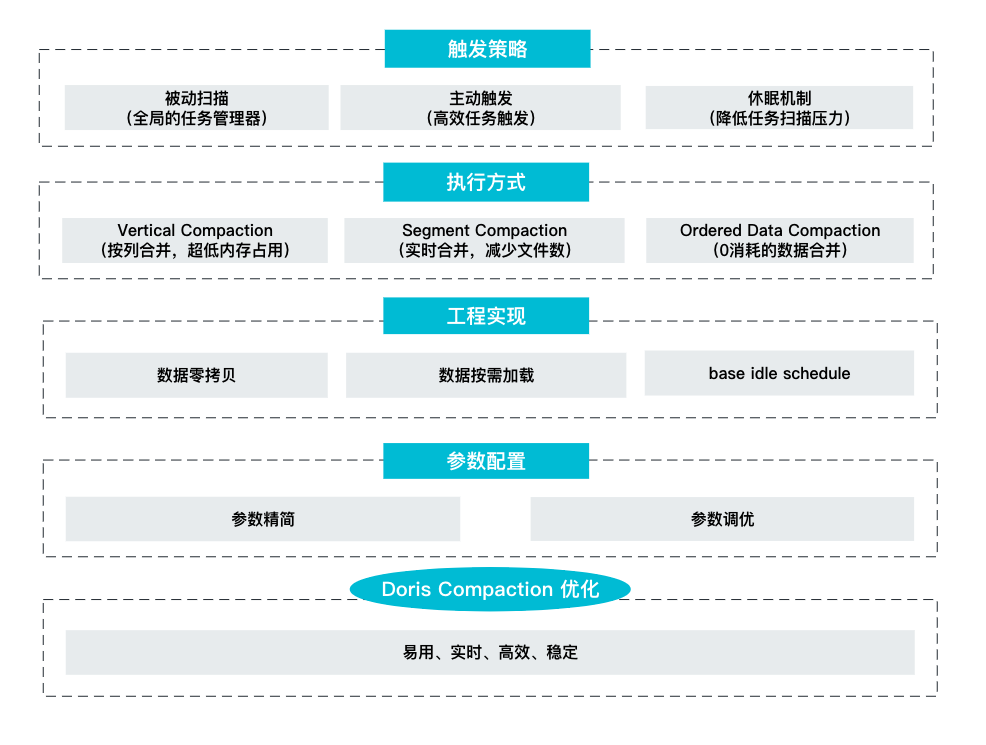

-而在 Apache Doris 最新的 1.2.2 版本和即将发布的 2.0.0 版本中,我们对系统 Compaction 能力进行了全方位增强,**在触发策略、执行方式 、 工程实现以及参数配置上都进行了大幅优化,** **在实时性、易用性与稳定性得到提升的同时更是彻底解决了查询效率问题**。

-

-# Compaction 优化与实现

-

-在设计和评估 Compaction 策略之时,我们需要综合权衡 Compaction 的任务模型和用户真实使用场景,核心优化思路包含以下几点:

-

-- **实时性和高效性**。Compaction 任务触发策略的实时性和任务执行方式的高效性直接影响到了查询执行的速度,版本堆积将导致 Compaction Score 过高且触发自我保护机制,导致后续数据写入失败。

-- **稳定性**。Compaction 任务对系统资源的消耗可控,不会因 Compaction 任务带来过多的内存与 CPU 开销造成系统不稳定。

-- **易用性**。由于 Compaction 任务涉及调度、策略、执行多个逻辑单元,部分特殊场景需要对 Compaction 进行调优,因此需要 Compaction 涉及的参数能够精简明了,指导用户快速进行场景化的调优。

-

-具体在实现过程中,包含了触发策略、执行方式、工程实现以及参数配置这四个方面的优化。

-

-

-

-### Compaction 触发策略

-

-调度策略决定着 Compaction 任务的实时性。在 Apache Doris 2.0.0 版本中,我们在主动触发和被动扫描这两种方式的基础之上引入了 Tablet 休眠机制,力求在各类场景均能以最低的消耗保障最高的实时性。

-

-#### 主动触发

-

-主动触发是一种最为实时的方式,在数据导入的阶段就检查 Tablet 是否有待触发的 Compaction 任务,这样的方式保证了 Compaction 任务与数据导入任务同步进行,在新版本产生的同时就能够立即触发数据合并,能够让 Tablet 版本数维持在一个非常稳定的状态。主动触发主要针对增量数据的 Compaction (Cumulative Compaction),存量数据则依赖被动扫描完成。

-

-#### 被动扫描

-

-与主动触发不同,被动扫描主要负责触发大数据量的 Base Compaction 任务。Doris 通过启动一个后台线程,对该节点上所有的 Tablet 元数据进行扫描,根据 Tablet Compaction 任务的紧迫程度进行打分,选择得分最高的 Tablet 触发 Compaction 任务。这样的全局扫描模式能够选出最紧急的 Tablet 进行 Compaction,但一般其执行周期较长,所以需要配合主动触发策略实施。

-

-#### 休眠机制

-

-频繁的元信息扫描会导致大量的 CPU 资源浪费。因此在 Doris 2.0.0 版本中我们引入了 Tablet 休眠机制,来降低元数据扫描带来的 CPU 开销。通过对长时间没有 Compaction 任务的 Tablet 设置休眠时间,一段时间内不再对该 Tablet 进行扫描,能够大幅降低任务扫描的压力。同时如果休眠的 Tablet 有突发的导入,通过主动触发的方式也能顾唤醒 Compaction 任务,不会对任务的实时性有任何影响。

-

-通过上述的主动扫描+被动触发+休眠机制,使用最小的资源消耗,保证了 Compaction 任务触发的实时性。

-

-### Compaction 执行方式

-

-在 Doris 1.2.2 版本中中,我们引入了两种全新的 Compaction 执行方式:

-

-- Vertical Compaction,用以彻底解决 Compaction 的内存问题以及大宽表场景下的数据合并;

-- Segment Compaction,用以彻底解决上传过程中的 Segment 文件过多问题;

-

-而在即将发布的 Doris 2.0.0 版本,我们引入了 Ordered Data Compaction 以提升时序数据场景的数据合并能力。

-

-#### Vertical Compaction

-

-在之前的版本中,Compaction 通常采用行的方式进行,每次合并的基本单元为整行数据。由于存储引擎采用列式存储,行 Compaction 的方式对数据读取极其不友好,每次 Compaction 都需要加载所有列的数据,内存消耗极大,而这样的方式在宽表场景下也将带来内存的极大消耗。

-

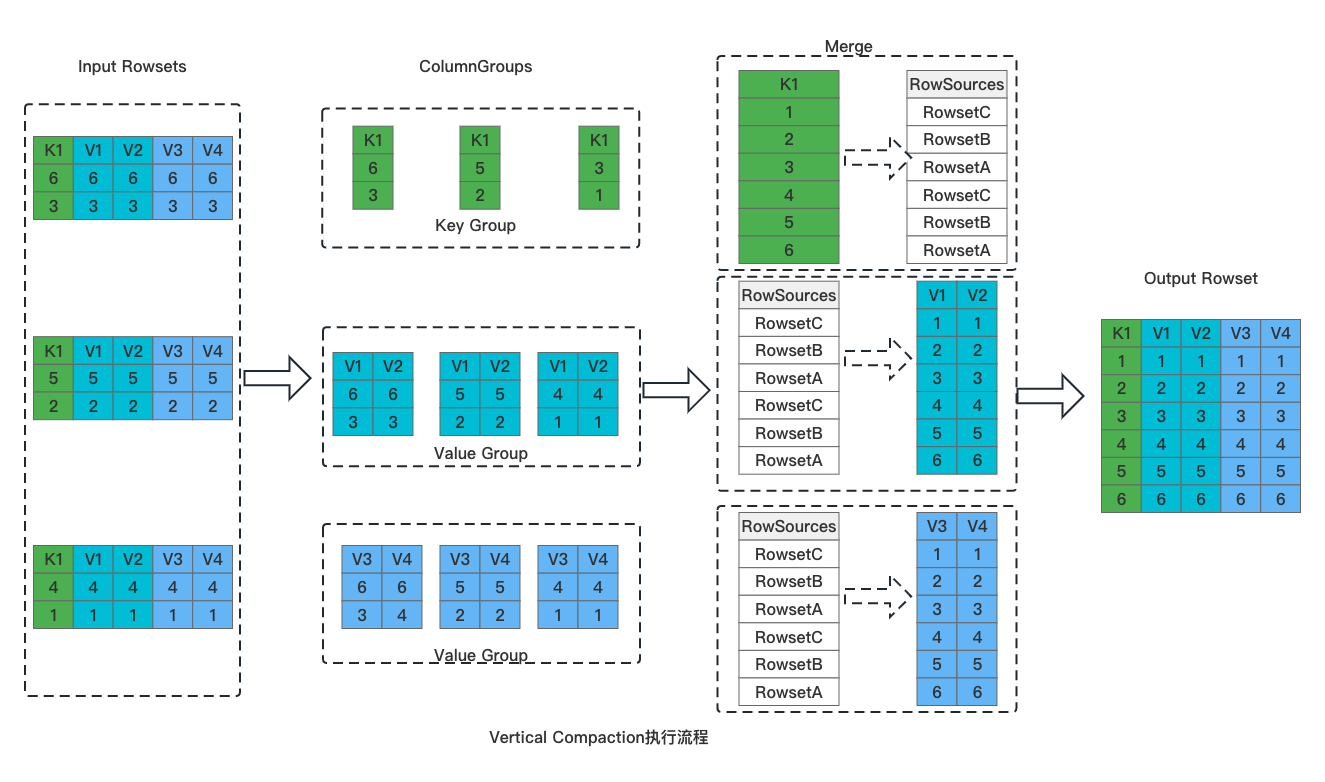

-针对上述问题,我们在 Doris 1.2.2 版本中实现了对列式存储更加友好的 Vertical Compaction,具体执行流程如下图:

-

-

-

-整体分为如下几个步骤:

-

-1. 切分列组。将输入 Rowset 按照列进行切分,所有的 Key 列一组、Value 列按 N 个一组,切分成多个 Column Group;

-1. Key 列合并。Key 列的顺序就是最终数据的顺序,多个 Rowset 的 Key 列采用堆排序进行合并,产生最终有序的 Key 列数据。在产生 Key 列数据的同时,会同时产生用于标记全局序 RowSources。

-1. Value 列的合并。逐一合并 Column Group 中的 Value 列,以 Key 列合并时产生的 RowSources 为依据对数据进行排序。

-1. 数据写入。数据按列写入,形成最终的 Rowset 文件。

-

-由于采用了按列组的方式进行数据合并,Vertical Compaction 天然与列式存储更加贴合,使用列组的方式进行数据合并,单次合并只需要加载部分列的数据,因此能够极大减少合并过程中的内存占用。在实际测试中,**Vertical** **C** **ompaction 使用内存仅为原有 Compaction 算法的 1/10,同时 Compaction 速率提升 15%。**

-

-Vertical Compaction 在 1.2.2 版本中默认关闭状态,需要在 BE 配置项中设置 `enable_vertical_compaction=true` 开启该功能。

-

-相关PR:https://github.com/apache/doris/pull/14524

-

-

-

-

-

-

-

-#### Segment Compaction

-

-在数据导入阶段,Doris 会在内存中积攒数据,到达一定大小时 Flush 到磁盘形成一个个的 Segment 文件。大批量数据导入时会形成大量的 Segment 文件进而影响后续查询性能,基于此 Doris 对一次导入的 Segment 文件数量做了限制。当用户导入大量数据时,可能会触发这个限制,此时系统将反馈 -238 (TOO_MANY_SEGMENTS) 同时终止对应的导入任务。Segment compaction 允许我们在导入数据的同时进行数据的实时合并,以有效控制 Segment 文件的数量,增加系统所能承载的导入数据量,同时优化后续查询效率。具体流程如下所示:

-

-

-

-在新增的 Segment 数量超过一定阈值(例如 10)时即触发该任务执行,由专门的合并线程异步执行。通过将每组 10个 Segment 合并成一个新的 Segment 并删除旧 Segment,导入完成后的实际 Segment 文件数量将下降 10 倍。Segment Compaction 会伴随导入的过程并行执行,在大数据量导入的场景下,能够在不显著增加导入时间的前提下大幅降低文件个数,提升查询效率。

-

-Segment Compaction 在 1.2.2 版本中默认关闭状态,需要在 BE 配置项中设置 ` enable_segcompaction = true `开启该功能。

-

-相关 PR : https://github.com/apache/doris/pull/12866

-

-

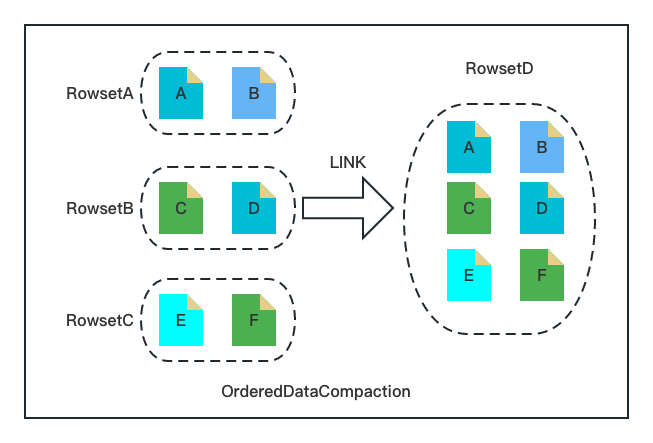

-#### Ordered Data Compaction

-

-随着越来越多用户在时序数据分析场景应用 Apache Doris,我们在 Apache Doris 2.0.0 版本实现了全新的 Ordered Data Compaction。

-

-时序数据分析场景一般具备如下特点:数据整体有序、写入速率恒定、单次导入文件大小相对平均。针对如上特点,Ordered Data Compaction 无需遍历数据,跳过了传统 Compaction 复杂的读数据、排序、聚合、输出的流程,通过文件 Link 的方式直接操作底层文件生成 Compaction 的目标文件。

-

-

-

-

-Ordered Data Compaction 执行流程包含如下几个关键阶段:

-

-1. 数据上传阶段。记录 Rowset 文件的 Min/Max Key,用于后续合并 Rowset 数据交叉性的判断;

-1. 数据检查阶段。检查参与 Compaction 的 Rowset 文件的有序性与整齐度,主要通过数据上传阶段的 Min /Max Key 以及文件大小进行判断。

-1. 数据合并阶段。将输入 Rowset 的文件硬链接到新 Rowset,然后构建新 Rowset 的元数据(包括行数,Size,Min/Max Key 等)。

-

-可以看到上述阶段与传统的 Compaction 流程完全不一样,只需要文件的 Link 以及内存元信息的构建,极其简洁、轻量。**针对时序场景设计的 Ordered Data Compaction 能够在毫秒级别完成大规模的 Compaction 任务,其内存消耗几乎为** ******0,对用户极其友好。**

-

-Ordered Data Compaction 在 2.0.0 版本中默认开启状态,如需调整在 BE 配置项中修改 ` enable_segcompaction `即可。

-

-使用方式:BE 配置 `enable_ordered_data_compaction=true`

-

-### Compaction 工程实现

-

-除了上述在触发策略和 Compaction 算法上的优化之外,Apache Doris 2.0.0 版本还对 Compaction 的工程实现进行了大量细节上的优化,包括数据零拷贝、按需加载、Idle Schedule 等。

-

-#### **数据零拷贝**

-

-Doris 采用分层的数据存储模型,数据在 BE 上可以分为如下几层:Tablet -> Rowset -> Segment -> Column -> Page,数据需要经过逐层处理。由于 Compaction 每次参与的数据量大,数据在各层之间的流转会带来大量的 CPU 消耗,在新版本中我们设计并实现了全流程无拷贝的 Compaction 逻辑,Block 从文件加载到内存中后,后续无序再进行拷贝,各个组件的使用都通过一个 BlockView 的数据结构完成,这样彻底的解决了数据逐层拷贝的问题,将 Compaction 的效率再次提升了 5%。

-

-#### **按需加载**

-

-Compaction 的逻辑本质上是要将多个无序的 Rowset 合并成一个有序的 Rowset,在大部分场景中,Rowset 内或者 Rowset 间的数据并不是完全无序的,可以充分利用局部有序性进行数据合并,在同一时间仅需加载有序文件中的第一个,这样随着合并的进行再逐渐加载。利用数据的局部有序性按需加载,能够极大减少数据合并过程中的内存消耗。

-

-#### **Idle schedule**

-

-在实际运行过程中,由于部分 Compaction 任务占用资源多、耗时长,经常出现因为 Compaction 任务影响查询性能的 Case。这类 Compaction 任务一般存在于 Base compaction 中,具备数据量大、执行时间长、版本合并少的特点,对任务执行的实时性要求不高。在新版本中,针对此类任务开启了线程 Idle Schedule 特性,降低此类任务的执行优先级,避免 Compaction 任务造成线上查询的性能波动。

-

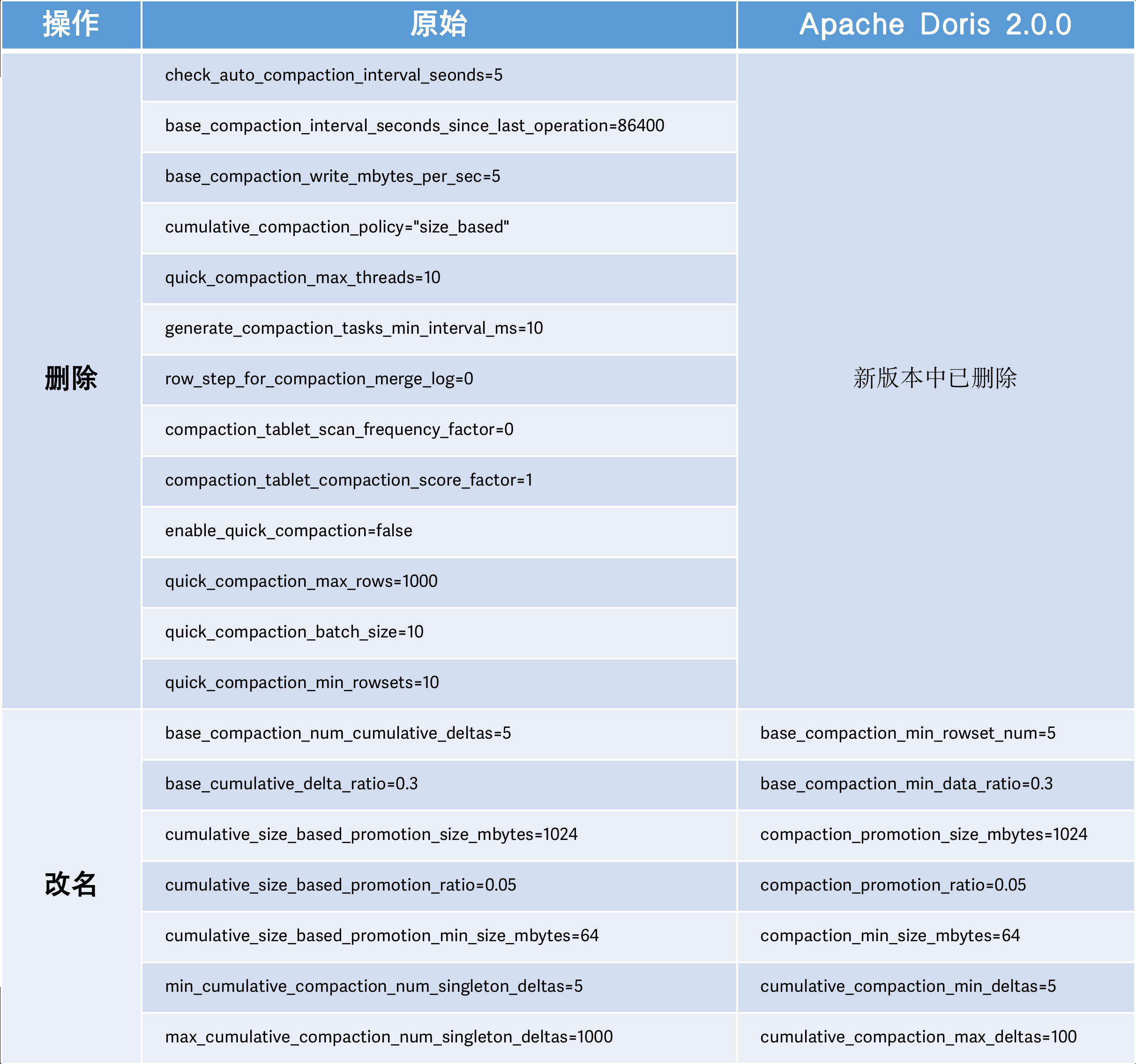

-### 易用性

-

-在 Compaction 的易用性方面,Doris 2.0.0 版本进行了系统性优化。结合长期以来 Compaction 调优的一些经验数据,默认配置了一套通用环境下表现最优的参数,同时大幅精简了 Compaction 相关参数及语义,方便用户在特殊场景下的 Compaction 调优。

-

-

-

-# 总结规划

-

-通过上述一系列的优化方式, 全新版本在 Compaction 过程中取得了极为显著的改进效果。在 ClickBench 性能测试中,**新版本 Compaction 执行速度** **达到 30w row/s,相较于旧版本** **提升** **了** **50** **%** **;资源消耗降幅巨大,** **内存占用仅为原先的 10%** 。高并发数据导入场景下,Compaction Score 始终保持在 50 左右,且系统表现极为平稳。同时在时序数据场景中,Compaction 写放大系数降低 90%,极大提升了可承载的写入吞吐量。

-

-后续我们仍将进一步探索迭代优化的空间,主要的工作方向将聚焦在自动化、可观测性以及执行效率等方向上:

-

-1. 自动化调优。针对不同的用户场景,无需人工干预,系统支持进行自动化的 Compaction 调优;

-1. 可观测性增强。收集统计 Compaction 任务的各项指标,用于指导自动化以及手动调优;

-1. 并行 Vertical Compaction。通过 Value 列并发执行,进一步提升 Vertical Compaction 效率。

-

-以上方向的工作都已处于规划或开发中,如果有小伙伴对以上方向感兴趣,也欢迎参与到社区中的开发来。期待有更多人参与到 Apache Doris 社区的建设中 ,欢迎你的加入!

-

-# 作者介绍:

-

-一休,Apache Doris contributor,SelectDB 资深研发工程师

-

-张正宇,Apache Doris contributor,SelectDB 资深研发工程师

-

-

-

-**# 相关链接:**

-

-**SelectDB 官网**:

-

-https://selectdb.com

-

-**Apache Doris 官网**:

-

-http://doris.apache.org

-

-**Apache Doris Github**:

-

-https://github.com/apache/doris

diff --git a/i18n/zh-CN/docusaurus-plugin-content-blog/Data Lakehouse.md b/i18n/zh-CN/docusaurus-plugin-content-blog/Data Lakehouse.md

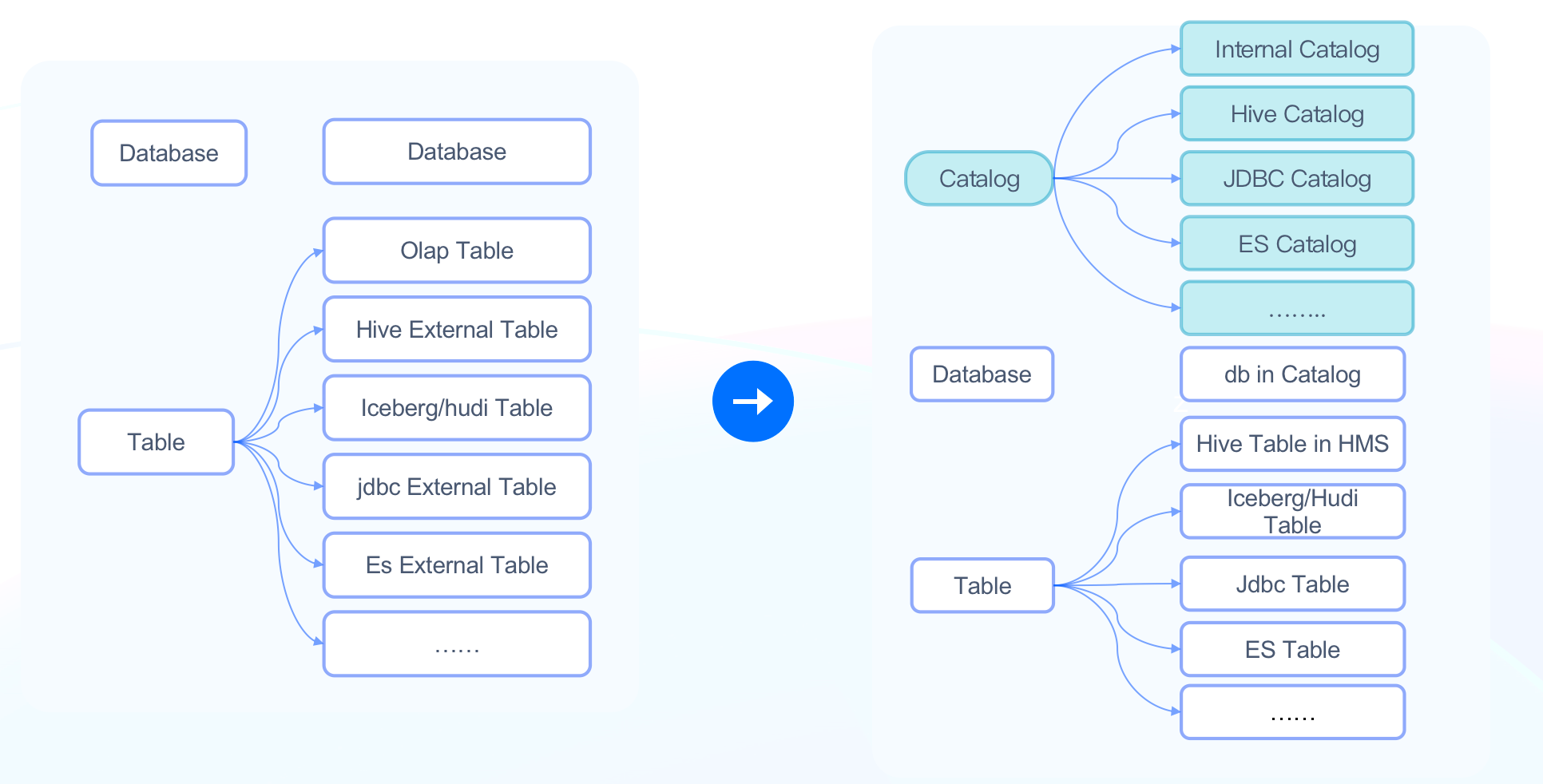

deleted file mode 100644

index 2d23d8c2c12..00000000000

--- a/i18n/zh-CN/docusaurus-plugin-content-blog/Data Lakehouse.md

+++ /dev/null

@@ -1,290 +0,0 @@

----

-{

- 'title': '查询性能较 Trino:Presto 3-10 倍提升!Apache Doris 极速数据湖分析深度解读',

- 'summary': "Apache Doris 已经完全具备了构建极速易用的 Lakehouse 架构的能力,并且也已在多个用户的真实业务场景中得到验证和推广,希望为用户带来湖仓查询加速

-统一数据分析网关、统一数据集成和更加开放的数据生态。",

- 'date': '2023-03-14',

- 'author': 'Apache Doris',

- 'tags': ['技术解析'],

-}

----

-

-<!--

-Licensed to the Apache Software Foundation (ASF) under one

-or more contributor license agreements. See the NOTICE file

-distributed with this work for additional information

-regarding copyright ownership. The ASF licenses this file

-to you under the Apache License, Version 2.0 (the

-"License"); you may not use this file except in compliance

-with the License. You may obtain a copy of the License at

-

- http://www.apache.org/licenses/LICENSE-2.0

-

-Unless required by applicable law or agreed to in writing,

-software distributed under the License is distributed on an

-"AS IS" BASIS, WITHOUT WARRANTIES OR CONDITIONS OF ANY

-KIND, either express or implied. See the License for the

-specific language governing permissions and limitations

-under the License.

--->

-

-从上世纪 90 年代初 Bill Inmon 在《building the Data Warehouse》一书中正式提出数据仓库这一概念,至今已有超过三十年的时间。在最初的概念里,数据仓库被定义为「一个面向主题的、集成的、相对稳定的、反映历史变化的数据集合,用于支持管理决策」,而数据湖最初是为了解决数仓无法存储海量且异构的数据而构建的集中式存储系统。

-

-时代的发展与用户数据应用诉求的演进,催生了数据架构的不断革新,也衍生了更复杂的技术形态。可以清晰看到现代数据架构从计算到存储都在向着融合统一的方向发展,新的数据湖范式被提出,这也是 Lakehouse 诞生的背景。作为一种全新的、开放式的数据管理架构,Lakehouse 提供了更强的数据分析能力与更好的数据治理能力,也保留了数据湖的灵活性与开放式存储,为用户带来更多价值:

-

-- 从存储的角度:统一数据集成,避免冗余存储以及跨系统间 ETL 带来的繁重工程和失败风险;

-- 从治理的角度:支持 ACID、Schema Evolution 与 Snapshot,数据与元数据皆可治理;

-- 从应用的角度:多引擎访问支持、可插拔,通过统一接口进行数据访问,同时适用于多种工作负载 Workload;

-- ……

-

-如果我们把 Lakehouse 从系统层面进行解构,会发现除了需要 Apache Iceberg、Apache Hudi 以及 Delta Lake 等数据湖表格式(Table Format)以外,**高性能分析引擎更是充分发挥湖上数据价值的关键**。

-

-作为一款极速易用的开源实时 OLAP 数据库,Apache Doris 自 0.15 版本即开始尝试在 Apache Iceberg 之上探索与数据湖的能力结合。而经过多个版本的优化迭代,Apache Doris 在数据湖分析已经取得了长足的进展,一方面在数据读取、查询执行以及优化器方面做了诸多优化,另一方面则是重构了整体的元数据连接框架并支持了更多外部存储系统。因此 Apache Doris 已经完全具备了构建极速易用的 Lakehouse 架构的能力,并且也已在多个用户的真实业务场景中得到验证和推广,我们希望通过 Apache Doris 能为用户在更多场景中带来价值:

-

-1. **湖仓查询加速**

-

- 利用 Apache Doris 优秀的分布式执行引擎以及本地文件缓存,结合数据湖开放格式提供的多种索引能力,对湖上数据及文件提供优秀的查询加速能力,相比 Hive、Presto、Spark 等查询引擎实现数倍的性能提升。

-

-1. **统一数据分析网关**

-

- 利用 Apache Doris 构建完善可扩展的数据源连接框架,便于快速接入多类数据源,包括各种主流关系型数据库、数据仓库以及数据湖引擎(例如 Hive、Iceberg、Hudi、Delta Lake、Flink Table Store 等),提供基于各种异构数据源的快速查询和写入能力,将 Apache Doris 打造成统一的数据分析网关。

-

-1. **统一数据集成**

-

- 基于可扩展的连接框架,增强 Doris 在数据集成方面的能力,让数据更便捷的被消费和处理。用户可以通过 Doris 对上游的多种数据源进行统一的增量、全量同步,并利用 Doris 的数据处理能力对数据进行加工和展示,也可以将加工后的数据写回到数据源,或提供给下游系统进行消费。该能力使得 Apache Doris 能够成为业务的统一数据枢纽,降低数据流转成本。

-

-1. **更加开放的数据生态**

-

- 通过对 Parquet/ORC 等数据格式以及开放的元数据管理机制的支持,用户不用再担心数据被特定数据库引擎锁定,无法被其他引擎访问,也不用再为数据的迁移和格式转换付出高昂的时间和算力成本,降低用户的数据迁移成本和对数据流通性的顾虑,更便捷、放心地享受 Apache Doris 带来的极速数据分析体验。

-

-

-

-

-基于以上的场景定位,我们需要进一步去思考在构建 Lakehouse 过程中需要如何去设计和改造系统,具体包括:

-

-- 如何支持更丰富的数据源访问以及更便捷的元数据获取方式;

-- 如何提升湖上数据的查询执行性能;

-- 如何实现更灵活的资源调度与负载管理;

-

-因此本文将重点介绍 Apache Doris 在 Lakehouse 上的设计思路和技术细节,同时会为大家介绍后续的发展规划。

-

-# 元数据连接与数据访问

-

-截至最新的 1.2.2 版本,Apache Doris 已经提供了十余种的数据湖格式和外部数据源的访问支持。同时也支持通过 Table Value Function 直接对文件进行分析。

-

-

-

-

-

-

-为了支持这些数据源,Apache Doris 分别在**元数据连接**和**数据访问**两方面做了大量的架构调整和性能优化 **。**

-

-## 元数据连接

-

-元数据包括数据源的库、表信息、分区信息、索引信息、文件信息等。不同数据源的元信息格式、组织方式各有不同,对于元数据的连接需要解决以下问题:

-

-1. **统一的元数据结构**:屏蔽不同数据源的元数据差异。

-1. **可扩展的元数据连接框架**:低成本、快速地接入数据源。

-1. **高效的元数据访问能力**:提供可靠、高效的元数据访问性能,并支持实时同步元数据变更。

-1. **自定义鉴权服务**:能够灵活对接外部的权限管理系统,降低业务迁移成本。

-

-### **统一的元数据结构**

-

-在过去 Apache Doris 的元数据只有 Database(数据库) 和 Table(表)两个层级,当外部数据目录 Schema 发生变化或者外部数据目录的 Database 或 Table 非常多时,需要用户手工进行一一映射,维护量非常大。因此在 Apache Doris 1.2.0 版本中新增了 Catalog(数据目录)层级,提供了快速接入外部数据源的能力。

-

-

-

-Catalog 层级的引入解决以下问题:

-

-1. **数据源层级的映射**:用户不再需要在 Database、Table 层级进行一一映射,可以通过 Catalog 直接映射整个数据源,自动同步其中的所有元信息,简化元数据映射逻辑